typora-root-url: D:\机构文档\os图片

QEMU有两种运行模式: User mode 模式,即用户态模拟,如 qemu-riscv64 程序,能够模拟不同处理器的用户态指令的执行,并可以直接解析ELF可执行文件,加载运行那些为不同处理器编译的用户级Linux应用程序(ELF可执行文件);在翻译并执行不同应用程序中的不同处理器的指令时,如果碰到是系统调用相关的汇编指令,它会把不同处理器(如RISC-V)的Linux系统调用转换为本机处理器(如x86-64)上的Linux系统调用,这样就可以让本机Linux完成系统调用,并返回结果(再转换成RISC-V能识别的数据)给这些应用。 System mode 模式,即系统态模式,如 qemu-system-riscv64 程序,能够模拟一个完整的基于不同CPU的硬件系统,包括处理器、内存及其他外部设备,支持运行完整的操作系统。

// os/src/main.rs

#![feature(llvm_asm)]

const SYSCALL_EXIT: usize = 93;

fn syscall(id: usize, args: [usize; 3]) -> isize {

let mut ret: isize;

unsafe {

llvm_asm!("ecall"

: "={x10}" (ret)

: "{x10}" (args[0]), "{x11}" (args[1]), "{x12}" (args[2]), "{x17}" (id)

: "memory"

: "volatile"

);

}

ret

}

pub fn sys_exit(xstate: i32) -> isize {

syscall(SYSCALL_EXIT, [xstate as usize, 0, 0])

}

#[no_mangle]

extern "C" fn _start() {

sys_exit(9);

}

- 一条运行os代码的指令

cargo build --target riscv64gc-unknown-none-elf

首先封装一下对 SYSCALL_WRITE 系统调用。这个是 Linux 操作系统内核提供的系统调用,其 ID 就是 SYSCALL_WRITE。

const SYSCALL_WRITE: usize = 64;

pub fn sys_write(fd: usize, buffer: &[u8]) -> isize {

syscall(SYSCALL_WRITE, [fd, buffer.as_ptr() as usize, buffer.len()])

}然后实现基于 Write Trait 的数据结构,并完成 Write Trait 所需要的 write_str 函数,并用 print 函数进行包装。

- 启动OS:硬件启动后,会有一段代码(一般统称为bootloader)对硬件进行初始化,让包括内核在内的系统软件得以运行;

- OS准备好应用程序执行的环境:要运行该应用程序的时候,内核分配相应资源,将程序代码和数据载入内存,并赋予 CPU 使用权,由此应用程序可以运行;

- 应用程序开始执行:程序员编写的代码是应用程序的一部分,它需要标准库/核心库进行一些初始化工作后才能运行。

在QEMU模拟的硬件中,物理内存和外设都是通过对内存读写的方式来进行访问,下面列出了QEMU模拟的物理内存空间。

// qemu/hw/riscv/virt.c

static const struct MemmapEntry {

hwaddr base;

hwaddr size;

} virt_memmap[] = {

[VIRT_DEBUG] = { 0x0, 0x100 },

[VIRT_MROM] = { 0x1000, 0xf000 },

[VIRT_TEST] = { 0x100000, 0x1000 },

[VIRT_RTC] = { 0x101000, 0x1000 },

[VIRT_CLINT] = { 0x2000000, 0x10000 },

[VIRT_PCIE_PIO] = { 0x3000000, 0x10000 },

[VIRT_PLIC] = { 0xc000000, VIRT_PLIC_SIZE(VIRT_CPUS_MAX * 2) },

[VIRT_UART0] = { 0x10000000, 0x100 },

[VIRT_VIRTIO] = { 0x10001000, 0x1000 },

[VIRT_FLASH] = { 0x20000000, 0x4000000 },

[VIRT_PCIE_ECAM] = { 0x30000000, 0x10000000 },

[VIRT_PCIE_MMIO] = { 0x40000000, 0x40000000 },

[VIRT_DRAM] = { 0x80000000, 0x0 },

};VIRT_DRAM:DRAM的内存起始地址是 0x80000000 ,缺省大小为128MB。在本书中一般限制为8MB。

VIRT_UART0:串口相关的寄存器起始地址是 0x10000000 ,范围是 0x100 ,我们通过访问这段特殊的区域来实现字符输入输出的管理与控制。

在RISC-V64计算机启动执行前,先在其模拟的内存中放置好BootLoader程序和操作系统的二进制代码

-bios $(BOOTLOADER)这个参数意味着硬件内存中的固定位置0x80000000处放置了一个BootLoader程序–RustSBI(戳 附录 C:深入机器模式:RustSBI 可以进一步了解RustSBI。)。-device loader,file=$(KERNEL_BIN),addr=$(KERNEL_ENTRY_PA)这个参数表示硬件内存中的特定位置$(KERNEL_ENTRY_PA)放置了操作系统的二进制代码$(KERNEL_BIN)。$(KERNEL_ENTRY_PA)的值是0x80200000

当我们执行包含上次参数的qemu-system-riscv64软件,就意味给这台虚拟的RISC-V64计算机加电了。此时,CPU的其它通用寄存器清零, 而PC寄存器会指向 0x1000 的位置。 这个 0x1000 位置上是CPU加电后执行的第一条指令(固化在硬件中的一小段引导代码),它会很快跳转到 0x80000000 处, 即RustSBI的第一条指令。RustSBI完成基本的硬件初始化后, 会跳转操作系统的二进制代码 $(KERNEL_BIN) 所在内存位置 0x80200000 ,执行操作系统的第一条指令。 这时我们的编写的操作系统才开始正式工作。

os代码的执行指令(模板)

# 编译生成ELF格式的执行文件

$ cargo build --release

Compiling os v0.1.0 (/media/chyyuu/ca8c7ba6-51b7-41fc-8430-e29e31e5328f/thecode/rust/os_kernel_lab/os)

Finished release [optimized] target(s) in 0.15s

# 把ELF执行文件转成bianary文件

$ rust-objcopy --binary-architecture=riscv64 target/riscv64gc-unknown-none-elf/release/os --strip-all -O binary target/riscv64gc-unknown-none-elf/release/os.bin

#加载运行

$ qemu-system-riscv64 -machine virt -nographic -bios ../bootloader/rustsbi-qemu.bin -device loader,file=target/riscv64gc-unknown-none-elf/release/os.bin,addr=0x80200000

# 无法退出,风扇狂转,感觉碰到死循环我们可以通过 链接脚本 (Linker Script) 调整链接器的行为,使得最终生成的可执行文件的内存布局符合我们的预期。 我们修改 Cargo 的配置文件来使用我们自己的链接脚本 os/src/linker.ld 而非使用默认的内存布局:

// os/.cargo/config

[build]

target = "riscv64gc-unknown-none-elf"

[target.riscv64gc-unknown-none-elf]

rustflags = [

"-Clink-arg=-Tsrc/linker.ld", "-Cforce-frame-pointers=yes"

]具体的链接脚本 os/src/linker.ld 如下:

OUTPUT_ARCH(riscv)

ENTRY(_start)

BASE_ADDRESS = 0x80200000;

SECTIONS

{

. = BASE_ADDRESS;

skernel = .;

stext = .;

.text : {

*(.text.entry)

*(.text .text.*)

}

. = ALIGN(4K);

etext = .;

srodata = .;

.rodata : {

*(.rodata .rodata.*)

*(.srodata .srodata.*)

}

. = ALIGN(4K);

erodata = .;

sdata = .;

.data : {

*(.data .data.*)

*(.sdata .sdata.*)

}

. = ALIGN(4K);

edata = .;

.bss : {

*(.bss.stack)

sbss = .;

*(.bss .bss.*)

*(.sbss .sbss.*)

}

. = ALIGN(4K);

ebss = .;

ekernel = .;

/DISCARD/ : {

*(.eh_frame)

}

}冒号前面表示最终生成的可执行文件的一个段的名字,花括号内按照放置顺序描述将所有输入目标文件的哪些段放在这个段中,每一行格式为 <ObjectFile>(SectionName),表示目标文件 ObjectFile 的名为 SectionName 的段需要被放进去。我们也可以 使用通配符来书写 <ObjectFile> 和 <SectionName> 分别表示可能的输入目标文件和段名。因此,最终的合并结果是,在最终可执行文件 中各个常见的段 .text, .rodata .data, .bss 从低地址到高地址按顺序放置,每个段里面都包括了所有输入目标文件的同名段, 且每个段都有两个全局符号给出了它的开始和结束地址(比如 .text 段的开始和结束地址分别是 stext 和 etext )。

如何做到执行环境的初始化代码被放在内存上以 0x80200000 开头的区域上?

在链接脚本第 7 行,我们将当前地址设置为

BASE_ADDRESS也即0x80200000,然后从这里开始往高地址放置各个段。第一个被放置的 是.text,而里面第一个被放置的又是来自entry.asm中的段.text.entry,这个段恰恰是含有两条指令的执行环境初始化代码, 它在所有段中最早被放置在我们期望的0x80200000处。

关于rust运行和gdb调试的指令

# 在一个终端执行如下命令:

$ qemu-system-riscv64 -machine virt -nographic -bios ../bootloader/rustsbi-qemu.bin -device loader,file=target/riscv64gc-unknown-none-elf/release/os.bin,addr=0x80200000 -S -s

# 在另外一个终端执行如下命令:

$ rust-gdb target/riscv64gc-unknown-none-elf/release/os

(gdb) target remote :1234

(gdb) break *0x80200000

(gdb) x /16i 0x80200000

(gdb) si需要有一段正确配置栈空间布局

为了说明如何实现正确的栈,我们需要讨论这样一个问题:应用函数调用所需的栈放在哪里?

需要有一段代码来分配并栈空间,并把

sp寄存器指向栈空间的起始位置(注意:栈空间是从上向下push数据的)。 所以,我们要写一小段汇编代码entry.asm来帮助建立好栈空间。 从链接脚本第 32 行开始,我们可以看出entry.asm中分配的栈空间对应的段.bss.stack被放入到可执行文件中的.bss段中的低地址中。在后面虽然有一个通配符.bss.*,但是由于链接脚本的优先匹配规则它并不会被匹配到后面去。 这里需要注意的是地址区间 [sbss,ebss) 并不包括栈空间,其原因后面再进行说明。代码来分配并栈空间,并把sp寄存器指向栈空间的起始位置(注意:栈空间是从上向下push数据的)。 所以,我们要写一小段汇编代码entry.asm来帮助建立好栈空间。 从链接脚本第 32 行开始,我们可以看出entry.asm中分配的栈空间对应的段.bss.stack被放入到可执行文件中的.bss段中的低地址中。在后面虽然有一个通配符.bss.*,但是由于链接脚本的优先匹配规则它并不会被匹配到后面去。 这里需要注意的是地址区间 [sbss,ebss) 并不包括栈空间,其原因后面再进行说明。

.section .text.entry

.globl _start

_start:

la sp,boot_stack_top

call rust_main

.section .bss.stack

globl boot_stack

boot_stack:

.space 4096*16

.globl boot_stack_top

boot_stack_top:

由于一般应用程序的 .bss 段在程序正式开始运行之前会被执环境(系统库或操作系统内核)固定初始化为零,因此在 ELF 文件中,为了节省磁盘空间,只会记录 .bss 段的位置,且应用程序的假定在它执行前,其 .bss段 的数据内容都已是 全0 。 如果这块区域不是全零,且执行环境也没提前清零,那么会与应用的假定矛盾,导致程序出错。

const SBI_CONSOLE_PUTCHAR: usize = 1;

pub fn console_putchar(c: usize) {

syscall(SBI_CONSOLE_PUTCHAR, [c, 0, 0]);

}

impl Write for Stdout {

fn write_str(&mut self, s: &str) -> fmt::Result {

//sys_write(STDOUT, s.as_bytes());

for c in s.chars() {

console_putchar(c as usize);

}

Ok(())

}

}把系统调用转变成为rust sbi调用

错误处理函数的更新

// os/src/main.rs

#![feature(panic_info_message)]

#[panic_handler]

fn panic(info: &PanicInfo) -> ! {

if let Some(location) = info.location() {

println!("Panicked at {}:{} {}", location.file(), location.line(), info.message().unwrap());

} else {

println!("Panicked: {}", info.message().unwrap());

}

shutdown()

}RISC-V 指令各部分含义

在大多数只与通用寄存器打交道的指令中, rs 表示 源寄存器 (Source Register), imm 表示 立即数 (Immediate), 是一个常数,二者构成了指令的输入部分;而 rd 表示 目标寄存器 (Destination Register),它是指令的输出部分。rs 和 rd 可以在 32 个通用寄存器 x0~x31 中选取。但是这三个部分都不是必须的,某些指令只有一种输入类型,另一些指令则没有输出部分

ret指令的解析 ra(x1)(寄存器存储跳转后的下一条指令地址)

事实上在函数返回的时候我们常常使用一条 伪指令 (Pseudo Instruction) 跳转回调用之前的位置: ret 。它会被汇编器翻译为 jalr x0, 0(x1),含义为跳转到寄存器 ra 保存的物理地址,由于 x0 是一个恒为 0 的寄存器,在 rd 中保存这一步被省略。

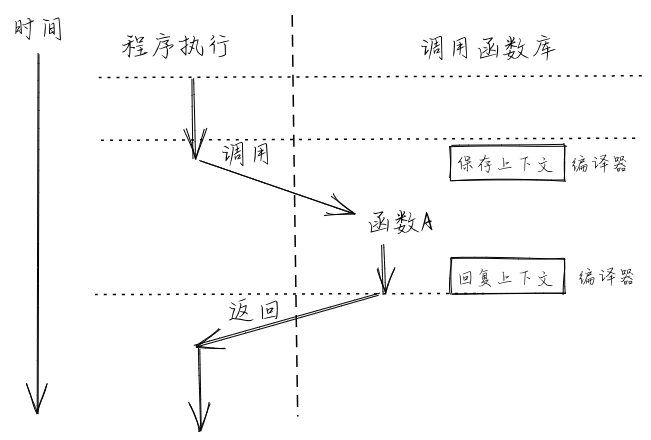

函数调用上下文

在一个函数调用子函数的前后,ra 寄存器的值不能发生变化。但实际上, 这并不仅仅局限于 ra 一个寄存器,而是作用于所有的通用寄存器。这是因为,编译器是独立编译每个函数的,因此一个函数并不能知道它所调用的 子函数修改了哪些寄存器。而站在一个函数的视角,在调用子函数的过程中某些寄存器的值被覆盖的确会对它接下来的执行产生影响。因此这是必要的。 我们将由于函数调用,在控制流转移前后需要保持不变的寄存器集合称之为 函数调用上下文 (Context) 或称 活动记录 (Activation Record),利用这一概念 ,则在函数调用前后需要保持不变的寄存器集合被称为函数调用上下文。

RISC-V 架构上的 C 语言调用规范

RISC-V 架构上的 C 语言调用规范可以在 这里 找到。 它对通用寄存器的使用做出了如下约定:

| 寄存器组 | 保存者 | 功能 |

|---|---|---|

| a0~a7 | 调用者保存 | 用来传递输入参数。特别的 a0 和 a1 用来保存返回值。 |

| t0~t6 | 调用者保存 | 作为临时寄存器使用,在函数中可以随意使用无需保存。 |

| s0~s11 | 被调用者保存 | 作为临时寄存器使用,保存后才能在函数中使用。 |

剩下的 5 个通用寄存器情况如下:

- zero(x0) 之前提到过,它恒为零,函数调用不会对它产生影响;

- ra(x1) 是调用者保存的,不过它并不会在每次调用子函数的时候都保存一次,而是在函数的开头和结尾保存/恢复即可,因为在执行期间即使被 覆盖也没有关系。看上去和被调用者保存寄存器保存的位置一样,但是它确实是调用者保存的。

- sp(x2) 是被调用者保存的。这个之后就会提到。

- gp(x3) 和 tp(x4) 在一个程序运行期间都不会变化,因此不必放在函数调用上下文中。它们的用途在后面的章节会提到。

更加详细的内容可以参考 Cornell 的 课件 。

函数调用上下文的保存/恢复时机以及寄存器的选择,但我们并没有详细说明这些寄存器保存在哪里,只是用“内存中的一块区域”草草带过。实际上, 它更确切的名字是 栈 (Stack) 。 sp(x2) 常用来保存 栈指针 (Stack Pointer),它是一个指向了内存中已经用过的位置的一个地址。在 RISC-V 架构中,栈是从高地址到低地址增长的。在一个函数中,作为起始的开场白负责分配一块新的栈空间,其实它只需要知道需要空间的大小,然后将 sp 的值减小相应的字节数即可,于是物理地址区间 新旧[新sp,旧sp) 对应的物理内存便可以被这个函数用来函数调用上下文的保存/恢复 以及其他工作,这块物理内存被称为这个函数的 栈帧 (Stackframe)。同理,函数中作为结尾的收场白负责将开场白分配的栈帧回收,这也仅仅需要 将 sp 的值增加相同的字节数回到分配之前的状态。这也可以解释为什么 sp 是一个被调用者保存寄存器。

它的开头和结尾分别在 sp(x2) 和 fp(s0) 所指向的地址。按照地址从高到低分别有以下内容,它们都是通过 sp 加上一个偏移量来访问的:

- ra 寄存器保存其返回之后的跳转地址,是一个调用者保存寄存器;

- 父亲栈帧的结束地址 fp,是一个被调用者保存寄存器;

- 其他被调用者保存寄存器 s1~s11;

- 函数所使用到的局部变量。

- 已初始化数据段保存程序中那些已初始化的全局数据,分为

.rodata和.data两部分。前者存放只读的全局数据,通常是一些常数或者是 常量字符串等;而后者存放可修改的全局数据。 - 未初始化数据段

.bss保存程序中那些未初始化的全局数据,通常由程序的加载者代为进行零初始化,也即将这块区域逐字节清零; - 堆 (heap) 区域用来存放程序运行时动态分配的数据,如 C/C++ 中的 malloc/new 分配到的数据本体就放在堆区域,它向高地址增长;

- 栈区域 stack 不仅用作函数调用上下文的保存与恢复,每个函数作用域内的局部变量也被编译器放在它的栈帧内。它向低地址增长。

在一个函数的视角中,它能够访问的变量包括以下几种:

- 函数的输入参数和局部变量:保存在一些寄存器或是该函数的栈帧里面,如果是在栈帧里面的话是基于当前 sp 加上一个偏移量来访问的;

- 全局变量:保存在数据段

.data和.bss中,某些情况下 gp(x3) 寄存器保存两个数据段中间的一个位置,于是全局变量是基于 gp 加上一个偏移量来访问的。

局部变量与全局变量

在一个函数的视角中,它能够访问的变量包括以下几种:

- 函数的输入参数和局部变量:保存在一些寄存器或是该函数的栈帧里面,如果是在栈帧里面的话是基于当前 sp 加上一个偏移量来访问的;

- 全局变量:保存在数据段

.data和.bss中,某些情况下 gp(x3) 寄存器保存两个数据段中间的一个位置,于是全局变量是基于 gp 加上一个偏移量来访问的。 - 堆上的动态变量:本体被保存在堆上,大小在运行时才能确定。而我们只能 直接 访问栈上或者全局数据段中的 编译期确定大小 的变量。 因此我们需要通过一个运行时分配内存得到的一个指向堆上数据的指针来访问它,指针的位宽确实在编译期就能够确定。该指针即可以作为局部变量 放在栈帧里面,也可以作为全局变量放在全局数据段中。

我们可以将常说的编译流程细化为多个阶段(虽然输入一条命令便可将它们全部完成):

- 编译器 (Compiler) 将每个源文件从某门高级编程语言转化为汇编语言,注意此时源文件仍然是一个 ASCII 或其他编码的文本文件;

- 汇编器 (Assembler) 将上一步的每个源文件中的文本格式的指令转化为机器码,得到一个二进制的 目标文件 (Object File);

- 链接器 (Linker) 将上一步得到的所有目标文件以及一些可能的外部目标文件链接在一起形成一个完整的可执行文件。

每个目标文件都有着自己局部的内存布局,里面含有若干个段。在链接的时候,链接器会将这些内存布局合并起来形成一个整体的内存布局。此外,每个目标文件 都有一个符号表,里面记录着它需要从其他文件中寻找的外部符号和能够提供给其他文件的符号,通常是一些函数和全局变量等。在链接的时候汇编器会将 外部符号替换为实际的地址。

批处理系统 (Batch System) 应运而生。它的核心思想是:将多个程序打包到一起输入计算机。而当一个程序运行结束后,计算机会 自动 加载下一个程序到内存并开始执行。这便是最早的真正意义上的操作系统。

确保操作系统的安全,对应用程序而言,需要限制的主要有两个方面: - 应用程序不能访问任意的地址空间(这个在第四章会进一步讲解,本章不会讲解) - 应用程序不能执行某些可能破会计算机系统的指令(本章的重点)

为了让应用程序获得操作系统的函数服务,采用传统的函数调用方式(即通常的 call 和 ret 指令或指令组合)将会直接绕过硬件的特权级保护检查。所以要设计新的指令:执行环境调用(Execution Environment Call,简称 ecall )和执行环境返回(Execution Environment Return,简称 eret )):

ecall:具有用户态到内核态的执行环境切换能力的函数调用指令(RISC-V中就有这条指令)eret:具有内核态到用户态的执行环境切换能力的函数返回指令(RISC-V中有类似的sret指令)

但硬件具有了这样的机制后,还需要操作系统的配合才能最终完成对操作系统自己的保护。首先,操作系统需要提供相应的控制流,能在执行 eret 前准备和恢复用户态执行应用程序的上下文。其次,在应用程序调用 ecall 指令后,能够保存用户态执行应用程序的上下文,便于后续的恢复;且还要坚持应用程序发出的服务请求是安全的。

RISC-V 架构中一共定义了 4 种特权级:

| 级别 | 编码 | 名称 |

|---|---|---|

| 0 | 00 | 用户/应用模式 (U, User/Application) |

| 1 | 01 | 监督模式 (S, Supervisor) |

| 2 | 10 | H, Hypervisor |

| 3 | 11 | 机器模式 (M, Machine) |

下表中我们给出了 RISC-V 特权级定义的会导致从低特权级到高特权级的各种 异常:

| Interrupt | Exception Code | Description |

|---|---|---|

| 0 | 0 | Instruction address misaligned |

| 0 | 1 | Instruction access fault |

| 0 | 2 | Illegal instruction |

| 0 | 3 | Breakpoint |

| 0 | 4 | Load address misaligned |

| 0 | 5 | Load access fault |

| 0 | 6 | Store/AMO address misaligned |

| 0 | 7 | Store/AMO access fault |

| 0 | 8 | Environment call from U-mode |

| 0 | 9 | Environment call from S-mode |

| 0 | 11 | Environment call from M-mode |

| 0 | 12 | Instruction page fault |

| 0 | 13 | Load page fault |

| 0 | 15 | Store/AMO page fault |

与特权级无关的一般的指令和通用寄存器 x0~x31 在任何特权级都可以任意执行。而每个特权级都对应一些特殊指令和 控制状态寄存器 (CSR, Control and Status Register) ,来控制该特权级的某些行为并描述其状态。当然特权指令不只是具有有读写 CSR 的指令,还有其他功能的特权指令。

如果低优先级下的处理器执行了高优先级的指令,会产生非法指令错误的异常,于是位于高特权级的执行环境能够得知低优先级的软件出现了该错误,这个错误一般是不可恢复的,此时一般它会将上层的低特权级软件终止。这在某种程度上体现了特权级保护机制的作用。

在RISC-V中,会有两类低优先级U模式下运行高优先级S模式的指令:

- 指令本身属于高特权级的指令,如

sret指令(表示从S模式返回到U模式)。 - 指令访问了 S模式特权级下才能访问的寄存器 或内存,如表示S模式系统状态的 控制状态寄存器

sstatus等。

| 指令 | 含义 |

|---|---|

| sret | 从S模式返回U模式。在U模式下执行会产生非法指令异常 |

| wfi | 处理器在空闲时进入低功耗状态等待中断。在U模式下执行会尝试非法指令异常 |

| sfence.vma | 刷新TLB缓存。在U模式下执行会尝试非法指令异常 |

| 访问S模式CSR的指令 | 通过访问 sepc/stvec/scause/sscartch/stval/sstatus/satp等CSR 来改变系统状态。在U模式下执行会尝试非法指令异常 |

在下一节中,我们将看到 在U模式下的用户态应用程序 ,如果执行上述S模式特权指令指令,将会产生非法指令异常,从而看出RISC-V的特权模式设计在一定程度上提供了对操作系统的保护。

-

sfence.vma:刷新TLB缓存。在U模式下执行会尝试非法指令异常

-

访问S模式CSR的指令:通过访问 sepc/stvec/scause/sscartch/stval/sstatus/satp等CSR 来改变系统状态。在U模式下执行会尝试非法指令异常

代码中尝试引入了外部库:

#[macro_use]

extern crate user_lib;

这个外部库其实就是 user 目录下的 lib.rs 以及它引用的若干子模块中。至于这个外部库为何叫 user_lib 而不叫 lib.rs 所在的目录的名字 user ,是因为在 user/Cargo.toml 中我们对于库的名字进行了设置: name = "user_lib" 。它作为 bin 目录下的源程序所依赖的用户库,等价于其他编程语言提供的标准库。

在 user/.cargo/config 中,我们和第一章一样设置链接时使用链接脚本 user/src/linker.ld 。在其中我们做的重要的事情是:

- 将程序的起始物理地址调整为

0x80400000,三个应用程序都会被加载到这个物理地址上运行; - 将

_start所在的.text.entry放在整个程序的开头,也就是说批处理系统只要在加载之后跳转到0x80400000就已经进入了 用户库的入口点,并会在初始化之后跳转到应用程序主逻辑; - 提供了最终生成可执行文件的

.bss段的起始和终止地址,方便clear_bss函数使用。

write和exit系统调用

/// 功能:将内存中缓冲区中的数据写入文件。

/// 参数:`fd` 表示待写入文件的文件描述符;

/// `buf` 表示内存中缓冲区的起始地址;

/// `len` 表示内存中缓冲区的长度。

/// 返回值:返回成功写入的长度。

/// syscall ID:64

fn sys_write(fd: usize, buf: *const u8, len: usize) -> isize;

/// 功能:退出应用程序并将返回值告知批处理系统。

/// 参数:`xstate` 表示应用程序的返回值。

/// 返回值:该系统调用不应该返回。

/// syscall ID:93

fn sys_exit(xstate: usize) -> !;Rust 中的 llvm_asm! 宏的完整格式如下:

llvm_asm!(assembly template

: output operands

: input operands

: clobbers

: options

);const SYSCALL_WRITE: usize = 64;

const SYSCALL_EXIT: usize = 93;

fn syscall(id: usize, args: [usize; 3]) -> isize {

let mut ret: isize; //ret必须是可变绑定,将他和x10寄存器进行绑定,便可以拿到返回值

unsafe {

llvm_asm!("ecall"

: "={x10}" (ret)

: "{x10}" (args[0]), "{x11}" (args[1]), "{x12}" (args[2]), "{x17}" (id)

: "memory"

: "volatile"

);

}

ret

}下面逐行进行说明。

第 7 行指定输出操作数。这里由于我们的系统调用返回值只有一个 isize ,根据调用规范它会被保存在 a0 寄存器中。在双引号内,我们 可以对于使用的操作数进行限制,由于是输出部分,限制的开头必须是一个 = 。我们可以在限制内使用一对花括号再加上一个寄存器的名字告诉 编译器汇编的输出结果会保存在这个寄存器中。我们将声明出来用来保存系统调用返回值的变量 ret 包在一对普通括号里面放在操作数限制的 后面,这样可以把变量和寄存器建立联系。于是,在系统调用返回之后我们就能在变量 ret 中看到返回值了。注意,变量 ret 必须为可变 绑定,否则无法通过编译,这也说明在 unsafe 块内编译器还是会进行力所能及的安全检查。

第 8 行指定输入操作数。由于是输入部分,限制的开头不用加上 = 。同时在限制中设置使用寄存器 a0~a2 来保存系统调用的参数,以及 寄存器 a7 保存 syscall ID ,而它们分别 syscall 的参数变量 args 和 id 绑定。

第 9 行用于告知编译器插入的汇编代码会造成的一些影响以防止编译器在不知情的情况下误优化。常用的使用方法是告知编译器某个寄存器在执行嵌入 的汇编代码中的过程中会发生变化。我们这里则是告诉编译器:程序在执行嵌入汇编代码中指令的时候会修改内存。这能给编译器提供更多信息以生成正确的代码。

第 10 行用于告知编译器将我们在程序中给出的嵌入汇编代码保持原样放到最终构建的可执行文件中。如果不这样做的话,编译器可能会把它和其他代码 一视同仁并放在一起进行一些我们期望之外的优化。为了保证语义的正确性,一些比较关键的汇编代码需要加上该选项。

于是 sys_write 和 sys_exit 只需将 syscall 进行包装:

1// user/src/syscall.rs

2

3const SYSCALL_WRITE: usize = 64;

4const SYSCALL_EXIT: usize = 93;

5

6pub fn sys_write(fd: usize, buffer: &[u8]) -> isize {

7 syscall(SYSCALL_WRITE, [fd, buffer.as_ptr() as usize, buffer.len()])

8}

9

10pub fn sys_exit(xstate: i32) -> isize {

11 syscall(SYSCALL_EXIT, [xstate as usize, 0, 0])

12}

在 os/src/main.rs 中能够找到这样一行:

global_asm!(include_str!("link_app.S"));

这里我们引入了一段汇编代码 link_app.S ,它一开始并不存在,而是在构建的时候自动生成的。当我们使用 make run 让系统成功运行起来 之后,我们可以先来看一看里面的内容:

1# os/src/link_app.S

2

3 .align 3

4 .section .data

5 .global _num_app

6_num_app:

7 .quad 3

8 .quad app_0_start

9 .quad app_1_start

10 .quad app_2_start

11 .quad app_2_end

12

13 .section .data

14 .global app_0_start

15 .global app_0_end

16app_0_start:

17 .incbin "../user/target/riscv64gc-unknown-none-elf/release/00hello_world.bin"

18app_0_end:

19

20 .section .data

21 .global app_1_start

22 .global app_1_end

23app_1_start:

24 .incbin "../user/target/riscv64gc-unknown-none-elf/release/01store_fault.bin"

25app_1_end:

26

27 .section .data

28 .global app_2_start

29 .global app_2_end

30app_2_start:

31 .incbin "../user/target/riscv64gc-unknown-none-elf/release/02power.bin"

32app_2_end:

可以看到第 13 行开始的三个数据段分别插入了三个应用程序的二进制镜像,并且各自有一对全局符号 app_*_start, app_*_end 指示它们的 开始和结束位置。而第 3 行开始的另一个数据段相当于一个 64 位整数数组。数组中的第一个元素表示应用程序的数量,后面则按照顺序放置每个应用 程序的起始地址,最后一个元素放置最后一个应用程序的结束位置。这样每个应用程序的位置都能从该数组中相邻两个元素中得知。这个数组所在的位置 同样也由全局符号 _num_app 所指示。

这个文件是在 cargo build 的时候,由脚本 os/build.rs 控制生成的。

应用管理器 AppManager 结构体定义 如下:

struct AppManager {

inner: RefCell<AppManagerInner>,

}

struct AppManagerInner {

num_app: usize,

current_app: usize,

app_start: [usize; MAX_APP_NUM + 1],

}

unsafe impl Sync for AppManager {}current_app 字段表示当前执行到了第几个应用,它会在系统运行期间发生变化。因此在声明全局变量 的时候一种自然的方法是利用 static mut。但是在 Rust 中,任何对于 static mut 变量的访问都是 unsafe 的,而我们要尽可能 减少 unsafe 的使用来更多的让编译器负责安全性检查。

此外,为了让 AppManager 能被直接全局实例化,我们需要将其标记为 Sync 。

于是,我们利用 RefCell 来提供 内部可变性 (Interior Mutability), 所谓的内部可变性就是指在我们只能拿到 AppManager 的不可变借用,意味着同样也只能 拿到 AppManagerInner 的不可变借用的情况下依然可以修改 AppManagerInner 里面的字段。 使用 RefCell::borrow/RefCell::borrow_mut 分别可以拿到 RefCell 里面内容的不可变借用/可变借用, RefCell 会在运行时维护当前它管理的对象的已有借用状态,并在访问对象时进行借用检查。于是 RefCell::borrow_mut 就是我们实现内部可变性的关键。

lazy_static! 宏提供了全局变量的运行时初始化功能。一般情况下,全局变量必须在编译期设置一个初始值,但是有些全局变量依赖于运行期间 才能得到的数据作为初始值。这导致这些全局变量需要在运行时发生变化,也即重新设置初始值之后才能使用。如果我们手动实现的话有诸多不便之处, 比如需要把这种全局变量声明为 static mut 并衍生出很多 unsafe code。这种情况下我们可以使用 lazy_static! 宏来帮助我们解决 这个问题。这里我们借助 lazy_static! 声明了一个 AppManager 结构的名为 APP_MANAGER 的全局实例,且只有在它第一次被使用到 的时候才会进行实际的初始化工作。

因此,借助 Rust 核心库提供的 RefCell 和外部库 lazy_static!,我们就能在避免 static mut 声明的情况下以更加优雅的Rust风格使用全局变量。

在APP_MANAGER中load_app负责将参数 app_id 对应的应用程序的二进制镜像加载到物理内存以 0x80400000 开头的位置,这个位置是批处理操作系统和应用程序 之间约定的常数地址,回忆上一小节中,我们也调整应用程序的内存布局以同一个地址开头。第 8 行开始,我们首先将一块内存清空,然后找到待加载应用 二进制镜像的位置,并将它复制到正确的位置。它本质上是把数据从一块内存复制到另一块内存,从批处理操作系统的角度来看是将它数据段的一部分复制到了它 程序之外未知的地方。在这一点上也体现了冯诺依曼计算机的 代码即数据 的特征。

注意第 7 行我们插入了一条奇怪的汇编指令 fence.i ,它是用来清理 i-cache 的。我们知道缓存是存储层级结构中提高访存速度的很重要一环。 而 CPU 对物理内存所做的缓存又分成 数据缓存 (d-cache) 和 指令缓存 (i-cache) 两部分,分别在 CPU 访存和取指的时候使用。在取指 的时候,对于一个指令地址, CPU 会先去 i-cache 里面看一下它是否在某个已缓存的缓存行内,如果在的话它就会直接从高速缓存中拿到指令而不是通过 总线和内存通信。通常情况下, CPU 会认为程序的代码段不会发生变化,因此 i-cache 是一种只读缓存。但在这里,我们会修改会被 CPU 取指的内存 区域,这会使得 i-cache 中含有与内存中不一致的内容。因此我们这里必须使用 fence.i 指令手动清空 i-cache ,让里面所有的内容全部失效, 才能够保证正确性

- 当启动应用程序的时候,需要初始化应用程序的用户态上下文,并能切换到用户态执行应用程序;

- 当应用程序发起系统调用(即发出Trap )之后,需要到批处理操作系统中进行处理;

- 当应用程序执行出错的时候,需要到批处理操作系统中杀死该应用并加载运行下一个应用;

- 当应用程序执行结束的时候,需要到批处理操作系统中加载运行下一个应用(实际上也是通过系统调用

sys_exit来实现的)。

RISC-V 架构中,关于 Trap 有一条重要的规则:在 Trap 前的特权级不会高于Trap后的特权级。因此如果触发 Trap 之后切换到 S 特权级(下称 Trap 到 S), 说明 Trap 发生之前 CPU 只能运行在 S/U 特权级。但无论如何,只要是 Trap 到 S 特权级,操作系统就会使用 S 特权级中与 Trap 相关的 控制状态寄存器 (CSR, Control and Status Register) 来辅助 Trap 处理。我们在编写运行在 S 特权级的批处理操作系统中的 Trap 处理相关代码的时候,就需要使用如下所示的S模式的CSR寄存器。

| CSR 名 | 该 CSR 与 Trap 相关的功能 |

|---|---|

| sstatus | SPP 等字段给出 Trap 发生之前 CPU 处在哪个特权级(S/U)等信息 |

| sepc | 当 Trap 是一个异常的时候,记录 Trap 发生之前执行的最后一条指令的地址 |

| scause | 描述 Trap 的原因 |

| stval | 给出 Trap 附加信息 |

| stvec | 控制 Trap 处理代码的入口地址 |

S模式下最重要的 sstatus 寄存器

注意 sstatus 是 S 特权级最重要的 CSR,可以从很多方面控制 S 特权级的CPU行为和执行状态

当 CPU 执行完一条指令并准备从用户特权级 Trap 到 S 特权级的时候,硬件会自动帮我们做这些事情:

sstatus的SPP字段会被修改为 CPU 当前的特权级(U/S)。sepc会被修改为 Trap 回来之后默认会执行的下一条指令的地址。当 Trap 是一个异常的时候,它实际会被修改成 Trap 之前执行的最后一条 指令的地址。scause/stval分别会被修改成这次 Trap 的原因以及相关的附加信息。- CPU 会跳转到

stvec所设置的 Trap 处理入口地址,并将当前特权级设置为 S ,然后开始向下执行。

stvec 相关细节

在 RV64 中, stvec 是一个 64 位的 CSR,在中断使能的情况下,保存了中断处理的入口地址。它有两个字段:

- MODE 位于 [1:0],长度为 2 bits;

- BASE 位于 [63:2],长度为 62 bits。

当 MODE 字段为 0 的时候, stvec 被设置为 Direct 模式,此时进入 S 模式的 Trap 无论原因如何,处理 Trap 的入口地址都是 BASE<<2 , CPU 会跳转到这个地方进行异常处理。本书中我们只会将 stvec 设置为 Direct 模式。而 stvec 还可以被设置为 Vectored 模式

而当 CPU 完成 Trap 处理准备返回的时候,需要通过一条 S 特权级的特权指令 sret 来完成,这一条指令具体完成以下功能:

- CPU 会将当前的特权级按照

sstatus的SPP字段设置为 U 或者 S ; - CPU 会跳转到

sepc寄存器指向的那条指令,然后开始向下执行。

从上面可以看出硬件主要负责特权级切换、跳转到异常处理入口地址(要在使能异常/中断前设置好)以及在 CSR 中保存一些只有硬件才方便探测到的硬件内的 Trap 相关信息。这基本上都是硬件不得不完成的事情,剩下的工作都交给软件,让软件能有更大的灵活性。

在 Trap 发生时需要保存的物理资源内容,并将其一起放在一个名为 TrapContext 的类型中,定义如下:

#[repr(C)]

pub struct TrapContext {

pub x: [usize; 32],

pub sstatus: Sstatus,

pub sepc: usize,

}可以看到里面包含所有的通用寄存器 x0~x31 ,还有 sstatus 和 sepc 。那么为什么需要保存它们呢?

- 对于通用寄存器而言,两条执行流运行在不同的特权级,所属的软件也可能由不同的编程语言编写,虽然在 Trap 控制流中只是会执行 Trap 处理 相关的代码,但依然可能直接或间接调用很多模块,因此很难甚至不可能找出哪些寄存器无需保存。既然如此我们就只能全部保存了。但这里也有一些例外, 如

x0被硬编码为 0 ,它自然不会有变化;还有tp(x4)除非我们手动出于一些特殊用途使用它,否则一般也不会被用到。它们无需保存, 但我们仍然在TrapContext中为它们预留空间,主要是为了后续的实现方便。 - 对于 CSR 而言,我们知道进入 Trap 的时候,硬件会立即覆盖掉

scause/stval/sstatus/sepc的全部或是其中一部分。scause/stval的情况是:它总是在 Trap 处理的第一时间就被使用或者是在其他地方保存下来了,因此它没有被修改并造成不良影响的风险。 而对于sstatus/sepc而言,它们会在 Trap 处理的全程有意义(在 Trap 执行流最后sret的时候还用到了它们),而且确实会出现 Trap 嵌套的情况使得它们的值被覆盖掉。所以我们需要将它们也一起保存下来,并在sret之前恢复原样。

特权级切换的核心是对Trap的管理。这主要涉及到如下一下内容:

- 应用程序通过

ecall进入到内核状态时,操作系统保存被打断的应用程序的Trap 上下文。 - 操作系统根据与Trap相关的CSR寄存器内容,完成系统调用服务的分发与处理。

- 操作系统完成系统调用服务后,需要恢复被打断的应用程序的Trap 上下文,并通

sret让应用程序继续执行。

首先是保存 Trap 上下文的 __alltraps 的实现:

.altmacro

.macro SAVE_GP n

sd x\n, \n*8(sp)

.endm

.macro LOAD_GP n

ld x\n, \n*8(sp)

.endm

.section .text

.globl __alltraps

.globl __restore

.align 2

__alltraps:

csrrw sp, sscratch, sp

# now sp->kernel stack, sscratch->user stack

# allocate a TrapContext on kernel stack

addi sp, sp, -34*8

# save general-purpose registers

sd x1, 1*8(sp)

# skip sp(x2), we will save it later

sd x3, 3*8(sp)

# skip tp(x4), application does not use it

# save x5~x31

.set n, 5

.rept 27

SAVE_GP %n

.set n, n+1

.endr

# we can use t0/t1/t2 freely, because they were saved on kernel stack

csrr t0, sstatus

csrr t1, sepc

sd t0, 32*8(sp)

sd t1, 33*8(sp)

# read user stack from sscratch and save it on the kernel stack

csrr t2, sscratch

sd t2, 2*8(sp)

# set input argument of trap_handler(cx: &mut TrapContext)

mv a0, sp

call trap_handler

-

第 7 行我们使用

.align将__alltraps的地址 4 字节对齐,这是 RISC-V 特权级规范的要求; -

第 8 行的

csrrw原型是 csrrw rd, csr, rs 可以将 CSR 当前的值读到通用寄存器 rd 中,然后将 通用寄存器 rs 的值写入该 CSR 。因此这里起到的是交换 sscratch 和 sp 的效果。在这一行之前 sp 指向用户栈, sscratch 指向内核栈(原因稍后说明),现在 sp 指向内核栈, sscratch 指向用户栈。 -

第 12 行,我们准备在内核栈上保存 Trap 上下文,于是预先分配 34×8 字节的栈帧,这里改动的是 sp ,说明确实是在内核栈上。

-

第 13

24 行,保存 Trap 上下文的通用寄存器 x0x31,跳过 x0 和 tp(x4),原因之前已经说明。我们在这里也不保存 sp(x2),因为我们要基于 它来找到每个寄存器应该被保存到的正确的位置。实际上,在栈帧分配之后,我们可用于保存 Trap 上下文的地址区间为 [sp,sp+8×34) ,按照

TrapContext结构体的内存布局,它从低地址到高地址分别按顺序放置 x0~x31,最后是 sstatus 和 sepc 。因此通用寄存器 xn 应该被保存在地址区间 [sp+8n,sp+8(n+1)) 。 在这里我们正是这样基于 sp 来保存这些通用寄存器的。为了简化代码,x5~x31 这 27 个通用寄存器我们通过类似循环的

.rept每次使用SAVE_GP宏来保存,其实质是相同的。注意我们需要在Trap.S开头加上.altmacro才能正常使用.rept命令。 -

第 25~28 行,我们将 CSR sstatus 和 sepc 的值分别读到寄存器 t0 和 t1 中然后保存到内核栈对应的位置上。指令 csrr rd, csr 的功能就是将 CSR 的值读到寄存器 rd 中。这里我们不用担心 t0 和 t1 被覆盖, 因为它们刚刚已经被保存了。

-

第 30~31 行专门处理 sp 的问题。首先将 sscratch 的值读到寄存器 t2 并保存到内核栈上,注意它里面是进入 Trap 之前的 sp 的值,指向 用户栈。而现在的 sp 则指向内核栈。

-

第 33 行令 a0←sp,让寄存器 a0 指向内核栈的栈指针也就是我们刚刚保存的 Trap 上下文的地址, 这是由于我们接下来要调用

trap_handler进行 Trap 处理,它的第一个参数cx由调用规范要从 a0 中获取。而 Trap 处理函数trap_handler需要 Trap 上下文的原因在于:它需要知道其中某些寄存器的值,比如在系统调用的时候应用程序传过来的 syscall ID 和 对应参数。我们不能直接使用这些寄存器现在的值,因为它们可能已经被修改了,因此要去内核栈上找已经被保存下来的值。

当 trap_handler 返回之后会从调用 trap_handler 的下一条指令开始执行,也就是从栈上的 Trap 上下文恢复的 __restore :

__restore:

# case1: start running app by __restore

# case2: back to U after handling trap

mv sp, a0

# now sp->kernel stack(after allocated), sscratch->user stack

# restore sstatus/sepc

ld t0, 32*8(sp)

ld t1, 33*8(sp)

ld t2, 2*8(sp)

csrw sstatus, t0

csrw sepc, t1

csrw sscratch, t2

# restore general-purpuse registers except sp/tp

ld x1, 1*8(sp)

ld x3, 3*8(sp)

.set n, 5

.rept 27

LOAD_GP %n

.set n, n+1

.endr

# release TrapContext on kernel stack

addi sp, sp, 34*8

# now sp->kernel stack, sscratch->user stack

csrrw sp, sscratch, sp

sret- 第 8 行比较奇怪我们暂且不管,假设它从未发生,那么 sp 仍然指向内核栈的栈顶。

- 第 11~24 行负责从内核栈顶的 Trap 上下文恢复通用寄存器和 CSR 。注意我们要先恢复 CSR 再恢复通用寄存器,这样我们使用的三个临时寄存器 才能被正确恢复。

- 在第 26 行之前,sp 指向保存了 Trap 上下文之后的内核栈栈顶, sscratch 指向用户栈栈顶。我们在第 26 行在内核栈上回收 Trap 上下文所 占用的内存,回归进入 Trap 之前的内核栈栈顶。第 27 行,再次交换 sscratch 和 sp,现在 sp 重新指向用户栈栈顶,sscratch 也依然保存 进入 Trap 之前的状态并指向内核栈栈顶。

- 在应用程序执行流状态被还原之后,第 28 行我们使用

sret指令回到 U 特权级继续运行应用程序执行流。

sscratch CSR 的用途

在特权级切换的时候,我们需要将 Trap 上下文保存在内核栈上,因此需要一个寄存器暂存内核栈地址,并以它作为基地址来依次保存 Trap 上下文 的内容。但是所有的通用寄存器都不能够用来暂存,因为它们都需要被保存,如果覆盖掉它们会影响应用执行流的执行。

事实上我们缺少了一个重要的中转寄存器,而 sscratch CSR 正是为此而生。从上面的汇编代码中可以看出,在保存 Trap 上下文的时候,它 起到了两个作用:首先是保存了内核栈的地址,其次它作为一个中转站让 sp 目前指向的用户栈的地址可以暂时保存下来。于是,我们仅需一条 csrrw 指令就完成了从用户栈到内核栈的切换,这是一种极其精巧的实现。

Trap 在使用 Rust 实现的 trap_handler 函数中完成分发和处理:

1// os/src/trap/mod.rs

2

3#[no_mangle]

4pub fn trap_handler(cx: &mut TrapContext) -> &mut TrapContext {

5 let scause = scause::read();

6 let stval = stval::read();

7 match scause.cause() {

8 Trap::Exception(Exception::UserEnvCall) => {

9 cx.sepc += 4;

10 cx.x[10] = syscall(cx.x[17], [cx.x[10], cx.x[11], cx.x[12]]) as usize;

11 }

12 Trap::Exception(Exception::StoreFault) |

13 Trap::Exception(Exception::StorePageFault) => {

14 println!("[kernel] PageFault in application, core dumped.");

15 run_next_app();

16 }

17 Trap::Exception(Exception::IllegalInstruction) => {

18 println!("[kernel] IllegalInstruction in application, core dumped.");

19 run_next_app();

20 }

21 _ => {

22 panic!("Unsupported trap {:?}, stval = {:#x}!", scause.cause(), stval);

23 }

24 }

25 cx

26}

-

第 4 行声明返回值为

&mut TrapContext并在第 25 行实际将传入的cx原样返回,因此在__restore的时候 a0 在调用trap_handler前后并没有发生变化,仍然指向分配 Trap 上下文之后的内核栈栈顶,和此时 sp 的值相同,我们 sp←a0 并不会有问题; -

第 7 行根据 scause 寄存器所保存的 Trap 的原因进行分发处理。这里我们无需手动操作这些 CSR ,而是使用 Rust 的 riscv 库来更加方便的 做这些事情。要引入 riscv 库,我们需要:

# os/Cargo.toml [dependencies] riscv = { git = "https://github.com/rcore-os/riscv", features = ["inline-asm"] } -

第 8~11 行,发现 Trap 的原因是来自 U 特权级的 Environment Call,也就是系统调用。这里我们首先修改保存在内核栈上的 Trap 上下文里面 sepc,让其增加 4。这是因为我们知道这是一个由

ecall指令触发的系统调用,在进入 Trap 的时候,硬件会将 sepc 设置为这条ecall指令所在的地址(因为它是进入 Trap 之前最后一条执行的指令)。而在 Trap 返回之后,我们希望应用程序执行流从ecall的下一条指令 开始执行。因此我们只需修改 Trap 上下文里面的 sepc,让它增加ecall指令的码长,也即 4 字节。这样在__restore的时候 sepc 在恢复之后就会指向ecall的下一条指令,并在sret之后从那里开始执行。这属于我们之前提到过的——用户程序能够预知到的执行流 状态所发生的变化。用来保存系统调用返回值的 a0 寄存器也会同样发生变化。我们从 Trap 上下文取出作为 syscall ID 的 a7 和系统调用的三个参数 a0~a2 传给

syscall函数并获取返回值。syscall函数是在syscall子模块中实现的。 -

第 12~20 行,分别处理应用程序出现访存错误和非法指令错误的情形。此时需要打印错误信息并调用

run_next_app直接切换并运行下一个 应用程序。 -

第 21 行开始,当遇到目前还不支持的 Trap 类型的时候,我们的批处理操作系统整个 panic 报错退出。

当批处理操作系统初始化完成,或者是某个应用程序运行结束或出错的时候,我们要调用 run_next_app 函数切换到下一个应用程序。此时 CPU 运行在 S 特权级,而它希望能够切换到 U 特权级。在 RISC-V 架构中,唯一一种能够使得 CPU 特权级下降的方法就是通过 Trap 返回系列指令,比如 sret 。事实上,在运行应用程序之前要完成如下这些工作:

- 跳转到应用程序入口点

0x80400000。 - 将使用的栈切换到用户栈。

- 在

__alltraps时我们要求sscratch指向内核栈,这个也需要在此时完成。 - 从 S 特权级切换到 U 特权级。

它们可以通过复用 __restore 的代码更容易的实现。我们只需要在内核栈上压入一个相应构造的 Trap 上下文,再通过 __restore ,就能 让这些寄存器到达我们希望的状态。

impl TrapContext {

pub fn set_sp(&mut self, sp: usize) { //设置x[2]为用户栈的栈顶,x[2]保存的事sscratch这个寄存器

self.x[2] = sp; //在上下文push在内核栈,返回后刚好能回到用户栈

}

pub fn app_init_context(entry: usize, sp: usize) -> Self {

let mut sstatus = sstatus::read(); //设置第一次应用压入时的状态

sstatus.set_spp(SPP::User);

let mut cx = Self {

x: [0; 32],

sstatus,

sepc: entry,

};

cx.set_sp(sp); //设置sscratch这个寄存器 也就是用户栈顶位置

cx

}

}为 TrapContext 实现 app_init_context 方法,修改其中的 sepc 寄存器为应用程序入口点 entry, sp 寄存器为我们设定的 一个栈指针,并将 sstatus 寄存器的 SPP 字段设置为 User 。

在 run_next_app 函数中我们能够看到:

1// os/src/batch.rs

2

3pub fn run_next_app() -> ! {

4 let current_app = APP_MANAGER.inner.borrow().get_current_app();

5 unsafe {

6 APP_MANAGER.inner.borrow().load_app(current_app);

7 }

8 APP_MANAGER.inner.borrow_mut().move_to_next_app();

9 extern "C" { fn __restore(cx_addr: usize); }

10 unsafe {

11 __restore(KERNEL_STACK.push_context(

12 TrapContext::app_init_context(APP_BASE_ADDRESS, USER_STACK.get_sp())

13 ) as *const _ as usize); //

14 }

15 panic!("Unreachable in batch::run_current_app!");

16}

pub fn push_context(&self, cx: TrapContext) -> &'static mut TrapContext {

let cx_ptr = (self.get_sp() - core::mem::size_of::<TrapContext>()) as *mut TrapContext;

unsafe {

*cx_ptr = cx;

}

unsafe{

cx_ptr.as_mut().unwrap()

}

}在高亮行所做的事情是在内核栈上压入一个 Trap 上下文,其 sepc 是应用程序入口地址 0x80400000 ,其 sp 寄存器指向用户栈,其 sstatus 的 SPP 字段被设置为 User 。push_context 的返回值是内核栈压入 Trap 上下文之后的栈顶,它会被作为 __restore 的参数( 回看 __restore 代码 ,这时我们可以理解为何 __restore 的开头会做 sp←a0 )使得在 __restore 中 sp 仍然可以指向内核栈的栈顶。这之后,就和一次普通的 __restore 一样了。push_context直接从用户栈顶拿到上下文并push到内核栈。

- 通过提前加载应用程序到内存,减少应用程序切换开销

- 通过协作机制支持程序主动放弃处理器,提高系统执行效率

- 通抢占机制支持程序被动放弃处理器,提高不同程序对处理器资源使用的公平性,也进一步提高了应用对I/O事件的响应效率

早期的计算机系统大部分是单处理器计算机系统。当处理器进一步发展后,它与IO的速度差距也进一步拉大。这时计算机科学家发现,在 多道程序 运行方式下,一个程序如果不让出处理器,其他程序是无法执行的。如果一个应用由于IO操作让处理器空闲下来或让处理器忙等,那其他需要处理器资源进行计算的应用还是没法使用空闲的处理器资源。于是就想到,让应用在执行IO操作时,可以主动 释放处理器 ,让其他应用继续执行。当然执行 放弃处理器 的操作算是一种对处理器资源的直接管理,所以应用程序可以发出这样的系统调用,让操作系统来具体完成。这样的操作系统就是支持 多道程序 协作式操作系统。

计算机科学家很快发现,编写应用程序的科学家(简称应用程序员)来自不同的领域,他们不一定有友好互助的意识,也不了解其他程序的执行情况,很难(也没必要)有提高整个系统利用率上的大局观。在他们的脑海里,整个计算机就应该是为他们自己的应用准备的,不用考虑其他程序的运行。这导致应用程序员在编写程序时,无法做到在程序的合适位置放置 放弃处理器的系统调用请求 ,这样系统的整体利用率还是无法提高。

所以,站在系统的层面,还是需要有一种办法能强制打断应用程序的执行,来提高整个系统的效率,让在整个系统中执行的多个程序之间占用计算机资源的情况相对公平一些。根据计算机系统的硬件设计,为提高I/O效率,外设可以通过硬件中断机制来与处理机进行I/O交互操作。这种硬件中断机制·可随时打断应用程序的执行,并让操作系统来完成对外设的I/O响应。

而操作系统可进一步利用某种以固定时长为时间间隔的外设中断(比如时钟中断)来强制打断一个程序的执行,这样一个程序只能运行一段时间(可以简称为一个时间片, Time Slice)就一定会让出处理器,且操作系统可以在处理外设的I/O响应后,让不同应用程序分时占用处理器执行,并可通过程序占用处理器的总执行时间来评估运行的程序对处理器资源的消耗。

我们可以把一个程序在一个时间片上占用处理器执行的过程称为一个 任务 (Task),让操作系统对不同程序的 任务 进行管理。通过平衡各个程序在整个时间段上的任务数,就达到一定程度的系统公平和高效的系统效率。在一个包含多个时间片的时间段上,会有属于不同程序的多个任务在轮流占用处理器执行,这样的操作系统就是支持 分时多任务 的抢占式操作系统。

本章所介绍的多道程序和分时多任务系统都有一些共同的特点:在内存中同一时间可以驻留多个应用。所有的应用都是在系统启动的时候分别加载到内存的不同区域中。由于目前计算机系统中只有一个处理器,则同一时间最多只有一个应用在执行,剩下的应用则处于就绪状态,需要内核将处理器分配给它们才能开始执行。一旦应用开始执行,它就处于运行状态了。

本章主要是设计和实现建立支持 多道程序 的二叠纪“锯齿螈”初级操作系统、支持多道程序的三叠纪“始初龙”协作式操作系统和支持 分时多任务 的三叠纪“腔骨龙”抢占式操作系统,从而对可支持运行一批应用程序的多种执行环境有一个全面和深入的理解,并可归纳抽象出 任务 , 任务切换 等操作系统的概念。

由于每个应用被加载到的位置都不同,也就导致它们的链接脚本 linker.ld 中的 BASE_ADDRESS 都是不同的。实际上, 我们写了一个脚本 build.py 而不是直接用 cargo build 构建应用的链接脚本:

import os

base_address = 0x80400000

step = 0x20000

linker = 'src/linker.ld'

app_id = 0

apps = os.listdir('src/bin')

apps.sort()

for app in apps:

app = app[:app.find('.')]

lines = []

lines_before = []

with open(linker, 'r') as f:

for line in f.readlines():

lines_before.append(line)

line = line.replace(hex(base_address), hex(base_address+step*app_id))

lines.append(line)

with open(linker, 'w+') as f:

f.writelines(lines)

os.system('cargo build --bin %s --release' % app)

print('[build.py] application %s start with address %s' %(app, hex(base_address+step*app_id)))

with open(linker, 'w+') as f:

f.writelines(lines_before)

app_id = app_id + 1

它的思路很简单,在遍历 app 的大循环里面只做了这样几件事情:

- 第 16~22 行,找到

src/linker.ld中的BASE_ADDRESS = 0x80400000;这一行,并将后面的地址 替换为和当前应用对应的一个地址; - 第 23 行,使用

cargo build构建当前的应用,注意我们可以使用--bin参数来只构建某一个应用; - 第 25~26 行,将

src/linker.ld还原。

应用的加载方式也和上一章的有所不同。上一章中讲解的加载方法是让所有应用都共享同一个固定的加载物理地址。也是因为这个原因,内存中同时最多只能驻留一个应用,当它运行完毕或者出错退出的时候由操作系统的 batch 子模块加载一个新的应用来替换掉它。本章中,所有的应用在内核初始化的时候就一并被加载到内存中。为了避免覆盖,它们自然需要被加载到不同的物理地址。这是通过调用 loader 子模块的 load_apps 函数实现的:

pub fn load_apps(){

extern "C"{

fn _num_app(); //加载汇编程序

}

let num_app_ptr=_num_app as usize as *const usize; //获得num_app存在的位置

let num_app=get_num_app(); //从data段中拿到一些数据

let app_start=unsafe{

core::slice::from_raw_parts(num_app_ptr.add(1), num_app+1)

};

unsafe {

llvm_asm!("fence.i"::::"volatile");

}

for i in 0..num_app{

let base_i=get_base_i(i); //从0x0840000开始存放

(base_i..base_i+APP_SIZE_LIMIT).for_each(|addr|unsafe{

(addr as *mut u8).write_volatile(0)

});

let src = unsafe{

core::slice::from_raw_parts(app_start[i] as *const u8, app_start[i+1]-app_start[i])

};

let dst = unsafe {

core::slice::from_raw_parts_mut(base_i as *mut u8, src.len())

};

dst.copy_from_slice(src);

}

}可以看出,第 i 个应用被加载到以物理地址 base_i 开头的一段物理内存上,而 base_i 的计算方式如下:

1 // os/src/loader.rs

2

3 fn get_base_i(app_id: usize) -> usize {

4 APP_BASE_ADDRESS + app_id * APP_SIZE_LIMIT

5 }我们可以在 config 子模块中找到这两个常数。从这一章开始, config 子模块用来存放内核中所有的常数。看到 APP_BASE_ADDRESS 被设置为 0x80400000 ,而 APP_SIZE_LIMIT 和上一章一样被设置为 0x20000 ,也就是每个应用二进制镜像的大小限制。因此,应用的内存布局就很明朗了——就是从 APP_BASE_ADDRESS 开始依次为每个应用预留一段空间。

这样,我们就说明了多个应用是如何被构建和加载的。

当多道程序的初始化放置工作完成,或者是某个应用程序运行结束或出错的时候,我们要调用 run_next_app 函数切换到下一个应用程序。此时 CPU 运行在 S 特权级的操作系统中,而操作系统希望能够切换到 U 特权级去运行应用程序。这一过程与上章的 执行应用程序 一节的描述类似。相对不同的是,操作系统知道每个应用程序预先加载在内存中的位置,这就需要设置应用程序返回的不同 Trap 上下文(Trap上下文中保存了 放置程序起始地址的epc 寄存器内容):

- 跳转到应用程序(编号 i )的入口点 entryi

- 将使用的栈切换到用户栈

本节的重点是操作系统的核心机制—— 任务切换 。 任务切换支持的场景是:一个应用在运行途中便会主动交出 CPU 的使用权,此时它只能暂停执行,等到内核重新给它分配处理器资源之后才能恢复并继续执行。

我们又看到了熟悉的“暂停-继续”组合。一旦一条执行流需要支持“暂停-继续”,就需要提供一种执行流切换的机制,而且需要保证执行流被切换出去之前和切换回来之后,它的状态,也就是在执行过程中同步变化的资源(如寄存器、栈等)需要保持不变,或者变化在它的预期之内。而不是所有的资源都需要被保存,事实上只有那些对于执行流接下来的进行仍然有用,且在它被切换出去的时候有被覆盖的风险的那些资源才有被保存的价值。这些物理资源被称为 任务上下文 (Task Context)

本节的任务切换的执行过程是第二章的 Trap 之后的另一种异常控制流,都是描述两条执行流之间的切换,如果将它和 Trap 切换进行比较,会有如下异同:

- 与 Trap 切换不同,它不涉及特权级切换;

- 与 Trap 切换不同,它的一部分是由编译器帮忙完成的;

- 与 Trap 切换相同,它对应用是透明的。

事实上,它是来自两个不同应用的 Trap 执行流之间的切换。当一个应用 Trap 到 S 模式的操作系统中进行进一步处理(即进入了操作系统的Trap执行流)的时候,其 Trap 执行流可以调用一个特殊的 __switch 函数。这个函数表面上就是一个普通的函数调用:在 __switch 返回之后,将继续从调用该函数的位置继续向下执行。但是其间却隐藏着复杂的执行流切换过程。具体来说,调用 __switch 之后直到它返回前的这段时间,原 Trap 执行流会先被暂停并被切换出去, CPU 转而运行另一个应用的 Trap 执行流。之后在时机合适的时候,原 Trap 执行流才会从某一条 Trap 执行流(很有可能不是它之前切换到的那一条)切换回来继续执行并最终返回。不过,从实现的角度讲, __switch 和一个普通的函数之间的差别仅仅是它会换栈。

当 Trap 执行流准备调用 __switch 函数并进入暂停状态的时候,让我们考察一下它内核栈上的情况。如上图所示,在准备调用 __switch 函数之前,内核栈上从栈底到栈顶分别是保存了应用执行状态的 Trap 上下文以及内核在对 Trap 处理的过程中留下的调用栈信息。由于之后还要恢复回来执行,我们必须保存 CPU 当前的某些寄存器,我们称它们为 任务上下文 (Task Context)。我们会在稍后介绍里面需要包含哪些寄存器。至于保存的位置,我们将任务上下文直接压入内核栈的栈顶,从这一点上来说它和函数调用一样。

这样需要保存的信息就已经确实的保存在内核栈上了,而恢复的时候我们要从任务上下文的位置——也就是这一时刻内核栈栈顶的位置找到被保存的寄存器快照进行恢复,这个位置也需要被保存下来。对于每一条被暂停的 Trap 执行流,我们都用一个名为 task_cx_ptr 的变量来保存它栈顶的任务上下文的地址

下面我们给出 __switch 的实现:

1# os/src/task/switch.S

2

3.altmacro

4.macro SAVE_SN n

5 sd s\n, (\n+1)*8(sp)

6.endm

7.macro LOAD_SN n

8 ld s\n, (\n+1)*8(sp)

9.endm

10 .section .text

11 .globl __switch

12__switch:

13 # __switch(

14 # current_task_cx_ptr2: &*const TaskContext,

15 # next_task_cx_ptr2: &*const TaskContext

16 # )

17 # push TaskContext to current sp and save its address to where a0 points to

18 addi sp, sp, -13*8

19 sd sp, 0(a0)

20 # fill TaskContext with ra & s0-s11

21 sd ra, 0(sp)

22 .set n, 0

23 .rept 12

24 SAVE_SN %n

25 .set n, n + 1

26 .endr

27 # ready for loading TaskContext a1 points to

28 ld sp, 0(a1)

29 # load registers in the TaskContext

30 ld ra, 0(sp)

31 .set n, 0

32 .rept 12

33 LOAD_SN %n

34 .set n, n + 1

35 .endr

36 # pop TaskContext

37 addi sp, sp, 13*8

38 ret我们手写汇编代码来实现 __switch 。可以看到它的函数原型中的两个参数分别是当前 Trap 执行流和即将被切换到的 Trap 执行流的 task_cx_ptr2 ,从 RISC-V 调用规范 可以知道它们分别通过寄存器 a0/a1 传入。

阶段 [2] 体现在第 18~26 行。第 18 行在 A 的内核栈上预留任务上下文的空间,然后将当前的栈顶位置保存下来。接下来就是逐个对寄存器进行保存,从中我们也能够看出 TaskContext 里面究竟包含哪些寄存器:

1// os/src/task/context.rs

2

3#[repr(C)]

4pub struct TaskContext {

5 ra: usize,

6 s: [usize; 12],

7}这里面只保存了 ra 和被调用者保存的 s0~s11 。ra 的保存很重要,它记录了 __switch 返回之后应该到哪里继续执行,从而在切换回来并 ret 之后能到正确的位置。而保存调用者保存的寄存器是因为,调用者保存的寄存器可以由编译器帮我们自动保存。我们会将这段汇编代码中的全局符号 __switch 解释为一个 Rust 函数:

1// os/src/task/switch.rs

2

3global_asm!(include_str!("switch.S"));

4

5extern "C" {

6 pub fn __switch(

7 current_task_cx_ptr2: *const usize,

8 next_task_cx_ptr2: *const usize

9 );

10}我们会调用该函数来完成切换功能而不是直接跳转到符号 __switch 的地址。因此在调用前后 Rust 编译器会自动帮助我们插入保存/恢复调用者保存寄存器的汇编代码。

仔细观察的话可以发现 TaskContext 很像一个普通函数栈帧中的内容。正如之前所说, __switch 的实现除了换栈之外几乎就是一个普通函数,也能在这里得到体现。尽管如此,二者的内涵却有着很大的不同。

剩下的汇编代码就比较简单了。读者可以自行对照注释看看图示中的后面几个阶段各是如何实现的。另外,后面会出现传给 __switch 的两个参数相同,也就是某个 Trap 执行流自己切换到自己的情形,请读者对照图示思考目前的实现能否对它进行正确处理。

本节的一个重点是展示进一步增强的操作系统管理能力的和对处理器资源的相对高效利用。为此,对 任务 的概念进行进一步扩展和延伸:形成了

- 任务运行状态:任务从开始到结束执行过程中所处的不同运行状态:未初始化、准备执行、正在执行、已退出

- 任务控制块:管理程序的执行过程的任务上下文,控制程序的执行与暂停

- 任务相关系统调用:应用程序和操作系统直接的接口,用于程序主动暂停

sys_yield和主动退出sys_exit

我们给出 sys_yield 的标准接口:

第三章新增系统调用(一)

/// 功能:应用主动交出 CPU 所有权并切换到其他应用。

/// 返回值:总是返回 0。

/// syscall ID:124

fn sys_yield() -> isize;

然后是用户库对应的实现和封装:

// user/src/syscall.rs

pub fn sys_yield() -> isize {

syscall(SYSCALL_YIELD, [0, 0, 0])

}

// user/src/lib.rs

pub fn yield_() -> isize { sys_yield() }注意 yield 是 Rust 的关键字,因此我们只能将应用直接调用的接口命名为 yield_ 。rust任务控制块与任务运行状态

#[derive(Copy, Clone, PartialEq)]

pub enum TaskStatus {

UnInit,

Ready,

Running,

Exited,

}注解

Rust 语法卡片:#[derive]

通过 #[derive(...)] 可以让编译器为你的类型提供一些 Trait 的默认实现。

- 实现了

CloneTrait 之后就可以调用clone函数完成拷贝; - 实现了

PartialEqTrait 之后就可以使用==运算符比较该类型的两个实例,从逻辑上说只有 两个相等的应用执行状态才会被判为相等,而事实上也确实如此。 Copy是一个标记 Trait,决定该类型在按值传参/赋值的时候取移动语义还是复制语义。

仅仅有这个是不够的,内核还需要保存一个应用的更多信息,我们将它们都保存在一个名为 任务控制块 (Task Control Block) 的数据结构中:

pub struct TaskControlBlock {

pub task_cx_ptr: usize,

pub task_status: TaskStatus,

}

impl TaskControlBlock {

pub fn get_task_cx_ptr2(&self) -> *const usize {

&self.task_cx_ptr as *const usize

}

}可以看到我们还在 task_cx_ptr 字段中维护了一个上一小节中提到的指向应用被切换出去的时候,它内核栈栈顶的任务上下文的指针。而在任务切换函数 __switch 中我们需要用这个 task_cx_ptr 的指针作为参数并代表这个应用,于是 TaskControlBlock 还提供了获取这个指针的指针 task_cx_ptr2 的方法 get_task_cx_ptr2 。

任务控制块非常重要。在内核中,它就是应用的管理单位。在后面的章节我们还会不断向里面添加更多内容。

我们还需要一个全局的任务管理器来管理这些用任务控制块描述的应用:

// os/src/task/mod.rs

pub struct TaskManager {

num_app: usize,

inner: RefCell<TaskManagerInner>,

}

struct TaskManagerInner {

tasks: [TaskControlBlock; MAX_APP_NUM],

current_task: usize,

}

unsafe impl Sync for TaskManager {}

其中仍然使用到了变量与常量分离的编程风格:字段 num_app 仍然表示任务管理器管理的应用的数目,它在 TaskManager 初始化之后就不会发生变化;而包裹在 TaskManagerInner 内的任务控制块数组 tasks 以及表示 CPU 正在执行的应用编号 current_task 会在执行应用的过程中发生变化: 每个应用的运行状态都会发生变化,而 CPU 执行的应用也在不断切换。

再次强调,这里的 current_task 与第二章批处理系统中的含义不同。在批处理系统中,它表示一个既定的应用序列中的执行进度,隐含着在该应用之前的都已经执行完毕,之后都没有执行;而在这里我们只能通过它知道 CPU 正在执行哪个应用,而不能获得其他应用的任何信息。

lazy_static!{ //一些很简单的初始化工作

pub static ref TASK_MANAGER:TaskManager={

let num_app=get_num_app(); //获取当前app的数量

let mut tasks=[

TaskControlBlock{

task_cx_ptr:0,

task_status:TaskStatus::Running,

};

MAX_APP_NUM

];

for i in 0..num_app{

tasks[i].task_cx_ptr=init_app_cx(i) as *const _ as usize;

tasks[i].task_status=TaskStatus::Ready;

}

TaskManager{

num_app,

inner:RefCell::new(TaskManagerInner{

tasks,

current_task:0,

}),

}

};

}构建一个TASK_MANAGER的全局构造器 同样是需要 具有内部可变性

sys_yield 的实现用到了 task 子模块提供的 suspend_current_and_run_next 接口:

// os/src/syscall/process.rs

use crate::task::suspend_current_and_run_next;

pub fn sys_yield() -> isize {

suspend_current_and_run_next();

0

}

这个接口如字面含义,就是暂停当前的应用并切换到下个应用。

同样, sys_exit 也改成基于 task 子模块提供的 exit_current_and_run_next 接口:

// os/src/syscall/process.rs

use crate::task::exit_current_and_run_next;

pub fn sys_exit(exit_code: i32) -> ! {

println!("[kernel] Application exited with code {}", exit_code);

exit_current_and_run_next();

panic!("Unreachable in sys_exit!");

}

它的含义是退出当前的应用并切换到下个应用。在调用它之前我们打印应用的退出信息并输出它的退出码。如果是应用出错也应该调用该接口,不过我们这里并没有实现,有兴趣的读者可以尝试。

suspend_current_and_run_next();exit_current_and_run_next(); 实现方法 主要体现在run_next_app,所以只会重点讲述run_next_task

接下来看看 run_next_task 的实现:

1// os/src/task/mod.rs

2

3fn run_next_task() {

4 TASK_MANAGER.run_next_task();

5}

6

7impl TaskManager {

8 fn run_next_task(&self) {

9 if let Some(next) = self.find_next_task() {

10 let mut inner = self.inner.borrow_mut();

11 let current = inner.current_task;

12 inner.tasks[next].task_status = TaskStatus::Running;

13 inner.current_task = next;

14 let current_task_cx_ptr2 = inner.tasks[current].get_task_cx_ptr2();

15 let next_task_cx_ptr2 = inner.tasks[next].get_task_cx_ptr2();

16 core::mem::drop(inner);

17 unsafe {

18 __switch(

19 current_task_cx_ptr2,

20 next_task_cx_ptr2,

21 );

22 }

23 } else {

24 panic!("All applications completed!");

25 }

26 }

27}

run_next_task 使用任务管理器的全局实例 TASK_MANAGER 的 run_next_task 方法。它会调用 find_next_task 方法尝试寻找一个运行状态为 Ready 的应用并返回其 ID 。注意到其返回的类型是 Option<usize> ,也就是说不一定能够找到,当所有的应用都退出并将自身状态修改为 Exited 就会出现这种情况,此时 find_next_task 应该返回 None 。如果能够找到下一个可运行的应用的话,我们就可以分别拿到当前应用 current 和即将被切换到的应用 next 的 task_cx_ptr2 ,然后调用 __switch 接口进行切换。如果找不到的话,说明所有的应用都运行完毕了,我们可以直接 panic 退出内核。

注意在实际切换之前我们需要手动 drop 掉我们获取到的 TaskManagerInner 的可变引用。因为一般情况下它是在函数退出之后才会被自动释放,从而 TASK_MANAGER 的 inner 字段得以回归到未被借用的状态,之后可以再借用。如果不手动 drop 的话,编译器会在 __switch 返回,也就是当前应用被切换回来的时候才 drop,这期间我们都不能修改 TaskManagerInner ,甚至不能读(因为之前是可变借用)。正因如此,我们需要在 __switch 前提早手动 drop 掉 inner 。

于是 find_next_task 又是如何实现的呢?

1// os/src/task/mod.rs

2

3impl TaskManager {

4 fn find_next_task(&self) -> Option<usize> {

5 let inner = self.inner.borrow();

6 let current = inner.current_task;

7 (current + 1..current + self.num_app + 1)

8 .map(|id| id % self.num_app)

9 .find(|id| {

10 inner.tasks[*id].task_status == TaskStatus::Ready

11 })

12 }

13}

TaskManagerInner 的 tasks 是一个固定的任务控制块组成的表,长度为 num_app ,可以用下标 0~num_app-1 来访问得到每个应用的控制状态。我们的任务就是找到 current_task 后面第一个状态为 Ready 的应用。因此从 current_task + 1 开始循环一圈,需要首先对 num_app 取模得到实际的下标,然后检查它的运行状态。

注解

Rust 语法卡片:迭代器

a..b 实际上表示左闭右开区间 [a,b) ,在 Rust 中,它会被表示为类型 core::ops::Range ,标准库中为它实现好了 Iterator trait,因此它也是一个迭代器。

关于迭代器的使用方法如 map/find 等,请参考 Rust 官方文档。

- 在应用真正跑起来之前,需要 CPU 第一次从内核态进入用户态。我们在第二章批处理系统中也介绍过实现方法,只需在内核栈上压入构造好的 Trap 上下文,然后

__restore即可。本章的思路大致相同,但是有一些变化。 - 当一个应用即将被运行的时候,它会被

__switch过来。如果它是之前被切换出去的话,那么此时它的内核栈上应该有 Trap 上下文和任务上下文,切换机制可以正常工作。但是如果它是第一次被执行怎么办呢?这就需要它的内核栈上也有类似结构的内容。我们是在创建TaskManager的全局实例TASK_MANAGER的时候来进行这个初始化的。

当时我们进行了这样的操作。 init_app_cx 是在 loader 子模块中定义的:

// os/src/loader.rs

pub fn init_app_cx(app_id: usize) -> &'static TaskContext {

KERNEL_STACK[app_id].push_context(

TrapContext::app_init_context(get_base_i(app_id), USER_STACK[app_id].get_sp()),

TaskContext::goto_restore(),

)

}

impl KernelStack {

fn get_sp(&self) -> usize {

self.data.as_ptr() as usize + KERNEL_STACK_SIZE

}

pub fn push_context(&self, trap_cx: TrapContext, task_cx: TaskContext) -> &'static mut TaskContext {

unsafe {

let trap_cx_ptr = (self.get_sp() - core::mem::size_of::<TrapContext>()) as *mut TrapContext;

*trap_cx_ptr = trap_cx;

let task_cx_ptr = (trap_cx_ptr as usize - core::mem::size_of::<TaskContext>()) as *mut TaskContext;

*task_cx_ptr = task_cx;

task_cx_ptr.as_mut().unwrap()

}

}

}这里 KernelStack 的 push_context 方法先压入一个和之前相同的 Trap 上下文,再在它上面压入一个任务上下文,然后返回任务上下文的地址。这个任务上下文是我们通过 TaskContext::goto_restore 构造的:

// os/src/task/context.rs

impl TaskContext {

pub fn goto_restore() -> Self {

extern "C" { fn __restore(); }

Self {

ra: __restore as usize,

s: [0; 12],

}

}

}它只是将任务上下文的 ra 寄存器设置为 __restore 的入口地址。这样,在 __switch 从它上面恢复并返回之后就会直接跳转到 __restore ,此时栈顶是一个我们构造出来第一次进入用户态执行的 Trap 上下文,就和第二章的情况一样了。

当时我们进行了这样的操作。 init_app_cx 是在 loader 子模块中定义的:

// os/src/loader.rs

pub fn init_app_cx(app_id: usize) -> &'static TaskContext {

KERNEL_STACK[app_id].push_context(

TrapContext::app_init_context(get_base_i(app_id), USER_STACK[app_id].get_sp()),

TaskContext::goto_restore(),

)

}

impl KernelStack {

fn get_sp(&self) -> usize {

self.data.as_ptr() as usize + KERNEL_STACK_SIZE

}

pub fn push_context(&self, trap_cx: TrapContext, task_cx: TaskContext) -> &'static mut TaskContext {

unsafe {

let trap_cx_ptr = (self.get_sp() - core::mem::size_of::<TrapContext>()) as *mut TrapContext;

*trap_cx_ptr = trap_cx;

let task_cx_ptr = (trap_cx_ptr as usize - core::mem::size_of::<TaskContext>()) as *mut TaskContext;

*task_cx_ptr = task_cx;

task_cx_ptr.as_mut().unwrap()

}

}

}

这里 KernelStack 的 push_context 方法先压入一个和之前相同的 Trap 上下文,再在它上面压入一个任务上下文,然后返回任务上下文的地址。这个任务上下文是我们通过 TaskContext::goto_restore 构造的:

// os/src/task/context.rs

impl TaskContext {

pub fn goto_restore() -> Self {

extern "C" { fn __restore(); }

Self {

ra: __restore as usize,

s: [0; 12],

}

}

}

它只是将任务上下文的 ra 寄存器设置为 __restore 的入口地址。这样,在 __switch 从它上面恢复并返回之后就会直接跳转到 __restore ,此时栈顶是一个我们构造出来第一次进入用户态执行的 Trap 上下文,就和第二章的情况一样了。

需要注意的是, __restore 的实现需要做出变化:它 不再需要 在开头 mv sp, a0 了。因为在 __switch 之后,sp 就已经正确指向了我们需要的 Trap 上下文地址。

在 rust_main 中我们调用 task::run_first_task 来开始应用的执行:

1// os/src/task/mod.rs

2

3impl TaskManager {

4 fn run_first_task(&self) {

5 self.inner.borrow_mut().tasks[0].task_status = TaskStatus::Running;

6 let next_task_cx_ptr2 = self.inner.borrow().tasks[0].get_task_cx_ptr2();

7 let _unused: usize = 0;

8 unsafe {

9 __switch(

10 &_unused as *const _,

11 next_task_cx_ptr2,

12 );

13 }

14 }

15}

16

17pub fn run_first_task() {

18 TASK_MANAGER.run_first_task();

19}这里我们取出即将最先执行的编号为 0 的应用的 task_cx_ptr2 并希望能够切换过去。注意 __switch 有两个参数分别表示当前应用和即将切换到的应用的

task_cx_ptr2 ,其第一个参数存在的意义是记录当前应用的任务上下文被保存在哪里,也就是当前应用内核栈的栈顶,这样之后才能继续执行该应用。但在 run_first_task 的时候,我们并没有执行任何应用, __switch 前半部分的保存仅仅是在启动栈上保存了一些之后不会用到的数据,自然也无需记录启动栈栈顶的位置。

因此,我们显式声明了一个 _unused 变量,并将它的地址作为第一个参数传给 __switch ,这样保存一些寄存器之后的启动栈栈顶的位置将会保存在此变量中。然而无论是此变量还是启动栈我们之后均不会涉及到,一旦应用开始运行,我们就开始在应用的用户栈和内核栈之间开始切换了。这里声明此变量的意义仅仅是为了避免覆盖到其他数据。

如果应用自己很少 yield ,内核就要开始收回之前下放的权力,由它自己对 CPU 资源进行集中管理并合理分配给各应用,这就是内核需要提供的任务调度能力。我们可以将多道程序的调度机制分类成 协作式调度 (Cooperative Scheduling) ,因为它的特征是:只要一个应用不主动 yield 交出 CPU 使用权,它就会一直执行下去。与之相对, 抢占式调度 (Preemptive Scheduling) 则是应用 随时 都有被内核切换出去的可能。

现代的任务调度算法基本都是抢占式的,它要求每个应用只能连续执行一段时间,然后内核就会将它强制性切换出去。一般将 时间片 (Time Slice) 作为应用连续执行时长的度量单位,每个时间片可能在毫秒量级。调度算法需要考虑:每次在换出之前给一个应用多少时间片去执行,以及要换入哪个应用。可以从性能和 公平性 (Fairness) 两个维度来评价调度算法,后者要求多个应用分到的时间片占比不应差距过

以内核所在的 S 特权级为例,中断屏蔽相应的 CSR 有 sstatus 和 sie 。sstatus 的 sie 为 S 特权级的中断使能,能够同时控制三种中断,如果将其清零则会将它们全部屏蔽。即使 sstatus.sie 置 1 ,还要看 sie 这个 CSR,它的三个字段 ssie/stie/seie 分别控制 S 特权级的软件中断、时钟中断和外部中断的中断使能。比如对于 S 态时钟中断来说,如果 CPU 不高于 S 特权级,需要 sstatus.sie 和 sie.stie 均为 1 该中断才不会被屏蔽;如果 CPU 当前特权级高于 S 特权级,则该中断一定会被屏蔽

在正文中我们只需要了解:

- 包括系统调用(即来自 U 特权级的环境调用)在内的所有异常都会 Trap 到 S 特权级处理;

- 只需考虑 S 特权级的时钟/软件/外部中断,且它们都会被 Trap 到 S 特权级处理。

默认情况下,当 Trap 进入某个特权级之后,在 Trap 处理的过程中同特权级的中断都会被屏蔽。这里我们还需要对第二章介绍的 Trap 发生时的硬件机制做一下补充,同样以 Trap 到 S 特权级为例:

- 当 Trap 发生时,

sstatus.sie会被保存在sstatus.spie字段中,同时sstatus.sie置零,这也就在 Trap 处理的过程中屏蔽了所有 S 特权级的中断; - 当 Trap 处理完毕

sret的时候,sstatus.sie会恢复到sstatus.spie内的值。

也就是说,如果不去手动设置 sstatus CSR ,在只考虑 S 特权级中断的情况下,是不会出现 嵌套中断 (Nested Interrupt) 的。嵌套中断是指在处理一个中断的过程中再一次触发了中断从而通过 Trap 来处理。由于默认情况下一旦进入 Trap 硬件就自动禁用所有同特权级中断,自然也就不会再次触发中断导致嵌套中断了。

一个计数器统计处理器自上电以来经过了多少个内置时钟的时钟周期,计数器保存在一个 64 位的 CSR mtime 中,我们无需担心它的溢出问题,在内核运行全程可以认为它是一直递增的。

另外一个 64 位的 CSR mtimecmp 的作用是:一旦计数器 mtime 的值超过了 mtimecmp,就会触发一次时钟中断。这使得我们可以方便的通过设置 mtimecmp 的值来决定下一次时钟中断何时触发。

总结两个计数器:分别记录mtime ,mtimecmp

mtime: 记录当前的总共的时钟周期

了避免 S 特权级时钟中断被屏蔽,我们需要在执行第一个应用之前进行一些初始化设置:

#[no_mangle]

pub fn rust_main() -> ! {

clear_bss();

println!("[kernel] Hello, world!");

trap::init(); //init在这个时候调用---------设置trap函数入口地址

loader::load_apps(); //加载APP进入内存,通过(data段)link_app.s的设置

trap::enable_timer_interrupt(); //第 9 行设置了 sie.stie 使得 S 特权级时钟中断不会被屏蔽;

timer::set_next_trigger(); //设置时间片 10ms 的计时器

task::run_first_task(); // 开启任务的执行

panic!("Unreachable in rust_main!");

}

pub fn enable_timer_interrupt() {

unsafe{

sie::set_stimer(); //设置了 sie.stie 使得 S 特权级时钟中断不会被屏蔽;

}

}- 第 9 行设置了

sie.stie使得 S 特权级时钟中断不会被屏蔽; - 第 10 行则是设置第一个 10ms 的计时器。

这样,当一个应用运行了 10ms 之后,一个 S 特权级时钟中断就会被触发。由于应用运行在 U 特权级,且 sie 寄存器被正确设置,该中断不会被屏蔽,而是 Trap 到 S 特权级内的我们的 trap_handler 里面进行处理,并顺利切换到下一个应用。这便是我们所期望的抢占式调度机制。从应用运行的结果也可以看出,三个 power 系列应用并没有进行 yield ,而是由内核负责公平分配它们执行的时间片。

这里我们先通过 yield 来优化 轮询 (Busy Loop) 过程带来的 CPU 资源浪费。在 03sleep 这个应用中:

// user/src/bin/03sleep.rs

#[no_mangle]

fn main() -> i32 {

let current_timer = get_time();

let wait_for = current_timer + 3000;

while get_time() < wait_for {

yield_();

}

println!("Test sleep OK!");

0

}它的功能是等待 3000ms 然后退出。可以看出,我们会在循环里面 yield_ 来主动交出 CPU 而不是无意义的忙等。尽管我们不这样做

,已有的抢占式调度还是会在它循环 10ms 之后切换到其他应用,但是这样能让内核给其他应用分配更多的 CPU 资源并让它们更早运行结束。

如果要实现动态内存分配的能力,需要操作系统需要有如下功能:

- 初始时能提供一块大内存空间作为初始的“堆”。在没有分页机制情况下,这块空间是物理内存空间,否则就是虚拟内存空间。

- 提供在堆上分配一块内存的函数接口。这样函数调用方就能够得到一块地址连续的空闲内存块进行读写。

- 提供释放内存的函数接口。能够回收内存,以备后续的内存分配请求。

- 提供空闲空间管理的连续内存分配算法。能够有效地管理空闲快,这样就能够动态地维护一系列空闲和已分配的内存块。

- (可选)提供建立在堆上的数据结构和操作。有了上述基本的内存分配与释放函数接口,就可以实现类似动态数组,动态字典等空间灵活可变的堆数据结构,提高编程的灵活性。

动态缺点:它背后运行着连续内存分配算法,相比静态分配会带来一些额外的开销。如果动态分配非常频繁,可能会产生很多无法使用的空闲空间碎片,甚至可能会成为应用的性能瓶颈。

静态缺点:它在编译期间确定大小,分配时候可能会由于文件大小不确定导致内存不够或者内存过大,导致应用效率降低

- 裸指针

*const T/*mut T基本等价于 C/C++ 里面的普通指针T*,它自身的内容仅仅是一个地址。它最为灵活, 但是也最不安全。编译器只能对它进行最基本的可变性检查, 第一章 曾经提到,对于裸指针 解引用访问它指向的那块数据是 unsafe 行为,需要被包裹在 unsafe 块中。 - 引用

&T/&mut T自身的内容也仅仅是一个地址,但是 Rust 编译器会在编译的时候进行比较严格的 借用检查 (Borrow Check) ,要求引用的生命周期必须在被借用的变量的生命周期之内,同时可变借用和不可变借用不能共存,一个 变量可以同时存在多个不可变借用,而可变借用同时最多只能存在一个。这能在编译期就解决掉很多内存不安全问题。 - 智能指针不仅包含它指向的区域的地址,还含有一些额外的信息,因此这个类型的字节大小大于平台的位宽,属于一种胖指针。 从用途上看,它不仅可以作为一个媒介来访问它指向的数据,还能在这个过程中起到一些管理和控制的功能。

在 Rust 中,与动态内存分配相关的智能指针有如下这些:

-

Box<T>在创建时会在堆上分配一个类型为T的变量,它自身也只保存在堆上的那个变量的位置。而和裸指针或引用 不同的是,当Box<T>被回收的时候,它指向的——也就是在堆上被动态分配的那个变量也会被回收。 -

Rc<T>是一个单线程上使用的引用计数类型,Arc<T>与其功能相同,只是它可以在多线程上使用。它提供了 多所有权,也即地址空间中同时可以存在指向同一个堆上变量的Rc<T>,它们都可以拿到指向变量的不可变引用来 访问这同一个变量。而它同时也是一个引用计数,事实上在堆上的另一个位置维护了堆上这个变量目前被引用了多少次, 也就是存在多少个Rc<T>。这个计数会随着Rc<T>的创建或复制而增加,并当Rc<T>生命周期结束 被回收时减少。当这个计数变为零之后,这个计数变量本身以及被引用的变量都会从堆上被回收。 -

Mutex<T>是一个互斥锁,在多线程中使用,它可以保护里层被动态分配到堆上的变量同一时间只有一个线程能对它 进行操作,从而避免数据竞争,这是并发安全的问题,会在后面详细说明。同时,它能够提供 内部可变性 。Mutex<T>时常和Arc<T>配套使用,因为它是用来 保护多个线程可能同时访问的数据,其前提就是多个线程都拿到指向同一块堆上数据的Mutex<T>。于是,要么就是 这个Mutex<T>作为全局变量被分配到数据段上,要么就是我们需要将Mutex<T>包裹上一层多所有权变成Arc<Mutex<T>>,让它可以在线程间进行传递。请记住Arc<Mutex<T>>这个经典组合,我们后面会经常用到。之前我们通过

RefCell<T>来获得内部可变性。可以将Mutex<T>看成RefCell<T>的多线程版本, 因为RefCell<T>是只能在单线程上使用的。而且RefCell<T>并不会在堆上分配内存,它仅用到静态内存 分配。

随后,是一些 集合 (Collection) 或称 容器 (Container) 类型,它们负责管理一组数目可变的元素,这些元素 的类型相同或是有着一些同样的特征。在 C++/Python/Java 等高级语言中我们已经对它们的使用方法非常熟悉了,对于 Rust 而言,我们则可以直接使用以下容器:

- 向量

Vec<T>类似于 C++ 中的std::vector; - 键值对容器

BTreeMap<K, V>类似于 C++ 中的std::map; - 有序集合

BTreeSet<T>类似于 C++ 中的std::set; - 链表

LinkedList<T>类似于 C++ 中的std::list; - 双端队列

VecDeque<T>类似于 C++ 中的std::deque。 - 变长字符串

String类似于 C++ 中的std::string。

- C 语言仅支持

malloc/free这一对操作,它们必须恰好成对使用,否则就会出现错误。比如分配了之后没有回收,则会导致 内存溢出;回收之后再次 free 相同的指针,则会造成 Double-Free 问题;又如回收之后再尝试通过指针访问它指向的区域,这 属于 Use-After-Free 问题。总之,这样的内存安全问题层出不穷,毕竟人总是会犯错的。 - Python/Java 通过 引用计数 (Reference Counting) 对所有的对象进行运行时的动态管理,一套 垃圾回收 (GC, Garbage Collection) 机制会被自动定期触发,每次都会检查所有的对象,如果其引用计数为零则可以将该对象占用的内存 从堆上回收以待后续其他的对象使用。这样做完全杜绝了内存安全问题,但是性能开销则很大,而且 GC 触发的时机和每次 GC 的 耗时都是无法预测的,还使得性能不够稳定。

C++ 的 资源获取即初始化 (RAII, Resource Acquisition Is Initialization) 风格则致力于解决上述问题。 RAII 的含义是说,将一个使用前必须获取的资源的生命周期绑定到一个变量上。以 Box<T> 为例,在它被 创建的时候,会在堆上分配一块空间保存它指向的数据;而在 Box<T> 生命周期结束被回收的时候,堆上的那块空间也会 立即被一并回收。这也就是说,我们无需手动回收资源,它会和绑定到的变量同步由编译器自动回收,我们既不用担心忘记回收更不 可能回收多次;同时,由于我们很清楚一个变量的生命周期,则该资源何时被回收也是完全可预测的,我们也明确知道这次回收 操作的开销。在 Rust 中,不限于堆内存,将某种资源的生命周期与一个变量绑定的这种 RAII 的思想无处不见,甚至这种资源 可能只是另外一种类型的变量。

alloc 库需要我们提供给它一个 全局的动态内存分配器 ,它会利用该分配器来管理堆空间,从而使得它提供的堆数据结构可以正常 工作。具体而言,我们的动态内存分配器需要实现它提供的 GlobalAlloc Trait,这个 Trait 有两个必须实现的抽象接口:

// alloc::alloc::GlobalAlloc

pub unsafe fn alloc(&self, layout: Layout) -> *mut u8;

pub unsafe fn dealloc(&self, ptr: *mut u8, layout: Layout);可以看到,它们类似 C 语言中的 malloc/free ,分别代表堆空间的分配和回收,也同样使用一个裸指针(也就是地址) 作为分配的返回值和回收的参数。两个接口中都有一个 alloc::alloc::Layout 类型的参数, 它指出了分配的需求,分为两部分,分别是所需空间的大小 size ,以及返回地址的对齐要求 align 。这个对齐要求 必须是一个 2 的幂次,单位为字节数,限制返回的地址必须是 align 的倍数。

为何 C 语言 malloc 的时候不需要提供对齐需求?

在 C 语言中,所有对齐要求的最大值是一个平台有关的很小的常数(比如8 bytes),消耗少量内存即可使得每一次分配都符合这个最大 的对齐要求。因此也就不需要区分不同分配的对齐要求了。而在 Rust 中,某些分配的对齐要求可能很大,就只能采用更 加复杂的方法。

之后,只需将我们的动态内存分配器类型实例化为一个全局变量,并使用 #[global_allocator] 语义项标记即可。由于该 分配器的实现比较复杂,我们这里直接使用一个已有的伙伴分配器实现。首先添加 crate 依赖:

# os/Cargo.toml

buddy_system_allocator = "0.6"接着,需要引入 alloc 库的依赖,由于它算是 Rust 内置的 crate ,我们并不是在 Cargo.toml 中进行引入,而是在 main.rs 中声明即可:

// os/src/main.rs

extern crate alloc;// as_ref和Borrow的区别 ?

// as_ref 是转引用函数, 将具有所有权对象转换成引用对象,

// 不改变被转换对象的基础上产生一个引用对象.

// as_ref 并不是所有类型都默认支持, 很多时候都需要自己去声明.

// as_ref 是AsRef trait 的公共接口方法.

// 只有那些实现了 as_ref 公共接口方法的类型才能使用as_ref.

// 目前: Option, Box, Result 这三种类型默认提供支持as_ref.

// as_ref 和 Borrow 的区别是:

// 基础数据类型引用:

// Borrow 可以直接在 int, &str, String, vec, [], struct, enum 这种类型上直接指定&来引用.

// as_ref 则不行, 它需要声明泛型T: AsRef<int>, T: AsRef<str>, T: AsRef<struct name> 来支持.

// 嵌套数据类型引用: Some(&int) , Box(&int) ,

// Borrow 必须在定义结构时声明 Some<&int> , Box<&int> 才是引用.

// as_ref 则直接可以在这些嵌套结构上使用as_ref.

// 引用的引用

// Borrow 引用的引用的表现形式是: &str -> &&str

// as_ref 引用的引用的表现形式是: &str -> &str最终,到目前为止仍被操作系统内核广泛使用的抽象被称为 地址空间 (Address Space) 。某种程度上讲,可以将它看成一块 巨大但并不一定真实存在的内存。在每个应用程序的视角里,操作系统分配给应用程序一个范围有限(但其实很大),独占的连续地址空间(其中有些地方被操作系统限制不能访问,如内核本身占用的虚地址空间等),因此应用程序可以在划分给它的地址空间中随意规划内存布局,它的 各个段也就可以分别放置在地址空间中它希望的位置(当然是操作系统允许应用访问的地址)。应用同样可以使用一个地址作为索引来读写自己地址空间的数据,就像用物理地址 作为索引来读写物理内存上的数据一样。这种地址被称为 虚拟地址 (Virtual Address) 。当然,操作系统要达到 地址空间 抽象的设计目标,需要有计算机硬件的支持,这就是计算机组成原理课上讲到的 MMU 和 TLB 等硬件机制。

从此,应用能够直接看到并访问的内存就只有操作系统提供的地址空间,且它的任何一次访存使用的地址都是虚拟地址,无论取指令来执行还是读写 栈、堆或是全局数据段都是如此。事实上,特权级机制被拓展,使得应用不再具有通过物理地址直接访问物理内存的能力。应用所处的执行环境在安全方面被进一步强化,形成了用户态特权级和地址空间的二维安全措施。

由于每个应用独占一个地址空间,里面只含有自己的各个段,于是它可以随意规划 各个段的分布而无需考虑和其他应用冲突;同时,它完全无法窃取或者破坏其他应用的数据,毕竟那些段在其他应用的地址空间 内,鉴于应用只能通过虚拟地址读写它自己的地址空间,这是它没有能力去访问的。这是 地址空间 抽象对应用程序执行的安全性和稳定性的一种保障。

开始回顾一下 计算机组成原理 课。如上图所示,当应用取指或者执行 一条访存指令的时候,它都是在以虚拟地址为索引读写自己的地址空间。此时,CPU 中的 内存管理单元 (MMU, Memory Management Unit) 自动将这个虚拟地址进行 地址转换 (Address Translation) 变为一个物理地址, 也就是物理内存上这个应用的数据真实被存放的位置。也就是说,在 MMU 的帮助下,应用对自己地址空间的读写才能被实际转化为 对于物理内存的访问。

事实上,每个应用的地址空间都可以看成一个从虚拟地址到物理地址的映射。可以想象对于不同的应用来说,该映射可能是不同的, 即 MMU 可能会将来自不同两个应用地址空间的相同虚拟地址翻译成不同的物理地址。要做到这一点,就需要硬件提供一些寄存器 ,软件可以对它进行设置来控制 MMU 按照哪个应用的地址空间进行地址转换。于是,将应用的数据放到物理内存并进行管理,而 在任务切换的时候需要将控制 MMU 选用哪个应用的地址空间进行映射的那些寄存器也一并进行切换,则是作为软件部分的内核需 要完成的工作。

地址空间只是一层抽象接口,它有很多种具体的实现策略。对于不同的实现策略来说,操作系统内核如何规划应用数据放在物理内存的位置, 而 MMU 又如何进行地址转换也都是不同的。下面我们简要介绍几种曾经被使用的策略,并探讨它们的优劣。

注意:

为了方便实现虚拟页面到物理页帧的地址转换,我们给每个虚拟页面和物理页帧一个编号,分别称为 虚拟页号 (VPN, Virtual Page Number) 和 物理页号 (PPN, Physical Page Number) 。每个应用都有一个不同的 页表 (Page Table)

虚拟地址到物理地址的转换过程:

当 MMU 进行地址转换的时候,它首先找到给定的虚拟地址所在的虚拟页面的页号,然后查当前应用的页表根据虚拟页号 找到物理页号,最后按照虚拟地址在它所在的虚拟页面中的相对位置相应给物理页号对应的物理页帧的起始地址加上一个偏移量, 这就得到了实际访问的物理地址。

这种思想在计算机科学中得到了广泛应用:为了方便接下来的说明,我们可以举一道数据结构的题目作为例子。设想我们要维护 一个字符串的多重集,集合中所有的字符串的字符集均为 α={a,b,c} ,长度均为一个给定的常数 n 。该字符串集合一开始为空集。我们要支持两种操作,第一种是将一个字符串插入集合,第二种是查询一个字符串在当前 的集合中出现了多少次。

简单起见,假设 n=3 。那么我们可能会建立这样一颗 字典树 (Trie)

字典树由若干个节点(图中用椭圆形来表示)组成,从逻辑上而言每个节点代表一个可能的字符串前缀。每个节点的存储内容 都只有三个指针,对于蓝色的非叶节点来说,它的三个指针各自指向一个子节点;而对于绿色的叶子节点来说,它的三个指针不再指向 任何节点,而是具体保存一种可能的长度为 n 的字符串的计数。这样,对于题目要求的两种操作,我们只需根据输入的 字符串中的每个字符在字典树上自上而下对应走出一步,最终就能够找到字典树中维护的它的计数。之后我们可以将其直接返回或者 加一。

注意到如果某些字符串自始至终没有被插入,那么一些节点没有存在的必要。反过来说一些节点是由于我们插入了一个以它对应的字符串 为前缀的字符串才被分配出来的。如下图所示:

一开始仅存在一个根节点。在我们插入字符串 acb 的过程中,我们只需要分配 a 和 ac 两个节点。 注意 ac 是一个叶节点,它的 b 指针不再指向另外一个节点而是保存字符串 acb 的计数。 此时我们无法访问到其他未分配的节点,如根节点的 b/c 或是 a 节点的 a/b 均为空指针。 如果后续再插入一个字符串,那么 至多分配两个新节点 ,因为如果走的路径上有节点已经存在,就无需重复分配了。 这可以说明,字典树中节点的数目(或者说字典树消耗的内存)是随着插入字符串的数目逐渐线性增加的。

读者可能很好奇,为何在这里要用相当一部分篇幅来介绍字典树呢?事实上 SV39 分页机制等价于一颗字典树。 27 位的 虚拟页号可以看成一个长度 n=3 的字符串,字符集为 α={0,1,2,...,511} ,因为每一位字符都 由 9 个比特组成。而我们也不再维护所谓字符串的计数,而是要找到字符串(虚拟页号)对应的页表项。 因此,每个叶节点都需要保存 512 个 8 字节的页表项,一共正好 4KiB , 可以直接放在一个物理页帧内。而对于非叶节点来说,从功能上它只需要保存 512 个指向下级节点的指针即可, 不过我们就像叶节点那样也保存 512 个页表项,这样所有的节点都可以被放在一个物理页帧内,它们的位置可以用一个 物理页号来代替。当想从一个非叶节点向下走时,只需找到当前字符对应的页表项的物理页号字段,它就指向了下一级节点的位置, 这样非叶节点中转的功能也就实现了。每个节点的内部是一个线性表,也就是将这个节点起始物理地址加上字符对应的偏移量就找到了 指向下一级节点的页表项(对于非叶节点)或是能够直接用来地址转换的页表项(对于叶节点)。

这种页表实现被称为 多级页表 (Multi-Level Page-Table) 。由于 SV39 中虚拟页号被分为三级 页索引 (Page Index) ,因此这是一种三级页表。

非叶节点的页表项标志位含义和叶节点相比有一些不同:

- 当 V 为 0 的时候,代表当前指针是一个空指针,无法走向下一级节点,即该页表项对应的虚拟地址范围是无效的;

- 只有当V 为1 且 R/W/X 均为 0 时,表示是一个合法的页目录表项,其包含的指针会指向下一级的页表。

- 注意: 当V 为1 且 R/W/X 不全为 0 时,表示是一个合法的页表项,其包含了虚地址对应的物理页号。

在这里我们给出 SV39 中的 R/W/X 组合的含义:

这里总结一下之前的内存的各个段都干什么了

- 0x80200000:物理内存的 起始物理地址。该处开始存放各个数据段的布局,例如rodata,bss,data,还有处于.bss段的栈

- 0x80400000:该处开始存放内核段代码,例如各个应用的代码

- 0x80800000:硬编码整块物理内存的终止物理地址

这意味着我们总共能使用的内存是8mb

我们用一个左闭右开的物理页号区间来表示 可用的物理内存,则:

- 区间的左端点应该是

ekernel的物理地址以上取整方式转化成的物理页号; - 区间的右端点应该是

MEMORY_END以下取整方式转化成的物理页号。

初始化非常简单。在通过 FrameAllocator 的 new 方法创建实例的时候,只需将区间两端均设为 0 , 然后创建一个新的向量;而在它真正被使用起来之前,需要调用 init 方法将自身的 [current,end) 初始化为可用物理页号区间:

// os/src/mm/frame_allocator.rs

impl FrameAllocator for StackFrameAllocator {

fn new() -> Self {

Self {

current: 0,

end: 0,

recycled: Vec::new(),

}

}

}

impl StackFrameAllocator {

pub fn init(&mut self, l: PhysPageNum, r: PhysPageNum) {

self.current = l.0;

self.end = r.0;

}

}

接下来我们来看核心的物理页帧分配和回收如何实现:

// os/src/mm/frame_allocator.rs

impl FrameAllocator for StackFrameAllocator {

fn alloc(&mut self) -> Option<PhysPageNum> {

if let Some(ppn) = self.recycled.pop() {

Some(ppn.into())

} else {

if self.current == self.end {

None

} else {

self.current += 1;

Some((self.current - 1).into())

}

}

}

fn dealloc(&mut self, ppn: PhysPageNum) {

let ppn = ppn.0;

// validity check

if ppn >= self.current || self.recycled

.iter()

.find(|&v| {*v == ppn})

.is_some() {

panic!("Frame ppn={:#x} has not been allocated!", ppn);

}

// recycle

self.recycled.push(ppn);

}

}

-

在分配

alloc的时候,首先会检查栈recycled内有没有之前回收的物理页号,如果有的话直接弹出栈顶并返回; 否则的话我们只能从之前从未分配过的物理页号区间 [current,end) 上进行分配,我们分配它的 左端点current,同时将管理器内部维护的current加一代表current此前已经被分配过了。在即将返回 的时候,我们使用into方法将 usize 转换成了物理页号PhysPageNum。注意极端情况下可能出现内存耗尽分配失败的情况:即

recycled为空且 current==end 。 为了涵盖这种情况,alloc的返回值被Option包裹,我们返回None即可。 -

在回收

dealloc的时候,我们需要检查回收页面的合法性,然后将其压入recycled栈中。回收页面合法有两个 条件:- 该页面之前一定被分配出去过,因此它的物理页号一定 <current ;

- 该页面没有正处在回收状态,即它的物理页号不能在栈

recycled中找到。

我们通过

recycled.iter()获取栈上内容的迭代器,然后通过迭代器的find方法试图 寻找一个与输入物理页号相同的元素。其返回值是一个Option,如果找到了就会是一个Option::Some, 这种情况说明我们内核其他部分实现有误,直接报错退出。

下面我们来创建 StackFrameAllocator 的全局实例 FRAME_ALLOCATOR :

// os/src/mm/frame_allocator.rs

use spin::Mutex;

type FrameAllocatorImpl = StackFrameAllocator;

lazy_static! {

pub static ref FRAME_ALLOCATOR: Mutex<FrameAllocatorImpl> =

Mutex::new(FrameAllocatorImpl::new());

}

这里我们使用互斥锁 Mutex<T> 来包裹栈式物理页帧分配器。每次对该分配器进行操作之前,我们都需要先通过 FRAME_ALLOCATOR.lock() 拿到分配器的可变借用。注意 alloc 中并没有提供 Mutex<T> ,它 来自于一个我们在 no_std 的裸机环境下经常使用的名为 spin 的 crate ,它仅依赖 Rust 核心库 core 提供一些可跨平台使用的同步原语,如互斥锁 Mutex<T> 和读写锁 RwLock<T> 等。

注解

Rust 语法卡片:在单核环境下使用 Mutex 的原因

在编写一个多线程的应用时,加锁的目的是为了避免数据竞争,使得里层的共享数据结构同一时间只有一个线程 在对它进行访问。然而,目前我们的内核运行在单 CPU 上,且 Trap 进入内核之后并没有手动打开中断,这也就 使得同一时间最多只有一条 Trap 执行流并发访问内核的各数据结构,此时应该是并没有任何数据竞争风险的。那么 加锁的原因其实有两点:

-

在不触及

unsafe的情况下实现static mut语义。如果读者还有印象, 前面章节 我们使用RefCell<T>提供了内部可变性去掉了 声明中的mut,然而麻烦的在于static,在 Rust 中一个类型想被实例化为一个全局变量,则 该类型必须先告知编译器自己某种意义上是线程安全的,这个过程本身是unsafe的。因此我们直接使用

Mutex<T>,它既通过lock方法提供了内部可变性,又已经在模块内部告知了 编译器它的线程安全性。这样unsafe就被隐藏在了spincrate 之内,我们无需关心。这种风格 是 Rust 所推荐的。 -

方便后续拓展到真正存在数据竞争风险的多核环境下运行。

这里引入了一些新概念,比如什么是线程,又如何定义线程安全?读者可以先不必深究,暂时有一个初步的概念即可。

可以发现, frame_alloc 的返回值类型并不是 FrameAllocator 要求的物理页号 PhysPageNum ,而是将其 进一步包装为一个 FrameTracker 。这里借用了 RAII 的思想,将一个物理页帧的生命周期绑定到一个 FrameTracker 变量上,当一个 FrameTracker 被创建的时候,我们需要从 FRAME_ALLOCATOR 中分配一个物理页帧:

Rust 语法卡片:Drop Trait

Rust 中的 Drop Trait 是它的 RAII 内存管理风格可以被有效实践的关键。之前介绍的多种在堆上分配的 Rust 数据结构便都是通过实现 Drop Trait 来进行被绑定资源的自动回收的。例如:

Box<T>的drop方法会回收它控制的分配在堆上的那个变量;Rc<T>的drop方法会减少分配在堆上的那个引用计数,一旦变为零则分配在堆上的那个被计数的变量自身 也会被回收;Mutex<T>的lock方法会获取互斥锁并返回一个MutexGuard<'a, T>,它可以被当做一个&mut T来使用;而MutexGuard<'a, T>的drop方法会将锁释放,从而允许其他线程获取锁并开始访问里层的 数据结构。锁的实现原理我们先不介绍。

FrameTracker 的设计也是基于同样的思想,有了它之后我们就不必手动回收物理页帧了,这在编译期就解决了很多 潜在的问题。

我们知道,SV39 多级页表是以节点为单位进行管理的。每个节点恰好存储在一个物理页帧中,它的位置可以用一个物理页号来 表示。

1// os/src/mm/page_table.rs

2

3pub struct PageTable {

4 root_ppn: PhysPageNum,

5 frames: Vec<FrameTracker>,

6}

7

8impl PageTable {

9 pub fn new() -> Self {

10 let frame = frame_alloc().unwrap();

11 PageTable {

12 root_ppn: frame.ppn,

13 frames: vec![frame],

14 }

15 }

16}

每个应用的地址空间都对应一个不同的多级页表,这也就意味这不同页表的起始地址(即页表根节点的地址)是不一样的。因此 PageTable 要保存它根节点的物理页号 root_ppn 作为页表唯一的区分标志。此外, 向量 frames 以 FrameTracker 的形式保存了页表所有的节点(包括根节点)所在的物理页帧。这与物理页帧管理模块 的测试程序是一个思路,即将这些 FrameTracker 的生命周期进一步绑定到 PageTable 下面。当 PageTable 生命周期结束后,向量 frames 里面的那些 FrameTracker 也会被回收,也就意味着存放多级页表节点的那些物理页帧 被回收了。

当我们通过 new 方法新建一个 PageTable 的时候,它只需有一个根节点。为此我们需要分配一个物理页帧 FrameTracker 并挂在向量 frames 下,然后更新根节点的物理页号 root_ppn 。

多级页表并不是被创建出来之后就不再变化的,为了 MMU 能够通过地址转换正确找到应用地址空间中的数据实际被内核放在内存中 位置,操作系统需要动态维护一个虚拟页号到页表项的映射,支持插入/删除键值对,其方法签名如下:

// os/src/mm/page_table.rs

impl PageTable {

pub fn map(&mut self, vpn: VirtPageNum, ppn: PhysPageNum, flags: PTEFlags);

pub fn unmap(&mut self, vpn: VirtPageNum);

}

- 我们通过

map方法来在多级页表中插入一个键值对,注意这里我们将物理页号ppn和页表项标志位flags作为 不同的参数传入而不是整合为一个页表项; - 相对的,我们通过

unmap方法来删除一个键值对,在调用时仅需给出作为索引的虚拟页号即可。

在这些操作的过程中我们自然需要访问或修改多级页表节点的内容。每个节点都被保存在一个物理页帧中,在多级页表的架构中我们是以 一个节点被存放在的物理页帧的物理页号作为指针指向该节点,这意味着,对于每个节点来说,一旦我们知道了指向它的物理页号,我们 就需要能够修改这个节点的内容。前面我们在使用 frame_alloc 分配一个物理页帧之后便立即将它上面的数据清零其实也是一样 的需求。总结一下也就是说,至少在操作某个多级页表或是管理物理页帧的时候,我们要能够自由的读写与一个给定的物理页号对应的 物理页帧上的数据。

在尚未启用分页模式之前,内核和应用的代码都可以通过物理地址直接访问内存。而在打开分页模式之后,分别运行在 S 特权级 和 U 特权级的内核和应用的访存行为都会受到影响,它们的访存地址会被视为一个当前地址空间( satp CSR 给出当前 多级页表根节点的物理页号)中的一个虚拟地址,需要 MMU 查相应的多级页表完成地址转换变为物理地址,也就是地址空间中虚拟地址指向的数据真正被内核放在的物理内存中的位置,然后 才能访问相应的数据。此时,如果想要访问一个特定的物理地址 pa 所指向的内存上的数据,就需要对应 构造 一个虚拟地址 va ,使得当前地址空间的页表存在映射 va→pa ,且页表项中的保护位允许这种 访问方式。于是,在代码中我们只需访问地址 va ,它便会被 MMU 通过地址转换变成 pa ,这样我们就做到了在启用 分页模式的情况下也能从某种意义上直接访问内存。

这就需要我们提前扩充多级页表维护的映射,使得对于每

它的 vpn 。这里我们采用一种最 简单的 恒等映射 (Identical Mapping) ,也就是说对于物理内存上的每个物理页帧,我们都在多级页表中用一个与其 物理页号相等的虚拟页号映射到它。当我们想针对物理页号构造一个能映射到它的虚拟页号的时候,也只需使用一个和该物理页号 相等的虚拟页号即可。

注解

其他的映射方式

为了达到这一目的还存在其他不同的映射方式,例如比较著名的 页表自映射 (Recursive Mapping) 等。有兴趣的同学 可以进一步参考 BlogOS 中的相关介绍 。

这里需要说明的是,在下一节中我们可以看到,应用和内核的地址空间是隔离的。而直接访问物理页帧的操作只会在内核中进行, 应用无法看到物理页帧管理器和多级页表等内核数据结构。因此,上述的恒等映射只需被附加到内核地址空间即可。

于是,我们来看看在内核中应如何访问一个特定的物理页帧:

// os/src/mm/address.rs

impl PhysPageNum {

pub fn get_pte_array(&self) -> &'static mut [PageTableEntry] {

let pa: PhysAddr = self.clone().into();

unsafe {

core::slice::from_raw_parts_mut(pa.0 as *mut PageTableEntry, 512)

}

}

pub fn get_bytes_array(&self) -> &'static mut [u8] {

let pa: PhysAddr = self.clone().into();

unsafe {

core::slice::from_raw_parts_mut(pa.0 as *mut u8, 4096)

}

}

pub fn get_mut<T>(&self) -> &'static mut T {

let pa: PhysAddr = self.clone().into();

unsafe {

(pa.0 as *mut T).as_mut().unwrap()

}

}

}

我们构造可变引用来直接访问一个物理页号 PhysPageNum 对应的物理页帧,不同的引用类型对应于物理页帧上的一种不同的 内存布局,如 get_pte_array 返回的是一个页表项定长数组的可变引用,可以用来修改多级页表中的一个节点;而 get_bytes_array 返回的是一个字节数组的可变引用,可以以字节为粒度对物理页帧上的数据进行访问,前面进行数据清零 就用到了这个方法; get_mut 是个泛型函数,可以获取一个恰好放在一个物理页帧开头的类型为 T 的数据的可变引用。

在实现方面,都是先把物理页号转为物理地址 PhysAddr ,然后再转成 usize 形式的物理地址。接着,我们直接将它 转为裸指针用来访问物理地址指向的物理内存。在分页机制开启前,这样做自然成立;而开启之后,虽然裸指针被视为一个虚拟地址, 但是上面已经提到这种情况下虚拟地址会映射到一个相同的物理地址,因此在这种情况下也成立。注意,我们在返回值类型上附加了 静态生命周期泛型 'static ,这是为了绕过 Rust 编译器的借用检查,实质上可以将返回的类型也看成一个裸指针,因为 它也只是标识数据存放的位置以及类型。但与裸指针不同的是,无需通过 unsafe 的解引用访问它指向的数据,而是可以像一个 正常的可变引用一样直接访问。

注解

unsafe 真的就是“不安全”吗?

下面是笔者关于 unsafe 一点可能不太正确的理解,不感兴趣的读者可以跳过。

当我们在 Rust 中使用 unsafe 的时候,并不仅仅是为了绕过编译器检查,更是为了告知编译器和其他看到这段代码的程序员: “ 我保证这样做是安全的 ” 。尽管,严格的 Rust 编译器暂时还不能确信这一点。从规范 Rust 代码编写的角度, 我们需要尽可能绕过 unsafe ,因为如果 Rust 编译器或者一些已有的接口就可以提供安全性,我们当然倾向于利用它们让我们 实现的功能仍然是安全的,可以避免一些无谓的心智负担;反之,就只能使用 unsafe ,同时最好说明如何保证这项功能是安全的。

这里简要从内存安全的角度来分析一下 PhysPageNum 的 get_* 系列方法的实现中 unsafe 的使用。为了方便 解释,我们可以将 PhysPageNum 也看成一种 RAII 的风格,即它控制着一个物理页帧资源的访问。首先,这不会导致 use-after-free 的问题,因为在内核运行全期整块物理内存都是可以访问的,它不存在被释放后无法访问的可能性;其次, 也不会导致并发冲突。注意这不是在 PhysPageNum 这一层解决的,而是 PhysPageNum 的使用层要保证任意两个线程 不会同时对一个 PhysPageNum 进行操作。读者也应该可以感觉出这并不能算是一种好的设计,因为这种约束从代码层面是很 难直接保证的,而是需要系统内部的某种一致性。虽然如此,它对于我们这个极简的内核而言算是很合适了。

我们以逻辑段 MapArea 为单位描述一段连续地址的虚拟内存。所谓逻辑段,就是指地址区间中的一段实际可用(即 MMU 通过查多级页表 可以正确完成地址转换)的地址连续的虚拟地址区间,该区间内包含的所有虚拟页面都以一种相同的方式映射到物理页帧,具有可读/可写/可执行等属性。

// os/src/mm/memory_set.rs

pub struct MapArea {

vpn_range: VPNRange,

data_frames: BTreeMap<VirtPageNum, FrameTracker>,

map_type: MapType,

map_perm: MapPermission,

}

其中 VPNRange 描述一段虚拟页号的连续区间,表示该逻辑段在地址区间中的位置和长度。它是一个迭代器,可以使用 Rust 的语法糖 for-loop 进行迭代。有兴趣的读者可以参考 os/src/mm/address.rs 中它的实现。

注解

Rust 语法卡片:迭代器 Iterator

Rust编程的迭代器模式允许你对一个序列的项进行某些处理。迭代器(iterator)是负责遍历序列中的每一项和决定序列何时结束的控制逻辑。对于如何使用迭代器处理元素序列和如何实现 Iterator trait 来创建自定义迭代器的内容,可以参考 Rust 程序设计语言-中文版第十三章第二节

MapType 描述该逻辑段内的所有虚拟页面映射到物理页帧的同一种方式,它是一个枚举类型,在内核当前的实现中支持两种方式:

// os/src/mm/memory_set.rs

#[derive(Copy, Clone, PartialEq, Debug)]

pub enum MapType {

Identical,

Framed,

}

其中 Identical 表示之前也有提到的恒等映射,用于在启用多级页表之后仍能够访问一个特定的物理地址指向的物理内存;而 Framed 则表示对于每个虚拟页面都需要映射到一个新分配的物理页帧。

当逻辑段采用 MapType::Framed 方式映射到物理内存的时候, data_frames 是一个保存了该逻辑段内的每个虚拟页面 和它被映射到的物理页帧 FrameTracker 的一个键值对容器 BTreeMap 中,这些物理页帧被用来存放实际内存数据而不是 作为多级页表中的中间节点。和之前的 PageTable 一样,这也用到了 RAII 的思想,将这些物理页帧的生命周期绑定到它所在的逻辑段 MapArea 下,当逻辑段被回收之后这些之前分配的物理页帧也会自动地同时被回收。

MapPermission 表示控制该逻辑段的访问方式,它是页表项标志位 PTEFlags 的一个子集,仅保留 U/R/W/X 四个标志位,因为其他的标志位仅与硬件的地址转换机制细节相关,这样的设计能避免引入错误的标志位。

// os/src/mm/memory_set.rs

bitflags! {

pub struct MapPermission: u8 {

const R = 1 << 1;

const W = 1 << 2;

const X = 1 << 3;

const U = 1 << 4;

}

}

地址空间是一系列有关联的逻辑段,这种关联一般是指这些逻辑段属于一个运行的程序(目前把一个运行的程序称为任务,后续会称为进程)。用来表明正在运行的应用所在执行环境中的可访问内存空间,在这个内存空间中,包含了一系列的不一定连续的逻辑段。这样我们就有任务的地址空间,内核的地址空间等说法了。地址空间使用 MemorySet 类型来表示:

// os/src/mm/memory_set.rs

pub struct MemorySet {

page_table: PageTable,

areas: Vec<MapArea>,

}

它包含了该地址空间的多级页表 page_table 和一个逻辑段 MapArea 的向量 areas 。注意 PageTable 下 挂着所有多级页表的节点所在的物理页帧,而每个 MapArea 下则挂着对应逻辑段中的数据所在的物理页帧,这两部分 合在一起构成了一个地址空间所需的所有物理页帧。这同样是一种 RAII 风格,当一个地址空间 MemorySet 生命周期结束后, 这些物理页帧都会被回收。

在本章之前,内核和应用代码的访存地址都被视为一个物理地址直接访问物理内存,而在分页模式开启之后,它们都需要通过 MMU 的 地址转换变成物理地址再交给 CPU 的访存单元去访问物理内存。地址空间抽象的重要意义在于 隔离 (Isolation) ,当我们 在执行每个应用的代码的时候,内核需要控制 MMU 使用这个应用地址空间的多级页表进行地址转换。由于每个应用地址空间在创建 的时候也顺带设置好了多级页表使得只有那些存放了它的数据的物理页帧能够通过该多级页表被映射到,这样它就只能访问自己的数据 而无法触及其他应用或是内核的数据。

启用分页模式下,内核代码的访存地址也会被视为一个虚拟地址并需要经过 MMU 的地址转换,因此我们也需要为内核对应构造一个 地址空间,它除了仍然需要允许内核的各数据段能够被正常访问之后,还需要包含所有应用的内核栈以及一个 跳板 (Trampoline) 。我们会在本章的最后一节再深入介绍跳板的机制。

下图是软件看到的 64 位地址空间在 SV39 分页模式下实际可能通过 MMU 检查的最高 256GiB (之前在 这里 中解释过最高和最低 256GiB 的问题):

注意相邻两个内核栈之间会预留一个 保护页面 (Guard Page) ,它是内核地址空间中的空洞,多级页表中并不存在与它相关的映射。 它的意义在于当内核栈空间不足(如调用层数过多或死递归)的时候,代码会尝试访问 空洞区域内的虚拟地址,然而它无法在多级页表中找到映射,便会触发异常,此时控制权会交给 trap handler 对这种情况进行 处理。由于编译器会对访存顺序和局部变量在栈帧中的位置进行优化,我们难以确定一个已经溢出的栈帧中的哪些位置会先被访问, 但总的来说,空洞区域被设置的越大,我们就能越早捕获到这一错误并避免它覆盖其他重要数据。由于我们的内核非常简单且内核栈 的大小设置比较宽裕,在当前的设计中我们仅将空洞区域的大小设置为单个页面。

下面则给出了内核地址空间的低 256GiB 的布局:

四个逻辑段 .text/.rodata/.data/.bss 被恒等映射到物理内存,这使得我们在无需调整内核内存布局 os/src/linker.ld 的情况下就仍能和启用页表机制之前那样访问内核的各数据段。注意我们借用页表机制对这些逻辑段的访问方式做出了限制,这都是为了 在硬件的帮助下能够尽可能发现内核中的 bug ,在这里:

- 四个逻辑段的 U 标志位均未被设置,使得 CPU 只能在处于 S 特权级(或以上)时访问它们;

- 代码段

.text不允许被修改; - 只读数据段

.rodata不允许被修改,也不允许从它上面取指; .data/.bss均允许被读写,但是不允许从它上面取指。

此外, 之前 提到过内核地址空间中需要存在一个恒等映射到内核数据段之外的可用物理 页帧的逻辑段,这样才能在启用页表机制之后,内核仍能以纯软件的方式读写这些物理页帧。它们的标志位仅包含 rw ,意味着该 逻辑段只能在 S 特权级以上访问,并且只能读写。

1// os/src/mm/memory_set.rs

2

3extern "C" {

4 fn stext();

5 fn etext();

6 fn srodata();

7 fn erodata();

8 fn sdata();

9 fn edata();

10 fn sbss_with_stack();

11 fn ebss();

12 fn ekernel();

13 fn strampoline();

14}

15

16impl MemorySet {

17 /// Without kernel stacks.

18 pub fn new_kernel() -> Self {

19 let mut memory_set = Self::new_bare();

20 // map trampoline

21 memory_set.map_trampoline();

22 // map kernel sections

23 println!(".text [{:#x}, {:#x})", stext as usize, etext as usize);

24 println!(".rodata [{:#x}, {:#x})", srodata as usize, erodata as usize);

25 println!(".data [{:#x}, {:#x})", sdata as usize, edata as usize);

26 println!(".bss [{:#x}, {:#x})", sbss_with_stack as usize, ebss as usize);

27 println!("mapping .text section");

28 memory_set.push(MapArea::new(

29 (stext as usize).into(),

30 (etext as usize).into(),

31 MapType::Identical,

32 MapPermission::R | MapPermission::X,

33 ), None);

34 println!("mapping .rodata section");

35 memory_set.push(MapArea::new(

36 (srodata as usize).into(),

37 (erodata as usize).into(),

38 MapType::Identical,

39 MapPermission::R,

40 ), None);

41 println!("mapping .data section");

42 memory_set.push(MapArea::new(

43 (sdata as usize).into(),

44 (edata as usize).into(),

45 MapType::Identical,

46 MapPermission::R | MapPermission::W,

47 ), None);

48 println!("mapping .bss section");

49 memory_set.push(MapArea::new(

50 (sbss_with_stack as usize).into(),

51 (ebss as usize).into(),

52 MapType::Identical,

53 MapPermission::R | MapPermission::W,

54 ), None);

55 println!("mapping physical memory");

56 memory_set.push(MapArea::new(

57 (ekernel as usize).into(),

58 MEMORY_END.into(),

59 MapType::Identical,

60 MapPermission::R | MapPermission::W,

61 ), None);

62 memory_set

63 }

64}

new_kernel 将映射跳板和地址空间中最低 256GiB 中的所有的逻辑段。第 3 行开始,我们从 os/src/linker.ld 中引用了很多表示了各个段位置的符号,而后在 new_kernel 中,我们从低地址到高地址 依次创建 5 个逻辑段并通过 push 方法将它们插入到内核地址空间中,上面我们已经详细介绍过这 5 个逻辑段。跳板 是通过 map_trampoline 方法来映射的,我们也将在本章最后一节进行讲解。

现在我们来介绍如何创建应用的地址空间。在前面的章节中,我们直接将丢弃所有符号的应用二进制镜像链接到内核,在初始化的时候 内核仅需将他们加载到正确的初始物理地址就能使它们正确执行。但本章中,我们希望效仿内核地址空间的设计,同样借助页表机制 使得应用地址空间的各个逻辑段也可以有不同的访问方式限制,这样可以提早检测出应用的错误并及时将其终止以最小化它对系统带来的 恶劣影响。

在第三章中,每个应用链接脚本中的起始地址被要求是不同的,这样它们的代码和数据存放的位置才不会产生冲突。但是这是一种对于应用开发者 极其不友好的设计。现在,借助地址空间的抽象,我们终于可以让所有应用程序都使用同样的起始地址,这也意味着所有应用可以使用同一个链接脚本了:

1/* user/src/linker.ld */

2

3OUTPUT_ARCH(riscv)

4ENTRY(_start)

5

6BASE_ADDRESS = 0x0;

7

8SECTIONS

9{

10 . = BASE_ADDRESS;

11 .text : {

12 *(.text.entry)

13 *(.text .text.*)

14 }

15 . = ALIGN(4K);

16 .rodata : {

17 *(.rodata .rodata.*)

18 }

19 . = ALIGN(4K);

20 .data : {

21 *(.data .data.*)

22 }

23 .bss : {

24 *(.bss .bss.*)

25 }

26 /DISCARD/ : {

27 *(.eh_frame)

28 *(.debug*)

29 }

30}

我们将起始地址 BASE_ADDRESS 设置为 0x0 ,显然它只能是一个地址空间中的虚拟地址而非物理地址。 事实上由于我们将入口汇编代码段放在最低的地方,这也是整个应用的入口点。 我们只需清楚这一事实即可,而无需像之前一样将其硬编码到代码中。此外,在 .text 和 .rodata 中间以及 .rodata 和 .data 中间我们进行了页面对齐,因为前后两个逻辑段的访问方式限制是不同的,由于我们只能以页为单位对这个限制进行设置, 因此就只能将下一个逻辑段对齐到下一个页面开始放置。相对的, .data 和 .bss 两个逻辑段由于限制相同,它们中间 则无需进行页面对齐。

它仅需要提供两个函数: get_num_app 获取链接到内核内的应用的数目,而 get_app_data 则根据传入的应用编号 取出对应应用的 ELF 格式可执行文件数据。它们和之前一样仍是基于 build.rs 生成的 link_app.S 给出的符号来 确定其位置,并实际放在内核的数据段中。 loader 模块中原有的内核和用户栈则分别作为逻辑段放在内核和用户地址空间中,我们无需再去专门为其定义一种类型。

在阅读下面代码的时候请结合这段话

我们可以通过二进制工具 rust-readobj 来看看 ELF 文件中究竟包含什么内容,输入命令:

$ rust-readobj -all target/debug/os

首先可以看到一个 ELF header,它位于 ELF 文件的开头:

1File: target/debug/os

2Format: elf64-x86-64

3Arch: x86_64

4AddressSize: 64bit

5LoadName:

6ElfHeader {

7Ident {

8 Magic: (7F 45 4C 46)

9 Class: 64-bit (0x2)

10 DataEncoding: LittleEndian (0x1)

11 FileVersion: 1

12 OS/ABI: SystemV (0x0)

13 ABIVersion: 0

14 Unused: (00 00 00 00 00 00 00)

15}

16Type: SharedObject (0x3)

17Machine: EM_X86_64 (0x3E)

18Version: 1

19Entry: 0x5070

20ProgramHeaderOffset: 0x40

21SectionHeaderOffset: 0x32D8D0

22Flags [ (0x0)

23]

24HeaderSize: 64

25ProgramHeaderEntrySize: 56

26ProgramHeaderCount: 12

27SectionHeaderEntrySize: 64

28SectionHeaderCount: 42

29StringTableSectionIndex: 41

30}

31......

- 第 8 行是一个称之为 魔数 (Magic) 独特的常数,存放在 ELF header 的一个固定位置。当加载器将 ELF 文件加载到内存之前,通常会查看 该位置的值是否正确,来快速确认被加载的文件是不是一个 ELF 。

- 第 19 行给出了可执行文件的入口点为

0x5070。 - 从 20-21 行中,我们可以知道除了 ELF header 之外,还有另外两种不同的 header,分别称为 program header 和 section header, 它们都有多个。ELF header 中给出了其他两种header 的大小、在文件中的位置以及数目。

- 从 24-27 行中,可以看到有 12 个不同的 program header,它们从文件的 0x40 字节偏移处开始,每个 56 字节; 有64个section header,它们从文件的 0x2D8D0 字节偏移处开始,每个 64 字节;

有多个不同的 section header,下面是个具体的例子:

......

Section {

Index: 14

Name: .text (157)

Type: SHT_PROGBITS (0x1)

Flags [ (0x6)

SHF_ALLOC (0x2)

SHF_EXECINSTR (0x4)

]

Address: 0x5070

Offset: 0x5070

Size: 208067

Link: 0

Info: 0

AddressAlignment: 16

EntrySize: 0

}

每个 section header 则描述一个段的元数据。

其中,我们看到了代码段 .text 需要被加载到地址 0x5070 ,大小 208067 字节,。 它们分别由元数据的字段 Offset、 Size 和 Address 给出。。

我们还能够看到程序中的符号表:

Symbol {

Name: _start (37994)

Value: 0x5070

Size: 47

Binding: Global (0x1)

Type: Function (0x2)

Other: 0

Section: .text (0xE)

}

Symbol {

Name: main (38021)

Value: 0x51A0

Size: 47

Binding: Global (0x1)

Type: Function (0x2)

Other: 0

Section: .text (0xE)

}

里面包括了我们写的 main 函数的地址以及用户态执行环境的起始地址 _start 函数的地址。

因此,从 ELF header 中可以看出,ELF 中的内容按顺序应该是:

- ELF header

- 若干个 program header

- 程序各个段的实际数据

- 若干的 section header

在创建应用地址空间的时候,我们需要对 get_app_data 得到的 ELF 格式数据进行解析,找到各个逻辑段所在位置和访问 限制并插入进来,最终得到一个完整的应用地址空间:

1// os/src/mm/memory_set.rs

2

3impl MemorySet {

4 /// Include sections in elf and trampoline and TrapContext and user stack,

5 /// also returns user_sp and entry point.

6 pub fn from_elf(elf_data: &[u8]) -> (Self, usize, usize) {

7 let mut memory_set = Self::new_bare();

8 // map trampoline

9 memory_set.map_trampoline();

10 // map program headers of elf, with U flag

11 let elf = xmas_elf::ElfFile::new(elf_data).unwrap();

12 let elf_header = elf.header;

13 let magic = elf_header.pt1.magic;

14 assert_eq!(magic, [0x7f, 0x45, 0x4c, 0x46], "invalid elf!");

15 let ph_count = elf_header.pt2.ph_count();

16 let mut max_end_vpn = VirtPageNum(0);

17 for i in 0..ph_count {

18 let ph = elf.program_header(i).unwrap();

19 if ph.get_type().unwrap() == xmas_elf::program::Type::Load {

20 let start_va: VirtAddr = (ph.virtual_addr() as usize).into();

21 let end_va: VirtAddr = ((ph.virtual_addr() + ph.mem_size()) as usize).into();

22 let mut map_perm = MapPermission::U;

23 let ph_flags = ph.flags();

24 if ph_flags.is_read() { map_perm |= MapPermission::R; }

25 if ph_flags.is_write() { map_perm |= MapPermission::W; }

26 if ph_flags.is_execute() { map_perm |= MapPermission::X; }

27 let map_area = MapArea::new(

28 start_va,

29 end_va,

30 MapType::Framed,

31 map_perm,

32 );

33 max_end_vpn = map_area.vpn_range.get_end();

34 memory_set.push(

35 map_area,

36 Some(&elf.input[ph.offset() as usize..(ph.offset() + ph.file_size()) as usize])

37 );

38 }

39 }

40 // map user stack with U flags

41 let max_end_va: VirtAddr = max_end_vpn.into();

42 let mut user_stack_bottom: usize = max_end_va.into();

43 // guard page

44 user_stack_bottom += PAGE_SIZE;

45 let user_stack_top = user_stack_bottom + USER_STACK_SIZE;