-

研究任务 flat 和 nested NER tasks

-

已有方法

- 序列标注模型,以CRF为骨干

- 解析树,他们做了一个假设,即当一个mention与另一个mention重叠时,它们完全被另一个mention所包含

- mention hyper-graphs,用神经网络来学习超图表示

- 以分层的方式动态地堆叠平面NER层

- 通过对嵌套实体mention的头部驱动的短语结构进行建模和利用,形成锚点-区域网络(ARNs)架构

- 通过选择置信度最高的的实体跨度并将这些节点与信心加权的关系类型和核心关系联系起来,建立了一个跨度列举方法

- 基于BERT的模型,它首先将标记和/或实体合并成实体,然后给这些实体分配标签。

- 推理模型,从最外层的实体到内层的实体进行反复提取

- 将嵌套式NER视为一个序列-序列生成问题,其中输入序列是一个标记列表,目标序列是一个标签列表。

-

面临挑战 在嵌套NER任务中,无法很好的处理实体重叠的问题

-

创新思路 把NER任务转化成机器阅读理解任务

在本文中,将注释指南说明作为构建查询的参考。注释指南说明是由数据集建立者提供给数据集注释者的指南。它们是对标签类别的描述,这些描述尽可能地通用和精确,以便人类注释者可以在任何文本中对概念或提及的内容进行注释,而不会遇到歧义。

使用bert作为backbone,将query concat到一起

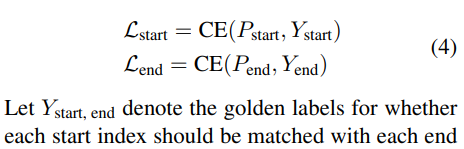

每个token上有两个二元分类器,一个是预测每个标记是否是起始索引,另一个是预测每个标记是否是结束索引。

鉴于BERT输出的表示矩阵E,模型首先预测每个标记是起始索引的概率,如下所示

跟start index的方法一模一样,用自己矩阵

由于实体之间存在重叠,使用匹配最近两个开始和结束的方法并不work,所以需要一个方法将start和end匹配起来

...

如何构建查询对最终结果有重大影响,实验表明最优的方法是Annotation guideline notes(注释准则说明)

在本文中,将NER任务重新表述为MRC问题回答任务。这种形式化有两个关键优势。 (1)能够处理重叠或嵌套的实体; (2)查询编码了关于要提取的实体类别的重要先验知识。 所提出的方法在 nested 和 flat NER数据集上都获得了SOTA结果

用阅读理解的方式做NER task,对于我这个没见过世面的小菜鸟来说确实是很novel的方法,然后效果也work,在那个时间点达到sota,但是之后的sota模型就直接碾压了它好几个点,再者不知道这个方法的效率如何,但是方法总体来说比较简单,idea新颖,总之个人觉得是篇好paper。