隐藏博客

+ + + ++

2022级推免基本告一段落,刚开始夏令营的时候其实还没有什么疫情,但是各大高校仍然基本选择了线上夏令营,因此造成了夏令营非常非常卷。我本人将比我们学校好的985基本全部报了一遍,总共报了20多个,最后入营的非常少。不幸中的万幸我以为根本不可能考虑我的中科院计算所在我没入营没联系老师的情况下仍然打电话叫我过去考试,最终拿到了offer。计算所offer确认的时间比较早,是9月10日,而经过夏令营入营惨痛的经历,我决定就不参加预推免了。

+ +南京大学今年养了一个大鱼塘,就拿我们专业来说,65人的小专业前三名都通过了南大的初审。当时接到了南大的邮件激动坏了,然而南大先搞了一波笔试。。。

+我实在是太菜了,有一半的题里面的名词都没听说过。。。所以就挂了,也没有然后了。

+面试后就结束了,几周后公布了优营名单,一共三四百入营的,优营给了不到二百个,承诺优营一定录取。

+北航最后拿到了候补,一共500个入营的,过了机试有400左右,优营给了110多个,候补给了100个。不过整个夏令营的阶段都没有北航的同学参与,而看去年的录取名单基本都是北航的。。不知道是什么原因

+入营有五百左右,给了三百的优营,要自己联系老师,8月底联系不到的认为放弃优营资格。

+入营只有200左右,大多数给了优营,但是是唯一一个没有后续的学校,没人说过优营有什么用接下来干什么。。。

+吐槽吐槽!!!!中山真的是太烦人了,就算过了也真心不想去。

+入营资格要一个一个电话确认,还没开始夏令营就开了三场会,一个面试环境检查会,一个笔试环境检查会,一个面试分组抽签会。更为奇葩的双机位要求:两个机位互相能看见,次机位看清电脑屏幕,主机位能看到脑袋+肩膀且能看到双手???你来教教我咋能主机位看到双手???我双手举起来编程吗???更为奇葩的机试监考,要共享屏幕到腾讯会议中。好家伙总共五百多人参加机试你找了五百多个研究生坐五百多个电脑前面开五百多个腾讯会议盯着我们???面试环境检查会都已经查看完了承诺书,正式面试还要再看一遍???程序无比繁琐,而且充斥着学校对学生的满满的不信任感!

五百多人给了300优营和100候补,还承诺优营一定录取,还说不搞预推免了。祝愿中山被鸽穿!

+中科院计算所本来是没有入营的(意料之中),看QQ群里面的报名号有六千多人报名,入营名单发了400多。但是实验室秘书有一天早上打电话过来希望我能去北京参加机试面试,难得的机会就过去了。在报名后和入营名单公布之前会在QQ群里面让选意向导师,实际上就是意向实验室,才会有实验室秘书联系你,所以要多关注群消息。

+面试结束当天晚上就打来了电话并发送了拟录取的邮件。一个月后在官网公布了拟录取的名单,入营的优营与没入营的优营(比如我)各占一半,总共给了200优营,承诺一定录取。其中查了一下,网数实验室面试38进12。

+理论上的防疫政策:低风险地区提前三天向酒店等报备,第一天和第三天两次核酸。

+实际:基本只看“青岛一码通”的绿码和7天内核酸阴性报告(有的地方可能要48小时核酸阴性报告)

+具体措施:

+| 日期 | +计划 | +备注 | +

|---|---|---|

| Day0 | +晚上到达青岛,做核酸、住酒店 | +可以去旁边的丽达生活超市买一些水和吃的 | +

| Day1上午 | +信号山公园、栈桥 | ++ |

| Day1中午 | +王姐烧烤午餐 | ++ |

| Day1下午 | +小青岛公园、鲁迅公园、小鱼山公园、青岛第一海水浴场、八大关风景区 | ++ |

| Day1晚上 | +台东步行街小吃晚餐、回酒店 | +可以去大商场买一点点吃的和水果等 | +

| Day2上午 | +小麦岛公园 | ++ |

| Day2中午 | +船歌鱼水饺午餐 | ++ |

| Day2下午 | +燕儿岛公园、奥帆中心、情人坝、五四广场、海天云上艺术中心 | +看天气,太热了就先去海天云上艺术中心 | +

| Day2晚上 | +探海岛海鲜自助(探鲜岛海鲜自助餐厅)晚餐、栈桥附近的夜景、回酒店 | ++ |

| Day3上午 | +去崂山风景区 | ++ |

| Day3中午 | +吃一些提前买的面包等,景区内应该也有一些吃的 | ++ |

| Day3下午 | +崂山风景区、回市区 | ++ |

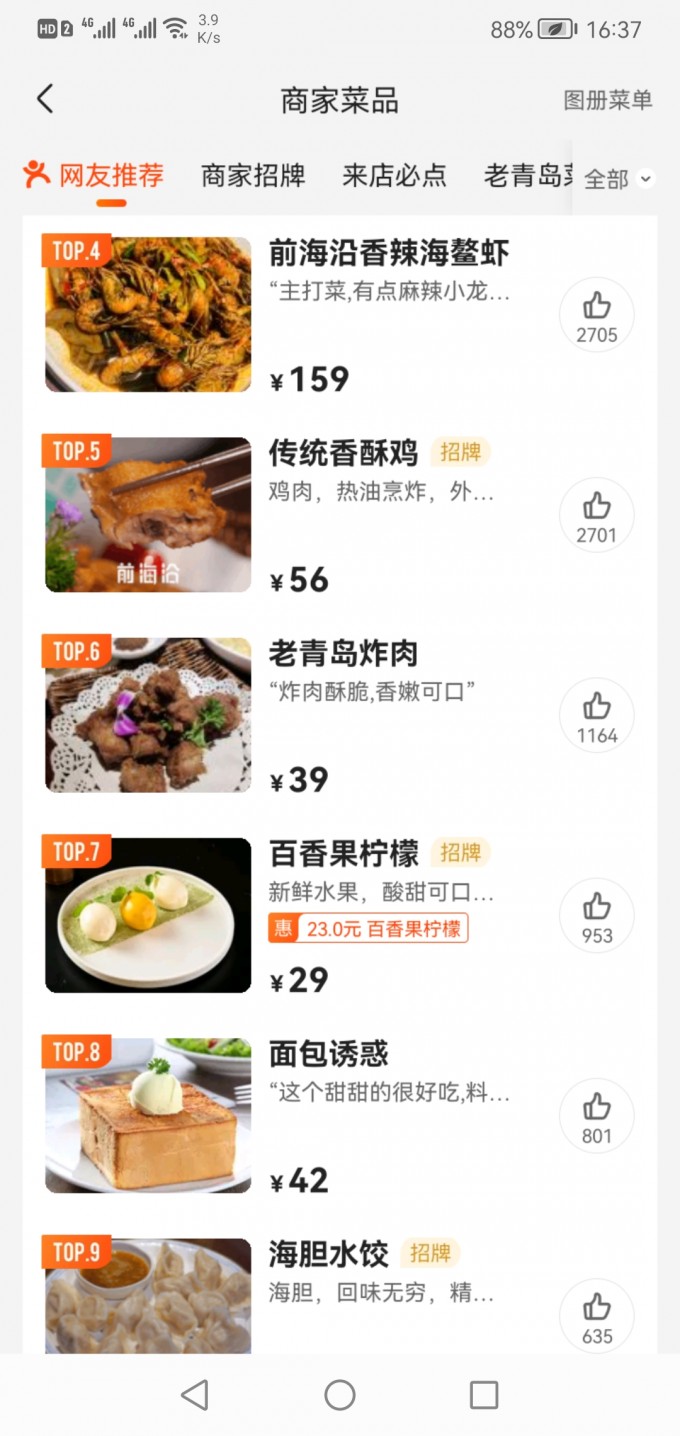

| Day3晚上 | +前海沿晚餐、回酒店 | ++ |

| Day4 | +返程 | ++ |

备注:

+交通方式:酒店——信号山公园,公交前往,37分钟,步行680米

+ + +预约:已经预约好 7月24日 6:00-20:30,包括收费5元的旋转观景楼

+时间:1个小时左右

+简介:信号山公园位于青岛市中心,因曾在山顶建有为船只引航的信号台而得名。信号山海拔98米,山顶三幢红顶蘑菇楼尤为显眼,其中较高的一幢是旋转观景楼,在这里你可以360度俯看青岛“红瓦绿树,碧海蓝天”的景色。进入景区大门,南坡上有踏浪观景台,就在连心桥下面一点,是拍摄南边德国古堡式建筑迎宾馆的好位置。连心桥上一把把红色爱心造型的锁挂在绿色栏杆上,情侣们可以在此买一把同心锁把彼此的山盟海誓锁在信号山上,据说手拉手走过连心桥可以得到祝福,单身的话自个儿的左手拉右手一样很好!再往前,可以看看五龙潭喷泉等景点,周围四条小龙围着中间一条大龙,与信号山又叫五龙山对应,因为山周边有龙江路、龙华路、龙口路、龙山路、伏龙路五条带“龙”字的路而得此别名。最后到达山顶的旋转观景楼,登上楼上观景台观景,一幢幢掩映在绿树中红瓦黄墙的德式建筑令人惊叹。往西南看,近处有绿色钟楼屋顶的基督教堂在一片红屋顶中非常出挑。

+

+

+交通方式:步行,共3公里左右

+ +预约:小鱼山公园开放时间08:00-17:00,网上找不到预约入口

+时间:2-3小时

+简介:小青岛故称为“琴岛”,是青岛湾内的一座小岛,青岛这个城市的名称就来源于它。小青岛与陆地之间有长长的海堤相接,岛上矗立着德国人建于1898年的灯塔,是青岛的标志之一。小青岛面积很小,岛上绿树成荫,岛的四周礁石环绕,海水清澈、蔚蓝,岛上常能见到来垂钓的游客。坐在礁石上吹吹海风,赤脚踩踩海水,看看四周青岛湾边林立的高楼和红顶的小洋房,仿佛置身于海上花园。每当夕阳西下时景色尤其美,阳光把整个海湾都镀成了金色。小青岛的南侧有一尊姿态优美的琴女雕像,雕像周围是花坛,种植着五颜六色的鲜花。岛的较高处有当年德国人建造的灯塔,整个岛的海拔也不高,才17米,走到灯塔脚下不需要爬多少路。灯塔通体洁白,由大理石构筑,是海上过往船只进出胶州湾的重要航标。每当夜幕降临,灯塔与岛上的灯光倒映在海面上,像一匹飘动的彩绸,形成青岛的一大胜景“琴屿飘灯”,在这里拍摄夜景很不错。鲁迅公园是青岛市内一处对外开放的临海公园,海边有大片的红褐色礁石,景色很特别,常有不少新人在此拍摄婚纱照。沿着海边步道慢慢走、听听海浪拍壁之声,或是走上岩石高处的亭子远眺大海,很是惬意。公园的东部紧邻青岛海底世界,再往东走是第一海水浴场,沿途风光很美。小鱼山公园是青岛佳风景眺望点之一,一是因为它位于市中心,是青岛离海近的一座山,地理位置;二是因为它的海拔仅60米,爬山不累,登到山顶能看到“红瓦绿树,碧海蓝天”具青岛代表性的景色。

+交通方式:步行,毗邻青岛第一海水浴场

+景区图:

+ +预约:无需预约,内部场馆单独售票,营业时间:9:00-17:00;换票时间:9:00-15:00

+时间:2小时

+简介:八大关是青岛市区南部相交错的十几条马路的总称,它们大多取名于我国知名关隘的名称。这里环境清幽,春季有碧桃盛开、夏季有紫薇盛放,秋季可见银杏红枫夹道,还坐落着许多各国风格的别墅,是摄影胜地。在这里,你可以进入欧洲古堡风格的“花石楼”参观、登上楼顶遥望大海,或者外观开国元帅住过的日式洋楼“元帅楼”、流传着唯美爱情故事的丹麦建筑“公主楼”等经典别墅,让你仿佛身处欧洲的某个角落。

+交通方式:地铁,24分钟,步行248m

+ +预约:无需预约

+时间:晚上

+简介:“朝观壁画夜赏灯,购物休闲在台东”,台东步行街是青岛有名的街区,街内有国内外知名的沃尔玛、万达广场、百信鞋业、利群集团、苏宁电器、三联家电、亚泰电器、新华书店、医保城等各类业态的企业245家。步行街两侧的21座楼6万余平方米的墙面为统一彩绘,精心绘制了色彩斑斓、造型生动的大型壁画,形成了独特的彩色画廊,这是大型的手工彩绘一条街。台东三路经过精心的景观设置,夜景迷人。这里还有男士、女士特色广场,营造出优美的购物和休闲环境,使市民在购物消费的同时,还享受着文化特色的盛宴。

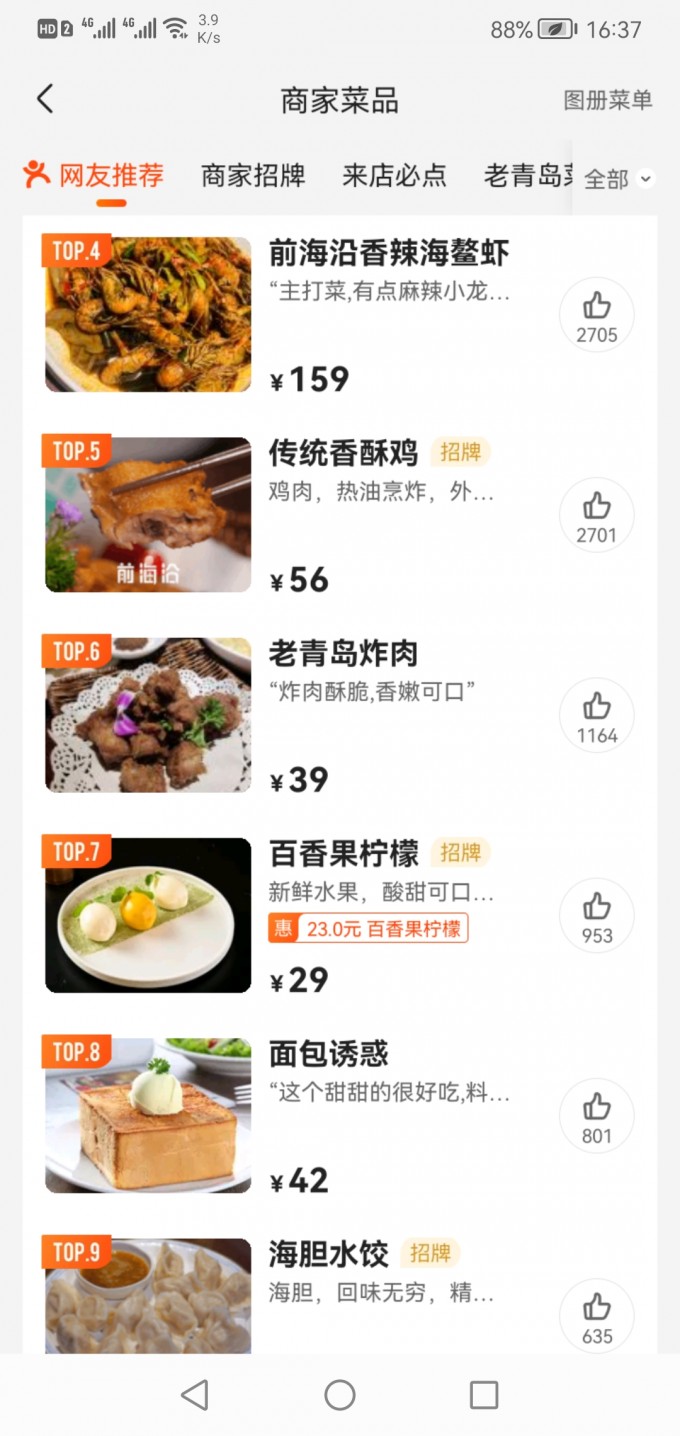

+美食推荐(有人排队多的肯定好吃):

+

+

+交通方式:地铁+公交(打车)(或公交),58分钟,步行1.2公里

+ +预约:无需预约

+时间:1-2小时

+简介:小麦岛公园位于崂山区麦岛路西50米,小麦岛属环形岛屿,有大片平坦宽广的绿化草地,远处就是湛蓝的海水,可在这里眺望到遥远的海岸线,一派海滨美景,非常适宜拍照。

+就在小麦岛公园的公交站旁边,逛后吃午餐。

+重点菜:鲅鱼、墨鱼、三鲜、虾仁水饺,海菜凉粉

+

+

+交通方式:公交34分钟,步行883米

+ +预约:无需预约

+时间:1-3小时

+简介:燕儿岛山公园位于山东省青岛市南部,处在浮山湾东端,是一个突出海中的岬角。园内环境优美,集生态、景观、文化、健身、休闲等为一体,是市民休闲锻炼、观光游玩的好地方。公园里的海滨栈道是一大亮点,木栈道与阶梯相连,一边是大海,一边是峭壁,峭壁底下鲜花盛开,在这里拍照仿佛置身于美丽的垦丁,有着独特的韵味。登上阶梯高处的平台放眼望去,可以将整个大海纳入眼帘,景色十分迷人。

+交通方式:步行,直线距离2公里左右

+ +预约:无需预约,奥帆中心其他景点待确定

+时间:2-3小时

+简介:青岛奥帆中心景区位于青岛市浮山湾畔,与青岛市标志性景点——五四广场近海相望,总占地面积约45公顷,是2008年北京第29届奥运会奥帆赛和第13届残奥会帆船比赛举办场地,奥帆中心景区依山面海,景色宜人,是全国唯一“国家滨海旅游休闲示范区”。青岛被誉为“帆船之都”,作为最能体现青岛城市特色和展示城市形象的景区,奥帆中心景区内不仅有飞帆渺渺的优雅,有青岛十大旧景代表燕岛秋潮,有青岛新时代景观鸥翔彩虹,更有众多惊险刺激的娱乐体验,是游客来青必看的景点。

+交通方式:公交或地铁,20分钟

+ +预约:已经预约好 7月25日 9:00-20:00,80F+81F联票

+时间:没查到。。。

+简介:海天中心城市观光厅是山东省超高层垂直建筑之上的高空观光平台。在这里,向西可揽胜八大关老城区红瓦绿树,向东承接新城区璀璨繁华,360°俯瞰壮美海景、山景、城景,全方位感受身处"天空之城"的独特体验。其内部设置的透明观景区、沉浸式体验区、多媒体展示区与空中水吧等多个功能空间,将内部游览体验与外部自然景观融为一体。站在369米之上的城市观光厅,可以看尽因海而生、向海而兴的魅力青岛在时间长河中的风貌变迁与发展动线。随着观光者的漫步,不同姿态的青岛都将尽收眼底。

+回青岛站附近吃晚餐,美团可以订座,顺便可以游览栈桥附近的夜景。

+

+

+交通方式:地铁接公交

+预约:已经预约好 7月26日 6:00-12:00太清,12:01-17:30 华严和仰口

+时间:一天

+路线:大河东检票——第三站下车游览太清宫、太清索道——索道往返——走到垭口乘坐公交618路前往华严(或仰口)——景区游览车到仰口(或华严)——原路返回大河东(或者直接从仰口出去)

+这个位置暂定,美团可以排队

+ +重点菜:蒜蓉粉丝虾、手锤茄子卷饼

+

+

+数学在机器学习领域的应用一:线性代数

+ +总是觉得自己数学有一点差,可能是因为上大学学习的时候题目做的比较少,我的脑子又不太灵光,因此一直不能很好的理解数学相关的一些公式、定理等,平时编程的时候尽量找简单的方法绕开复杂的数学公式。假期有时间了,试一下帝国理工的线性代数课程,注重记录,注重理解。这也是第一次看没有中文字幕的全英文课。加油!

+In this course on Linear Algebra we look at what linear algebra is and how it relates to vectors and matrices. Then we look through what vectors and matrices are and how to work with them, including the knotty problem of eigenvalues and eigenvectors, and how to use these to solve problems. Finally we look at how to use these to do fun things with datasets - like how to rotate images of faces and how to extract eigenvectors to look at how the Pagerank algorithm works.

+Since we’re aiming at data-driven applications, we’ll be implementing some of these ideas in code, not just on pencil and paper. Towards the end of the course, you’ll write code blocks and encounter Jupyter notebooks in Python, but don’t worry, these will be quite short, focussed on the concepts, and will guide you through if you’ve not coded before.

+At the end of this course you will have an intuitive understanding of vectors and matrices that will help you bridge the gap into linear algebra problems, and how to apply these concepts to machine learning.

+Linear algebra is a mathematical system for manipulating vectors in the spaces described by vectors.

+Linear algebra is linear, because it just takes input values, and multiplies them by constants, everything is linear.

+Linear algebra is algebra, that is it’s a notation describing mathematical objects and a system of manipulating those notations.

+How vectors are transformed by matrices is the heart of linear algebra.

+ ,可以转换为

,可以转换为 ,然后进行求解。

,然后进行求解。在计算机科学中,向量被认为是描述一个物体的属性的集合。

+向量有两种操作:向量与向量之间的加法,以及向量与标量之间的乘法。

+向量与向量之间的加法满足结合律(associativity)。

+向量与标量之间的乘法,要将标量与向量中的每一个属性相乘

+如果不以坐标系的角度去观察向量,那么一个向量由两个属性构成:向量的方向和向量的模长

+向量的模长指的是向量各组成成分的平方和开根号

+向量的点乘指的是向量对应位置的数值相乘之和,满足交换律(commutative)

+同时满足向量的加法分配律(distributive over addition),即

向量与标量相乘满足结合律和交换律,即

向量模长与点乘之间的关系:向量自身的点乘与模长的平方相等,即

向量的余弦定理:

向量投影(projection):

+

向量投影是一个标量,但是,如果需要投影向量的方向,直接与被投影的单位向量相乘即可。

+两个不共线的向量可以确定一个坐标系(coordinate system)。要描述一个向量,首先要定义一个坐标系,决定坐标系的是基向量。

+基向量是

维的向量彼此之间不线性相关,也就是线性独立的

维的向量彼此之间不线性相关,也就是线性独立的 维向量。

维向量。 维的。

维的。虽然并不要求基向量正交,但是如果它们正交,会为解决数学问题带来很大的方便。

+如果二维的基向量互相垂直,转换坐标系只需将向量投影到转换后的基向量,计算数值即可。

+设原始坐标系

首先验证

然后将待转换的向量

从而得出

找到一个合适的坐标系,帮助我们解决数学问题,是非常重要的。

+矩阵与向量相乘,相当于将向量转换到不同的坐标系。

+矩阵的乘法满足结合律,但是不满足交换律.

+如

如

通过矩阵的转换实际上可以看作不同转换向量之间的和。

+如果我们对

单位矩阵(identity matrix)不对向量做任何变换

+设单位矩阵

根据逆矩阵的定义,

因此

通过初等行变换求解逆矩阵:

对于二维矩阵

二维行列式(determinant):

行列式为0的矩阵,维度不满足当前矩阵的维度,因此在矩阵操作前要首先检查行列式。

+矩阵的转置:

设

则

如

因此

设原始坐标系

如果将

反之,将原始坐标系中的向量转换到

如果基向量是正交的,可以使用投影来实现坐标系的转换:

+设原始坐标系

则将

正交的基向量会给我们解决问题带来很多的方便,需要一种方法将基向量转换为正交的基向量。

+设原始的

对特征向量的直观感受:在进行变换的时候方向仍然保持不变的向量。

+

求特征值,即

对角矩阵(diagonal matrix)会使矩阵的乘法变得更加容易,

因此可以通过特征值与特征向量的转换,将矩阵转化为对角矩阵,然后求矩阵的幂。

+设特征向量

矩阵

# GRADED FUNCTION

+import numpy as np

+

+# Our function will go through the matrix replacing each row in order turning it into echelon form.

+# If at any point it fails because it can't put a 1 in the leading diagonal,

+# we will return the value True, otherwise, we will return False.

+# There is no need to edit this function.

+def isSingular(A) :

+ B = np.array(A, dtype=np.float_) # Make B as a copy of A, since we're going to alter it's values.

+ try:

+ fixRowZero(B)

+ fixRowOne(B)

+ fixRowTwo(B)

+ fixRowThree(B)

+ except MatrixIsSingular:

+ return True

+ return False

+

+# This next line defines our error flag. For when things go wrong if the matrix is singular.

+# There is no need to edit this line.

+class MatrixIsSingular(Exception): pass

+

+# For Row Zero, all we require is the first element is equal to 1.

+# We'll divide the row by the value of A[0, 0].

+# This will get us in trouble though if A[0, 0] equals 0, so first we'll test for that,

+# and if this is true, we'll add one of the lower rows to the first one before the division.

+# We'll repeat the test going down each lower row until we can do the division.

+# There is no need to edit this function.

+def fixRowZero(A) :

+ if A[0,0] == 0 :

+ A[0] = A[0] + A[1]

+ if A[0,0] == 0 :

+ A[0] = A[0] + A[2]

+ if A[0,0] == 0 :

+ A[0] = A[0] + A[3]

+ if A[0,0] == 0 :

+ raise MatrixIsSingular()

+ A[0] = A[0] / A[0,0]

+ return A

+

+# First we'll set the sub-diagonal elements to zero, i.e. A[1,0].

+# Next we want the diagonal element to be equal to one.

+# We'll divide the row by the value of A[1, 1].

+# Again, we need to test if this is zero.

+# If so, we'll add a lower row and repeat setting the sub-diagonal elements to zero.

+# There is no need to edit this function.

+def fixRowOne(A) :

+ A[1] = A[1] - A[1,0] * A[0]

+ if A[1,1] == 0 :

+ A[1] = A[1] + A[2]

+ A[1] = A[1] - A[1,0] * A[0]

+ if A[1,1] == 0 :

+ A[1] = A[1] + A[3]

+ A[1] = A[1] - A[1,0] * A[0]

+ if A[1,1] == 0 :

+ raise MatrixIsSingular()

+ A[1] = A[1] / A[1,1]

+ return A

+

+# This is the first function that you should complete.

+# Follow the instructions inside the function at each comment.

+def fixRowTwo(A) :

+ # Insert code below to set the sub-diagonal elements of row two to zero (there are two of them).

+ A[2] = A[2] - A[2,0] * A[0]

+ A[2] = A[2] - A[2,1] * A[1]

+ # Next we'll test that the diagonal element is not zero.

+ if A[2,2] == 0 :

+ # Insert code below that adds a lower row to row 2.

+ A[2] = A[2] + A[3]

+ # Now repeat your code which sets the sub-diagonal elements to zero.

+ A[2] = A[2] - A[2,0] * A[0]

+ A[2] = A[2] - A[2,1] * A[1]

+ if A[2,2] == 0 :

+ raise MatrixIsSingular()

+ # Finally set the diagonal element to one by dividing the whole row by that element.

+ A[2] = A[2] / A[2,2]

+ return A

+

+# You should also complete this function

+# Follow the instructions inside the function at each comment.

+def fixRowThree(A) :

+ # Insert code below to set the sub-diagonal elements of row three to zero.

+ A[3] = A[3] - A[3,0] * A[0]

+ A[3] = A[3] - A[3,1] * A[1]

+ A[3] = A[3] - A[3,2] * A[2]

+ # Complete the if statement to test if the diagonal element is zero.

+ if A[3,3] == 0:

+ raise MatrixIsSingular()

+ # Transform the row to set the diagonal element to one.

+ A[3] = A[3] / A[3,3]

+ return AA = np.array([

+ [2, 0, 0, 0],

+ [0, 3, 0, 0],

+ [0, 0, 4, 4],

+ [0, 0, 5, 5]

+ ], dtype=np.float_)

+isSingular(A)

+A = np.array([

+ [0, 7, -5, 3],

+ [2, 8, 0, 4],

+ [3, 12, 0, 5],

+ [1, 3, 1, 3]

+ ], dtype=np.float_)

+isSingular(A)

+fixRowZero(A)

+fixRowOne(A)

+fixRowTwo(A)

+fixRowThree(A)# GRADED FUNCTION

+import numpy as np

+import numpy.linalg as la

+

+verySmallNumber = 1e-14 # That's 1×10⁻¹⁴ = 0.00000000000001

+

+# Our first function will perform the Gram-Schmidt procedure for 4 basis vectors.

+# We'll take this list of vectors as the columns of a matrix, A.

+# We'll then go through the vectors one at a time and set them to be orthogonal

+# to all the vectors that came before it. Before normalising.

+# Follow the instructions inside the function at each comment.

+# You will be told where to add code to complete the function.

+def gsBasis4(A) :

+ B = np.array(A, dtype=np.float_) # Make B as a copy of A, since we're going to alter it's values.

+ # The zeroth column is easy, since it has no other vectors to make it normal to.

+ # All that needs to be done is to normalise it. I.e. divide by its modulus, or norm.

+ B[:, 0] = B[:, 0] / la.norm(B[:, 0])

+ # For the first column, we need to subtract any overlap with our new zeroth vector.

+ B[:, 1] = B[:, 1] - B[:, 1] @ B[:, 0] * B[:, 0]

+ # If there's anything left after that subtraction, then B[:, 1] is linearly independant of B[:, 0]

+ # If this is the case, we can normalise it. Otherwise we'll set that vector to zero.

+ if la.norm(B[:, 1]) > verySmallNumber :

+ B[:, 1] = B[:, 1] / la.norm(B[:, 1])

+ else :

+ B[:, 1] = np.zeros_like(B[:, 1])

+ # Now we need to repeat the process for column 2.

+ # Insert two lines of code, the first to subtract the overlap with the zeroth vector,

+ # and the second to subtract the overlap with the first.

+ B[:, 2] = B[:, 2] - B[:, 2] @ B[:, 0] * B[:, 0]

+ B[:, 2] = B[:, 2] - B[:, 2] @ B[:, 1] * B[:, 1]

+ # Again we'll need to normalise our new vector.

+ # Copy and adapt the normalisation fragment from above to column 2.

+ if la.norm(B[:, 2]) > verySmallNumber :

+ B[:, 2] = B[:, 2] / la.norm(B[:, 2])

+ else :

+ B[:, 2] = np.zeros_like(B[:, 2])

+ # Finally, column three:

+ # Insert code to subtract the overlap with the first three vectors.

+ B[:, 3] = B[:, 3] - B[:, 3] @ B[:, 0] * B[:, 0]

+ B[:, 3] = B[:, 3] - B[:, 3] @ B[:, 1] * B[:, 1]

+ B[:, 3] = B[:, 3] - B[:, 3] @ B[:, 2] * B[:, 2]

+ # Now normalise if possible

+ if la.norm(B[:, 3]) > verySmallNumber :

+ B[:, 3] = B[:, 3] / la.norm(B[:, 3])

+ else :

+ B[:, 3] = np.zeros_like(B[:, 3])

+ # Finally, we return the result:

+ return B

+

+# The second part of this exercise will generalise the procedure.

+# Previously, we could only have four vectors, and there was a lot of repeating in the code.

+# We'll use a for-loop here to iterate the process for each vector.

+def gsBasis(A) :

+ B = np.array(A, dtype=np.float_) # Make B as a copy of A, since we're going to alter it's values.

+ # Loop over all vectors, starting with zero, label them with i

+ for i in range(B.shape[1]) :

+ # Inside that loop, loop over all previous vectors, j, to subtract.

+ for j in range(i) :

+ # Complete the code to subtract the overlap with previous vectors.

+ # you'll need the current vector B[:, i] and a previous vector B[:, j]

+ B[:, i] = B[:, i] - B[:, i] @ B[:, j] * B[:, j]

+ # Next insert code to do the normalisation test for B[:, i]

+ if la.norm(B[:, i]) > verySmallNumber :

+ B[:, i] = B[:, i] / la.norm(B[:, i])

+ else :

+ B[:, i] = np.zeros_like(B[:, i])

+ # Finally, we return the result:

+ return B

+

+# This function uses the Gram-schmidt process to calculate the dimension

+# spanned by a list of vectors.

+# Since each vector is normalised to one, or is zero,

+# the sum of all the norms will be the dimension.

+def dimensions(A) :

+ return np.sum(la.norm(gsBasis(A), axis=0))V = np.array([[1,0,2,6],

+ [0,1,8,2],

+ [2,8,3,1],

+ [1,-6,2,3]], dtype=np.float_)

+gsBasis4(V)

+# Once you've done Gram-Schmidt once,

+# doing it again should give you the same result. Test this:

+U = gsBasis4(V)

+gsBasis4(U)

+# Try the general function too.

+gsBasis(V)

+# See what happens for non-square matrices

+A = np.array([[3,2,3],

+ [2,5,-1],

+ [2,4,8],

+ [12,2,1]], dtype=np.float_)

+gsBasis(A)

+dimensions(A)

+B = np.array([[6,2,1,7,5],

+ [2,8,5,-4,1],

+ [1,-6,3,2,8]], dtype=np.float_)

+gsBasis(B)

+dimensions(B)

+# Now let's see what happens when we have one vector that is a linear combination of the others.

+C = np.array([[1,0,2],

+ [0,1,-3],

+ [1,0,2]], dtype=np.float_)

+gsBasis(C)

+dimensions(C)# PACKAGE

+# Run this cell first once to load the dependancies.

+import numpy as np

+from numpy.linalg import norm, inv

+from numpy import transpose

+from readonly.bearNecessities import *

+# GRADED FUNCTION

+# You should edit this cell.

+

+# In this function, you will return the transformation matrix T,

+# having built it out of an orthonormal basis set E that you create from Bear's Basis

+# and a transformation matrix in the mirror's coordinates TE.

+def build_reflection_matrix(bearBasis) : # The parameter bearBasis is a 2×2 matrix that is passed to the function.

+ # Use the gsBasis function on bearBasis to get the mirror's orthonormal basis.

+ E = gsBasis(bearBasis)

+ # Write a matrix in component form that performs the mirror's reflection in the mirror's basis.

+ # Recall, the mirror operates by negating the last component of a vector.

+ # Replace a,b,c,d with appropriate values

+ TE = np.array([[1, 0],

+ [0, -1]])

+ # Combine the matrices E and TE to produce your transformation matrix.

+ T = E @ TE @ inv(E)

+ # Finally, we return the result. There is no need to change this line.

+ return T

+# First load Pyplot, a graph plotting library.

+%matplotlib inline

+import matplotlib.pyplot as plt

+

+# This is the matrix of Bear's basis vectors.

+# (When you've done the exercise once, see what happns when you change Bear's basis.)

+bearBasis = np.array(

+ [[1, -1],

+ [1.5, 2]])

+# This line uses your code to build a transformation matrix for us to use.

+T = build_reflection_matrix(bearBasis)

+

+# Bear is drawn as a set of polygons, the vertices of which are placed as a matrix list of column vectors.

+# We have three of these non-square matrix lists: bear_white_fur, bear_black_fur, and bear_face.

+# We'll make new lists of vertices by applying the T matrix you've calculated.

+reflected_bear_white_fur = T @ bear_white_fur

+reflected_bear_black_fur = T @ bear_black_fur

+reflected_bear_face = T @ bear_face

+

+# This next line runs a code to set up the graphics environment.

+ax = draw_mirror(bearBasis)

+

+# We'll first plot Bear, his white fur, his black fur, and his face.

+ax.fill(bear_white_fur[0], bear_white_fur[1], color=bear_white, zorder=1)

+ax.fill(bear_black_fur[0], bear_black_fur[1], color=bear_black, zorder=2)

+ax.plot(bear_face[0], bear_face[1], color=bear_white, zorder=3)

+

+# Next we'll plot Bear's reflection.

+ax.fill(reflected_bear_white_fur[0], reflected_bear_white_fur[1], color=bear_white, zorder=1)

+ax.fill(reflected_bear_black_fur[0], reflected_bear_black_fur[1], color=bear_black, zorder=2)

+ax.plot(reflected_bear_face[0], reflected_bear_face[1], color=bear_white, zorder=3);

+# PACKAGE

+# Here are the imports again, just in case you need them.

+# There is no need to edit or submit this cell.

+import numpy as np

+import numpy.linalg as la

+from readonly.PageRankFunctions import *

+np.set_printoptions(suppress=True)

+# GRADED FUNCTION

+# Complete this function to provide the PageRank for an arbitrarily sized internet.

+# I.e. the principal eigenvector of the damped system, using the power iteration method.

+# (Normalisation doesn't matter here)

+# The functions inputs are the linkMatrix, and d the damping parameter - as defined in this worksheet.

+# (The damping parameter, d, will be set by the function - no need to set this yourself.)

+def pageRank(linkMatrix, d) :

+ n = linkMatrix.shape[0]

+ M = d * linkMatrix + (1-d)/n * np.ones([n, n])

+ r = 100 * np.ones(n) / n

+ lastR = r

+ r = M @ r

+ i = 0

+ while la.norm(lastR - r) > 0.01 :

+ lastR = r

+ r = M @ r

+ i += 1

+ return r# Use the following function to generate internets of different sizes.

+generate_internet(5)

+# Test your PageRank method against the built in "eig" method.

+# You should see yours is a lot faster for large internets

+L = generate_internet(10)

+pageRank(L, 1)

+# Do note, this is calculating the eigenvalues of the link matrix, L,

+# without any damping. It may give different results that your pageRank function.

+# If you wish, you could modify this cell to include damping.

+# (There is no credit for this though)

+eVals, eVecs = la.eig(L) # Gets the eigenvalues and vectors

+order = np.absolute(eVals).argsort()[::-1] # Orders them by their eigenvalues

+eVals = eVals[order]

+eVecs = eVecs[:,order]

+

+r = eVecs[:, 0]

+100 * np.real(r / np.sum(r))

+# You may wish to view the PageRank graphically.

+# This code will draw a bar chart, for each (numbered) website on the generated internet,

+# The height of each bar will be the score in the PageRank.

+# Run this code to see the PageRank for each internet you generate.

+# Hopefully you should see what you might expect

+# - there are a few clusters of important websites, but most on the internet are rubbish!

+%pylab notebook

+r = pageRank(generate_internet(100), 0.9)

+plt.bar(arange(r.shape[0]), r);Formula Sheet: Sheet summarising all the formulae covered in this course.

+ + +旅行物品清单

+ +机器学习-监督学习:回归和分类

+ +吴恩达的机器学习课程终于更新了!!!想当初应该是大二的时候,看了吴恩达的课程,对机器学习有了初步的了解。当时听的不是很明白,英语看不太懂,一些给了充分提示的代码也写不太好,也就是入了一个门而已。这次有一些时间,正好捡一捡机器学习的基础知识,推一推那些一直在调包的数学公式。注重记录!

+In the first course of the Machine Learning Specialization, you will:

+• Build machine learning models in Python using popular machine learning libraries NumPy and scikit-learn.

+• Build and train supervised machine learning models for prediction and binary classification tasks, including linear regression and logistic regression

The Machine Learning Specialization is a foundational online program created in collaboration between DeepLearning.AI and Stanford Online. In this beginner-friendly program, you will learn the fundamentals of machine learning and how to use these techniques to build real-world AI applications.

+This Specialization is taught by Andrew Ng, an AI visionary who has led critical research at Stanford University and groundbreaking work at Google Brain, Baidu, and Landing.AI to advance the AI field.

+This 3-course Specialization is an updated and expanded version of Andrew’s pioneering Machine Learning course, rated 4.9 out of 5 and taken by over 4.8 million learners since it launched in 2012.

+It provides a broad introduction to modern machine learning, including supervised learning (multiple linear regression, logistic regression, neural networks, and decision trees), unsupervised learning (clustering, dimensionality reduction, recommender systems), and some of the best practices used in Silicon Valley for artificial intelligence and machine learning innovation (evaluating and tuning models, taking a data-centric approach to improving performance, and more.)

+By the end of this Specialization, you will have mastered key concepts and gained the practical know-how to quickly and powerfully apply machine learning to challenging real-world problems. If you’re looking to break into AI or build a career in machine learning, the new Machine Learning Specialization is the best place to start.

+监督学习是学习从输入

监督学习的基本类型有两种:回归和分类

+回归任务是在大量的数值空间中,对某一个具体数值进行预测

+分类任务是在给定的数值空间中(如0和1),对某一个具体数据进行预测

+

线性回归的机器学习模型可以表示为:

度量预测值与实际目标值之间的差异

+线性回归中使用的平方损失函数:

目标就是要找出最合适的

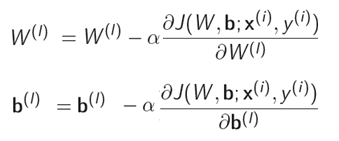

使用梯度下降算法:

+

梯度下降在更新的时候需要同时更新

具体计算:

+学习率的选择:

+如果学习率过小,梯度下降算法运行会比较慢

+如果学习率过大,梯度下降算法可能运行过头,最终导致算法不能收敛

+如果使用固定的学习率,梯度下降算法运行到局部最小值后不会再变化。因为到达局部最小值的附近后,梯度下降的每一步会变得更小,更新的值也会逐渐变小。

+通过损失值随着迭代次数的变化可以看出一些错误:

+将学习率调整足够小,损失值在每一次迭代的过程中都会减小

+

令

可以通过Numpy的向量化进行计算

+当具有不同的值范围的不同特征时,可能会导致梯度下降算法运行较慢

+需要对不同的特征重新缩放到相同或相似的范围

+均值归一化:

Z-score归一化:

sigmoid函数:

逻辑回归:

不同的决策边界:

+逻辑回归损失函数:

+简化写法:

欠拟合:函数对于训练集的拟合效果不好——高偏差(high bias)

+过拟合:函数对于训练集的拟合效果好,对于测试集的效果不好——高方差(high variance)

+避免过拟合的方法:

+通过将损失函数加上特别大的常数与某一参数的乘积,使得这个参数在优化的过程中变得非常小

+例如回归问题:

+由于不知道哪些特征是比较重要的,哪些特征不重要,因此加上参数平方求和的正则项,让优化算法自行选择。

+对于线性回归来说:

+进一步推导:

+因此正则项的加入实际上相当于将参数略微减小

+记于2022年7月28日,已于2022年9月24日正式分手,公开于2023年11月19日

+ +青岛的五天旅行结束了,251天后的初次见面,美好的时光总是短暂。

+回家后心里一直不太舒服,一直在胡思乱想,想着想着有时还偷偷抹抹眼泪。父母也是真的了解我,虽然并没有表现出什么,一直在不断追问我怎么了。当然就算有明确的原因也不会说,对爸妈只能是报喜不报忧,何况我现在也不知道我为什么这样。

+可能是不舍得吧,分开了251天,再次见面的时间只有短短的五天,下一次见面还不知道什么时候。

+可能是由于毕业季的几乎分手吧,可能现在自己的信心没有那么足了。

+可能是对自己未来的迷茫吧,本科取得了不错的成绩,研究生一切从头开始,不知该从何做起。

+这一段时间,对我影响最大的就是那一次的几乎分手。女孩子真的需要陪伴,异地太久了,感情是真的会变淡的。而且之前并没有很明确的聊过未来的规划。可能随口的一句“杭州南京”,就成为了一道跨不过去的坎。

+我出生在东北的一个小城,从小的梦想就是要走出去,给我自己,甚至给我的下一代创造一个更好的生活环境。高二那年清华暑校遇到全国的优秀学生,发现不同地区顶尖学生之间的差异居然也有如此之大,更加坚定了我走出去的决心。我也很庆幸在高考失利的情况下能选到一个好专业,在房价居高不下的大环境下,至少目前来看毕业后的薪资还是非常有竞争力的。

+我很开心可以遇到我的女朋友,我们在一无所有的情况下愿意去尝试。我也从此有了另外的一个前进动力,从高考失利和大一的挫折中走了出来,拿下了年级排名和无数的竞赛奖项、荣誉称号,成功保研。保研的时候也没有选择华师大,想着自己应该获得更好的学历,以后赚更多的钱,才能和她一起有更好的生活。我按照我的道路一步一步在走。

+然而由于我早去北京的提前异地,我们之间的沟通就少了许多。地理上的距离造成了心的距离,找到了一个很好的教师编职位后,她便产生了分手的想法。整个过程我甚至都是毫不知情的状态。虽然靠着一条时间轴挽回,但是我需要对自己做一个深刻的反思。我自认为我的爱没有变,但是异地半年多,确实很难将爱表达出来,同时也忽略了她的感受,我们之间的交流变得更少,最终导致了单方面无吵架的分手。

+能有一个爱人时刻陪伴在身边,确实是一件非常美好的事情。才分开两天,五天的回忆一波一波涌上心头,真的很难受。想起她忘记带伞的时候,只能躲在小店内等待雨停,却无法等到一个送伞的我。异地恋真的难熬。然而这还不到一年的时间。最少需要三年才能奔现,要是找一份更高薪的工作,甚至需要五年的时间,我才能在合肥站稳脚跟,真正地和她在一起。“所以你就选定我了是嘛”“是的”“为什么呢”“。。。”是啊,为什么呢,我回答不上来。后来我也认真考虑了很久,我是一个纯理性思维的人,这一次我选择听从我的心。我相信我三年前的选择,不管是现在,三年后,三十年后,我还会作出同样的选择。

+我是一个很坚定的人,我作出了选择,就会坚定的走下去。这几年我会尽全力维护这一段感情,改正掉我之前的错误,尽量多见面,尽量提升自己以后拿到更好的薪资,尽量多关心,多询问她的感受。三年前我还是一个懵懂无知的学生,我不知道三年后,甚至五年后我会成为什么样的人,但是我的爱是永远不变的。

+如果她熬不住了,我会坦然接受。因为我知道,我才是那个最对不起她的人。长三角省会城市工作稳定,我又何德何能拴住她数年的时间,忍受着屏幕那边可有可无的关心,忍受着几个月甚至半年才有的一次短短几天的见面。

+我真的希望最终我们可以幸福地走到一起。

+为你,千千万万遍。

+ + +数学在机器学习领域的应用二:多元微积分

+ +This course offers a brief introduction to the multivariate calculus required to build many common machine learning techniques. We start at the very beginning with a refresher on the “rise over run” formulation of a slope, before converting this to the formal definition of the gradient of a function. We then start to build up a set of tools for making calculus easier and faster. Next, we learn how to calculate vectors that point up hill on multidimensional surfaces and even put this into action using an interactive game. We take a look at how we can use calculus to build approximations to functions, as well as helping us to quantify how accurate we should expect those approximations to be. We also spend some time talking about where calculus comes up in the training of neural networks, before finally showing you how it is applied in linear regression models. This course is intended to offer an intuitive understanding of calculus, as well as the language necessary to look concepts up yourselves when you get stuck. Hopefully, without going into too much detail, you’ll still come away with the confidence to dive into some more focused machine learning courses in future.

+函数是从输入到输出的映射,选择函数来建模世界的过程是伟大天才的科学目的,微积分只是对这些函数如何相对于它们的输入变量如何变化的研究。

+对于线性函数而言,斜率(梯度、gradient)=‘rise over run’,也就是任意取两点,

对于梯度一直在变化的函数来说,设函数为

即,

导数的求和法则:

幂函数求导法则:令

不连续(discontinuity)的函数,例如

例如

三角函数:

导数乘积法则:令

求导的链式法则:若

偏导数求导法则:

偏导数仍然遵循导数的求导法则

+设函数

这样给予一组

设函数

对雅可比行列式再求一次偏导数,构成的二阶偏导数矩阵为海森矩阵

+设函数

雅可比行列式求得的值为0的情况下,首先求海森矩阵的行列式,如果行列式为正数,说明目前的点是一个极值点;然后看海森矩阵的第一个数字,如果第一个数字是正数,说明目前在极小值点,否则在极大值点;如果海森矩阵的行列式为负,说明目前的点是一个鞍点。

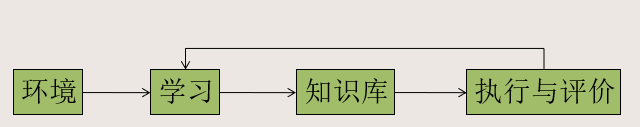

+最简单的神经网络:

输入可能不仅仅是一个,设输入的神经元有

输出可能也不仅仅是一个,设输出的神经元有

可以简化表示为:

如果神经网络不止一层,则可以表示为:

神经网络(分类任务)的损失函数为

泰勒展开式是对一个复杂函数的简化估计函数

+

泰勒形式:

+

+

迭代求解方程的近似根:

+这种方法会存在一些问题,如果选取的点比较靠近函数的拐点,会得不到正确的结果,或者得到的结果并不是与选取的点最接近的。

+如何使用梯度找到多元函数的最大值或者最小值

+函数的梯度:

如果希望找到最大值,将梯度与它的单位向量相乘,则

梯度下降:

计算函数在某些约束下的最大值或者最小值

+

即:

设函数

计算平方误差:

求解使得误差最小:

则可以解得:

+Formula Sheet: Sheet summarising all the formulae covered in this course.

+ + +机器学习-高级学习算法

+ +In the second course of the Machine Learning Specialization, you will:

+• Build and train a neural network with TensorFlow to perform multi-class classification

+• Apply best practices for machine learning development so that your models generalize to data and tasks in the real world

+• Build and use decision trees and tree ensemble methods, including random forests and boosted trees

The Machine Learning Specialization is a foundational online program created in collaboration between DeepLearning.AI and Stanford Online. In this beginner-friendly program, you will learn the fundamentals of machine learning and how to use these techniques to build real-world AI applications.

+This Specialization is taught by Andrew Ng, an AI visionary who has led critical research at Stanford University and groundbreaking work at Google Brain, Baidu, and Landing.AI to advance the AI field.

+This 3-course Specialization is an updated and expanded version of Andrew’s pioneering Machine Learning course, rated 4.9 out of 5 and taken by over 4.8 million learners since it launched in 2012.

+It provides a broad introduction to modern machine learning, including supervised learning (multiple linear regression, logistic regression, neural networks, and decision trees), unsupervised learning (clustering, dimensionality reduction, recommender systems), and some of the best practices used in Silicon Valley for artificial intelligence and machine learning innovation (evaluating and tuning models, taking a data-centric approach to improving performance, and more.)

+By the end of this Specialization, you will have mastered key theoretical concepts and gained the practical know-how to quickly and powerfully apply machine learning to challenging real-world problems. If you’re looking to break into AI or build a career in machine learning, the new Machine Learning Specialization is the best place to start.

+生物神经元:通过树突接收到来自不同地方的输入,然后通过轴突将神经冲动传递出去。

+但是目前对于人脑的运作方式了解的还不是很透彻。

+model = Sequential(

+ [

+ tf.keras.Input(shape=(400,)), #specify input size

+ tf.keras.layers.Dense(25, activation='sigmoid'),

+ tf.keras.layers.Dense(15, activation='sigmoid'),

+ tf.keras.layers.Dense(1, activation='sigmoid')

+ ], name = "my_model"

+)model.compile(

+ loss=tf.keras.losses.BinaryCrossentropy(),

+ optimizer=tf.keras.optimizers.Adam(0.001),

+)

+

+model.fit(

+ X,y,

+ epochs=20

+)prediction = model.predict(X[0].reshape(1,400)) # a zero

+print(f" predicting a zero: {prediction}")

+prediction = model.predict(X[500].reshape(1,400)) # a one

+print(f" predicting a one: {prediction}")def my_dense_v(A_in, W, b, g):

+ """

+ Computes dense layer

+ Args:

+ A_in (ndarray (m,n)) : Data, m examples, n features each

+ W (ndarray (n,j)) : Weight matrix, n features per unit, j units

+ b (ndarray (1,j)) : bias vector, j units

+ g activation function (e.g. sigmoid, relu..)

+ Returns

+ A_out (ndarray (m,j)) : m examples, j units

+ """

+ z = np.matmul(A_in,W)+b

+ A_out = g(z)

+ return(A_out)def my_sequential_v(X, W1, b1, W2, b2, W3, b3):

+ A1 = my_dense_v(X, W1, b1, sigmoid)

+ A2 = my_dense_v(A1, W2, b2, sigmoid)

+ A3 = my_dense_v(A2, W3, b3, sigmoid)

+ return(A3)Prediction = my_sequential_v(X, W1_tmp, b1_tmp, W2_tmp, b2_tmp, W3_tmp, b3_tmp )

+Prediction.shape人工智能(AI)可以分为两种,ANI和AGI:

+ANI指在某一特定领域应用的人工智能,目前已经取得了很好的效果;

+AGI指通用人工智能,人工智能可以做任何人类可以做到的事情。

+鉴于对人脑的了解还不够,如果通过模拟人脑的方式达到通用人工智能比较困难。

+不过目前有一些进展,让通用人工智能看到了一点点希望。

+如果不使用激活函数,那么不管多么复杂的神经网络都会退化成线性回归方法可以实现的效果。

+Sigmoid激活函数:

ReLU激活函数:

如何选择输出层的激活函数:

+隐藏层中大多数使用ReLU激活函数而非Sigmoid激活函数

+多类别分类是指输出不止两种情况的分类问题,如对手写数字进行分类,输出的类别会有10个

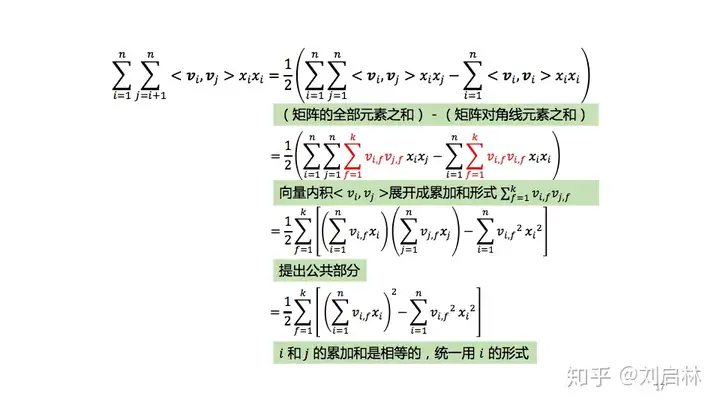

+可以使用Softmax回归算法:

+损失函数:

多标签分类:可以看成很多多类别分类问题,也可以使用一个神经网络预测所有的类别

+Adam优化方法:自动调节学习率

+如果梯度下降的方向一直是同一方向则增大学习率,让算法运行更快

+如果梯度下降的方向一直在波动,则减小学习率。

+如果发现训练好的模型在预测上存在很大的问题,可以从以下几个方面入手查找原因:

+ 、

、 、

、 等等——高偏差

等等——高偏差 ——高方差、高偏差

——高方差、高偏差训练时对训练集进行划分,可以划分为训练集和测试集,如果希望使用交叉验证的方式,可以划分为训练集、验证集和测试集。通过测试集的表型评估模型的效果。模型的选择上,可以从多项式的次数从低到高依次进行选择,找出测试集误差最小的模型。

+更大规模的神经网络的偏差往往更小

+如果恰当选择正则化参数,更大规模的神经网络的表现比小规模的神经网络表现更好

+欠拟合:函数对于训练集的拟合效果不好——高偏差(high bias)

+过拟合:函数对于训练集的拟合效果好,对于测试集的效果不好——高方差(high variance)

+避免过拟合的方法:

+正则项参数

导致模型的训练集拟合效果不好——高偏差(high bias)

导致模型的训练集拟合效果不好——高偏差(high bias) 导致模型对于训练集的拟合效果好,对于测试集的效果不好——高方差(high variance)

导致模型对于训练集的拟合效果好,对于测试集的效果不好——高方差(high variance)学习曲线:

+评价分类(尤其针对分布不平衡的数据)

+熵(Entropy)

信息增益

如果一个决策结点有三个可选项,可以通过独热编码的方式将其转换为多个二分类形式。

+如果变量是连续的数值,可以计算从那里开始划分的信息增益最高,从而转化为判断大小于的二分类形式。

+决策树解决回归问题,则将熵替换为节点上数据的方差进行计算。

+随机森林:

+XGBoost:采样训练数据的时候更倾向于采样前面的树中被分类错误的数据

+决策树更适用于结构化的数据,快速,但是不适用于其他类似于图片文本等的数据

+神经网络适用于所有类型的数据,运行可能稍慢一些,可以迁移学习,更适合将不同的神经网络结合到一起。

+机器学习-无监督学习,推荐系统与强化学习

+ +In the third course of the Machine Learning Specialization, you will:

+• Use unsupervised learning techniques for unsupervised learning: including clustering and anomaly detection.

+• Build recommender systems with a collaborative filtering approach and a content-based deep learning method.

+• Build a deep reinforcement learning model.

The Machine Learning Specialization is a foundational online program created in collaboration between DeepLearning.AI and Stanford Online. In this beginner-friendly program, you will learn the fundamentals of machine learning and how to use these techniques to build real-world AI applications.

+This Specialization is taught by Andrew Ng, an AI visionary who has led critical research at Stanford University and groundbreaking work at Google Brain, Baidu, and Landing.AI to advance the AI field.

+This 3-course Specialization is an updated and expanded version of Andrew’s pioneering Machine Learning course, rated 4.9 out of 5 and taken by over 4.8 million learners since it launched in 2012.

+It provides a broad introduction to modern machine learning, including supervised learning (multiple linear regression, logistic regression, neural networks, and decision trees), unsupervised learning (clustering, dimensionality reduction, recommender systems), and some of the best practices used in Silicon Valley for artificial intelligence and machine learning innovation (evaluating and tuning models, taking a data-centric approach to improving performance, and more.)

+By the end of this Specialization, you will have mastered key concepts and gained the practical know-how to quickly and powerfully apply machine learning to challenging real-world problems. If you’re looking to break into AI or build a career in machine learning, the new Machine Learning Specialization is the best place to start.

+无监督学习是在没有标签的数据中自动寻找某些规律

+聚类任务是典型的无监督学习任务,通过某些特征将相似的人或事物自动归为一类

+无监督学习任务还有异常检测(找出一些不寻常的数据)和维度降低(使用更少的数字对数据进行压缩)

+聚类是一种典型的无监督学习算法,不定义标签,让算法自己去寻找数据中有趣的特征

+聚类可以在下面几个方面得到应用:

+K-means聚类步骤:

+ 个中心点

个中心点 (

( 预先定义)

预先定义)如何决定聚类的数量?Elbow method

+多种聚类数量都尝试一下,找到“肘点”,也就是增加聚类数量后代价函数也不能明显减小的点

+如何随机初始化最初的类别中心点?

+已经拥有一些数据,增加一条数据,判断其是否符合已有的数据的特征,如果不符合则为异常数据

+正态分布:

异常检测:

实际应用中,可以找一些有标记的异常点,指导算法选取合适的阈值

在某种类别(异常)的数据量很少的情况下,且异常的种类较多,特征无法很好区分出来的时候,使用异常检测算法比较好。

+场景:很多用户对电影进行打分,分数从0-5,如何向用户推荐合适的电影?

+设用户的数量为

如果用户

预测用户

代价函数:

对所有用户来说,

前面是有特征,通过类似于线性回归的方式可以进行预测,但是如果没有特征应该怎么做呢?

+已知

代价函数:

将两个代价函数结合到一起:

如果评分是二值化的,则类似于线性回归与逻辑回归的区别:

+如果一个人没有对任何电影进行评分,则选取其他所有人的评分平均值作为他的评分。

+协同过滤算法的局限性:

+协同过滤算法是基于用户的评分,根据比较相似的评分情况来进行推荐

+基于内容的过滤算法是基于用户和物品的特征来寻找比较合适的匹配对

+设用户

比较两个特征之间相似度的方法是点乘,但是两者的维度不同,因此要对输入的特征增加几层神经网络,使其输出相同,再进行点乘。

+通过神经网络后,

代价函数为::

检索和排序策略:

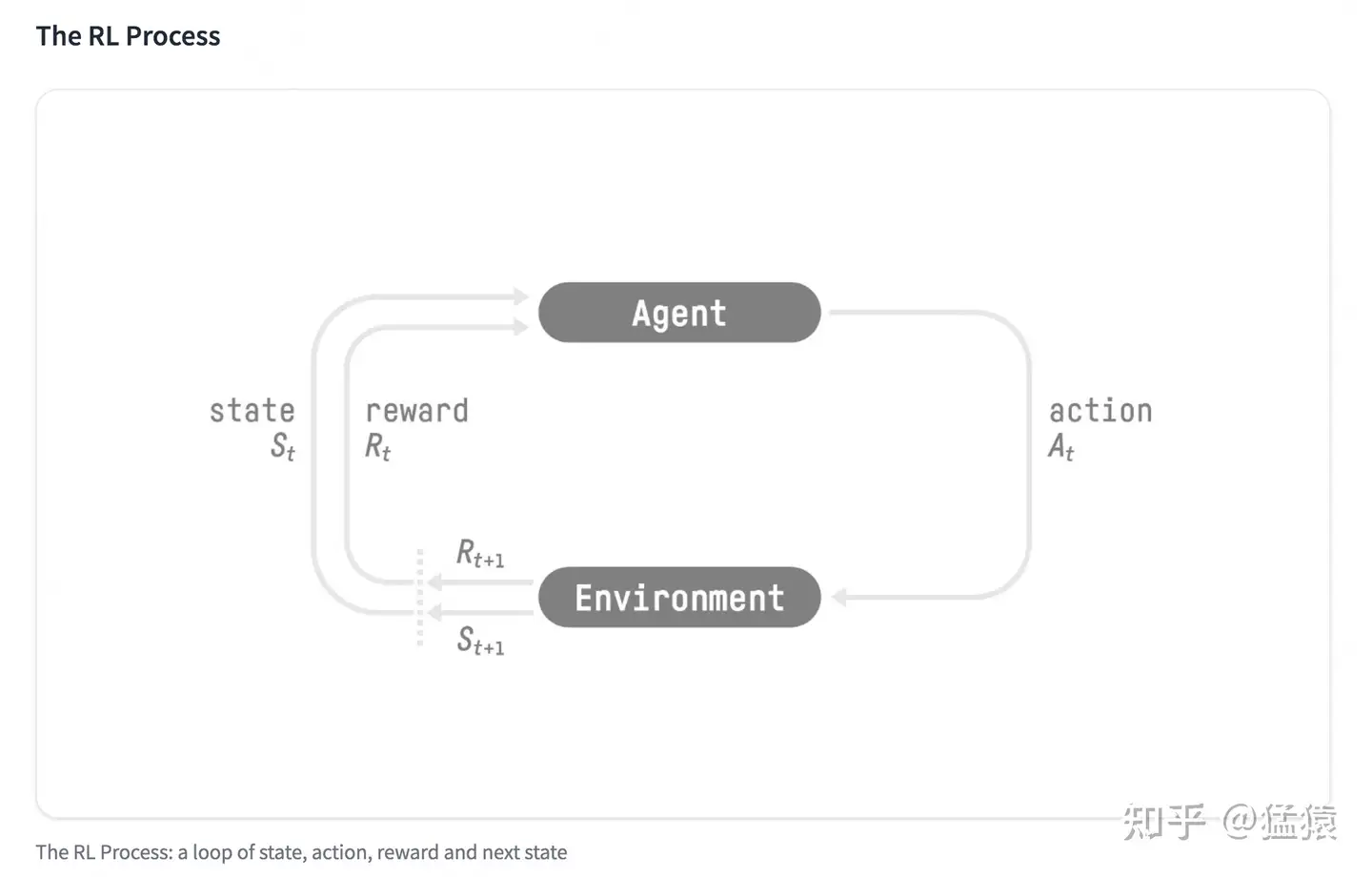

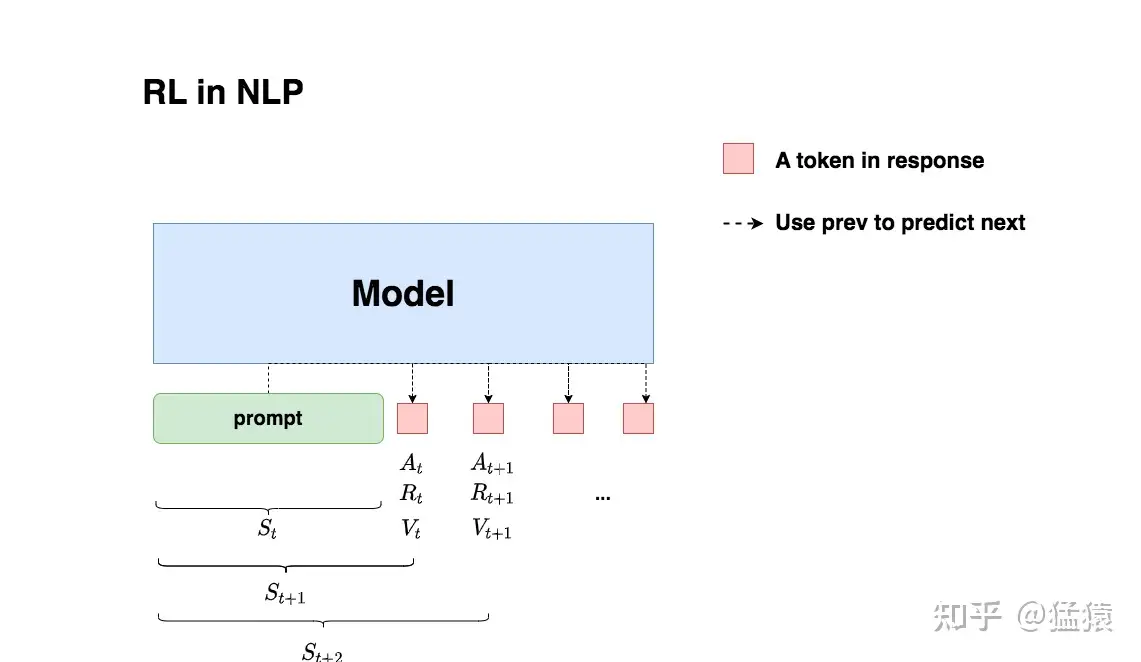

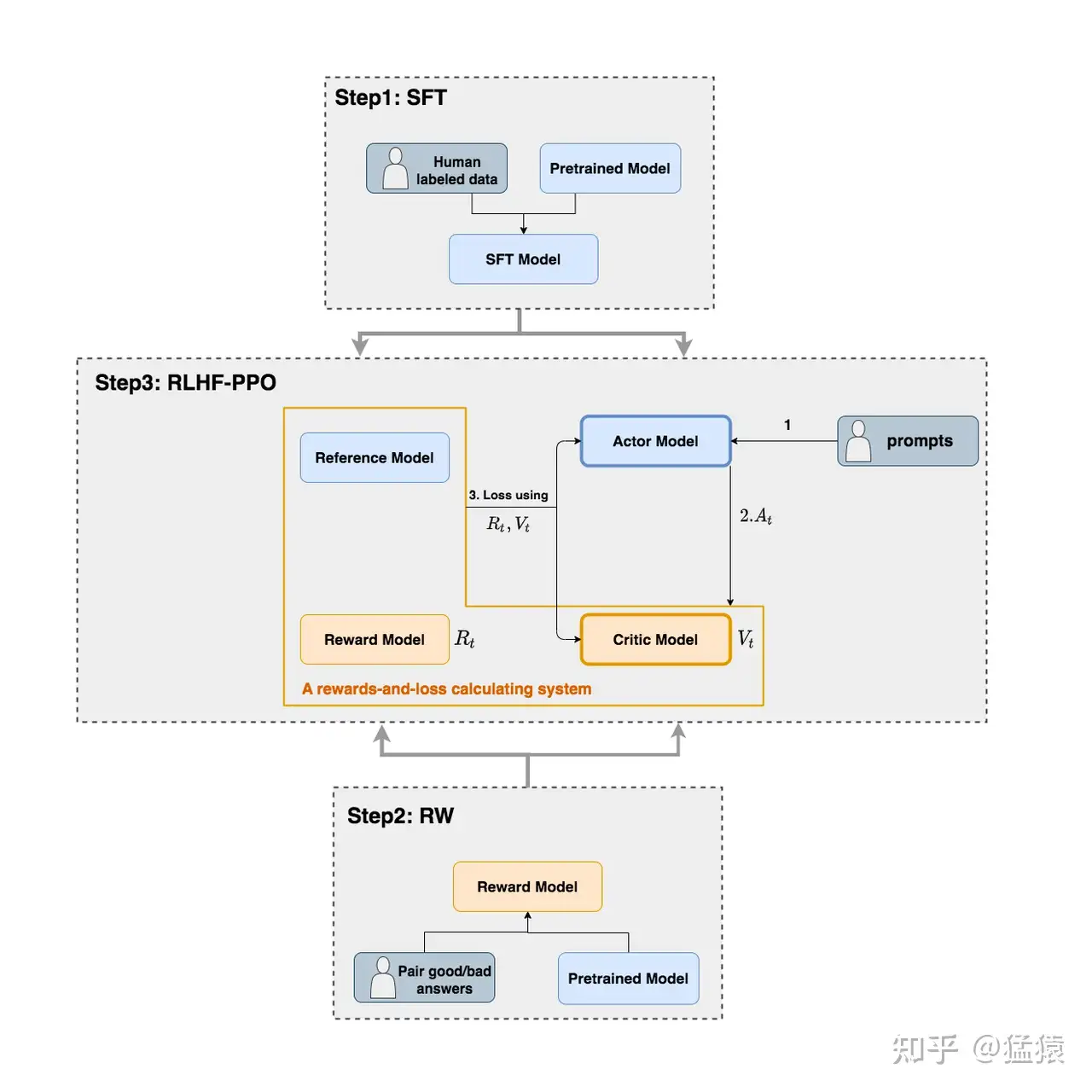

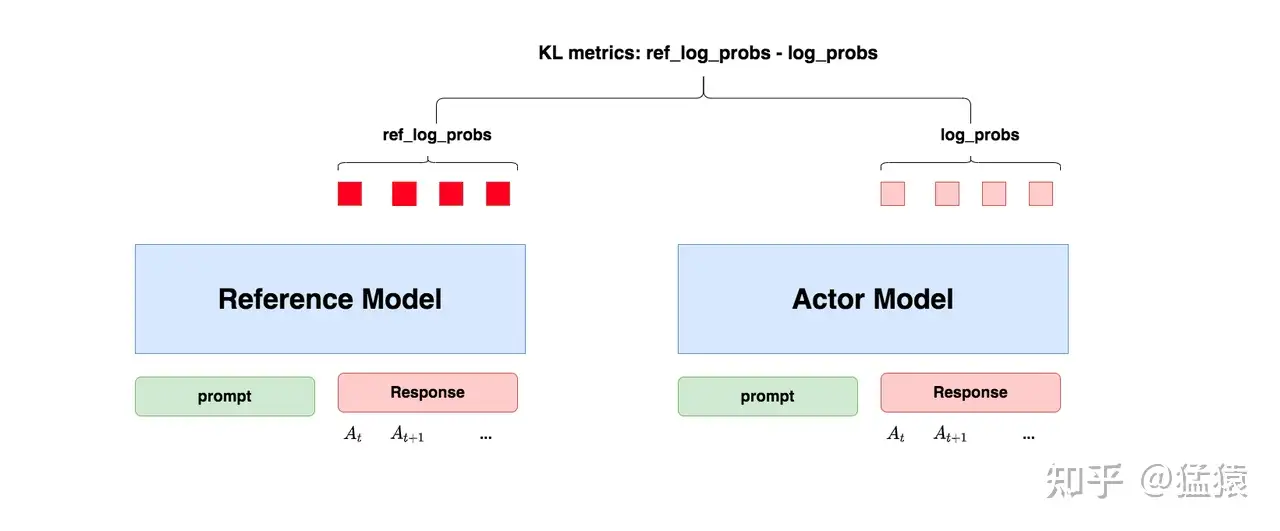

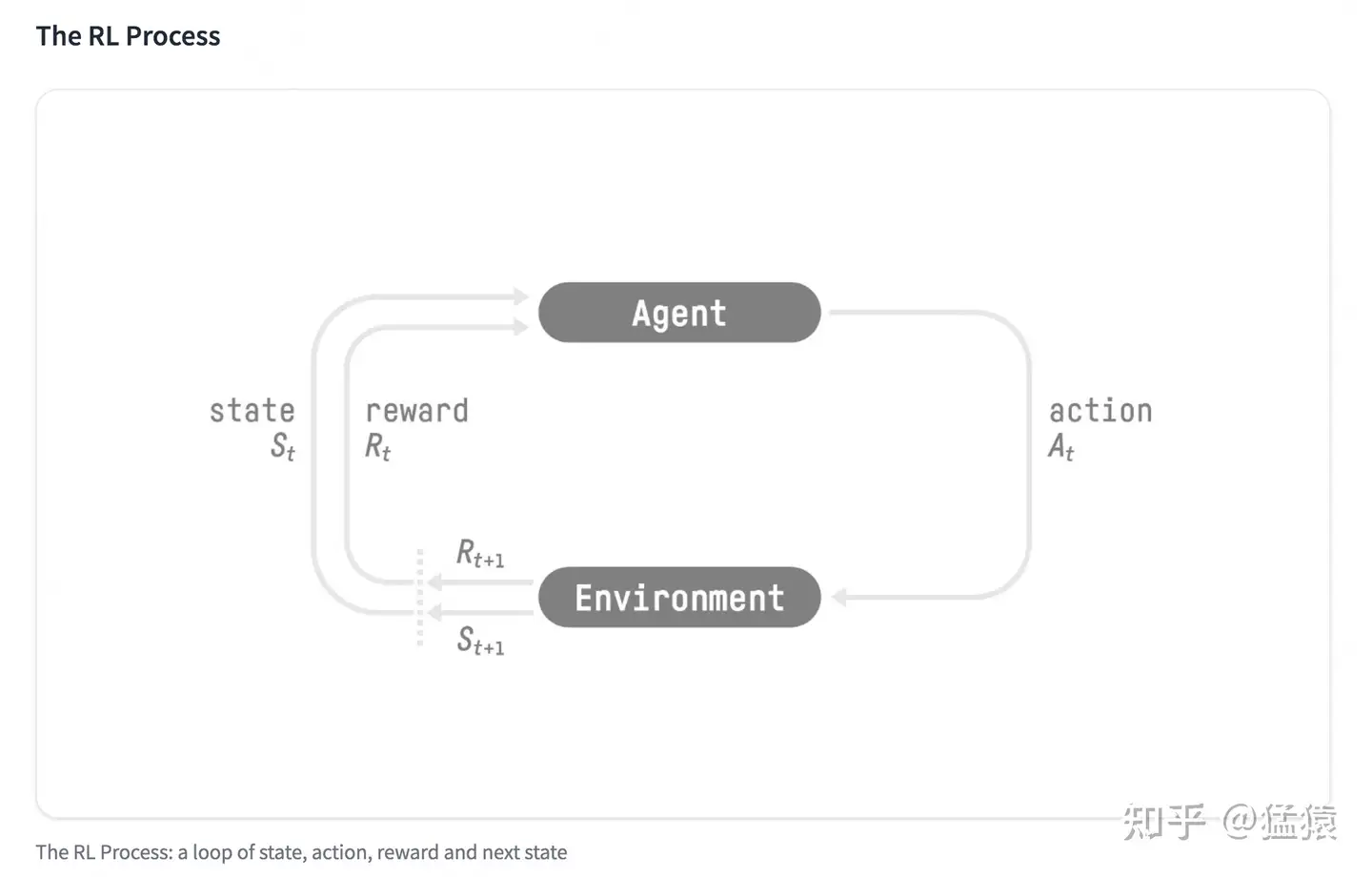

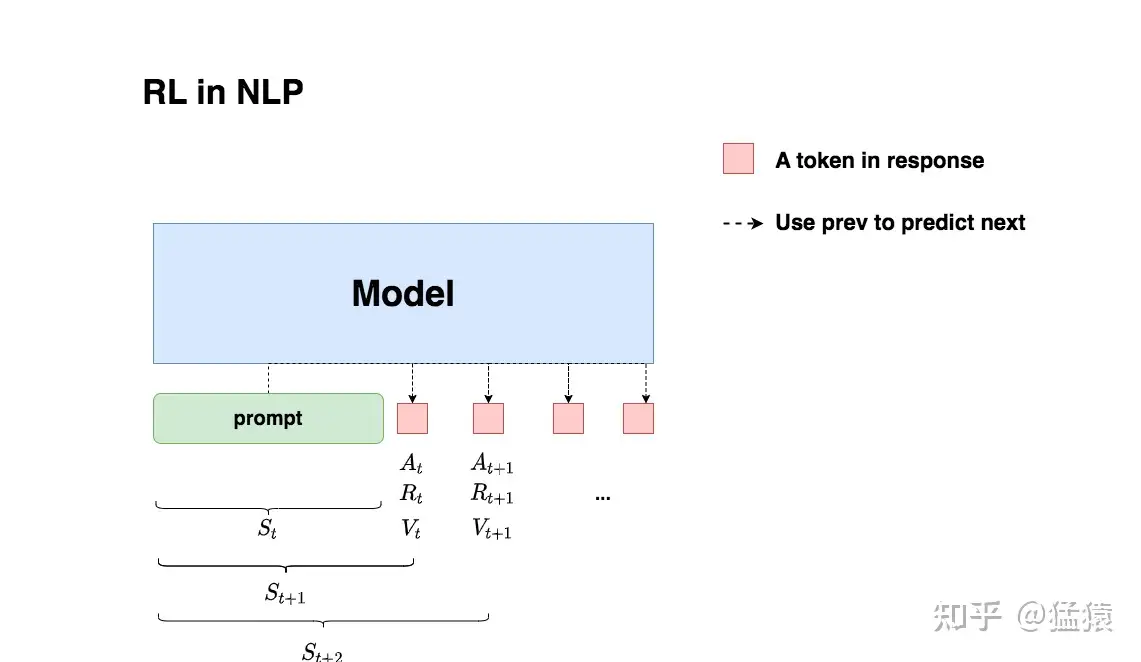

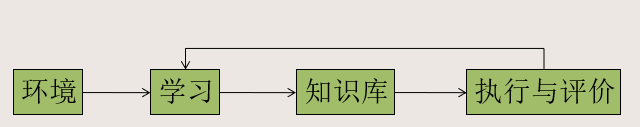

+强化学习不告诉应该怎么做,而是只告诉做什么,如果做的好有奖励,做的不好有惩罚,从而让算法自动向着奖赏最多的方向优化,最终学习出最好的结果。

+目前的状态、动作、奖励、下一个状态,下一个状态的动作

每一个时间步后,会有一个权重

一般来说,权重按照幂的方式变化,如第一步是

措施

强化学习的目标就是找到合适的措施

马尔可夫决策过程:未来只取决于现在所处的位置,与之前是怎么到达现在这个位置的无关。

+状态-动作方程:

因此,可以得出两个结论:

+ 开始的最佳的返回奖励是

开始的最佳的返回奖励是

开始的最好的动作是能达到

开始的最好的动作是能达到 的动作

的动作

贝尔曼方程:

在更为复杂的环境下,状态之间的转移可能并不是确定的,有一定的几率到达其他的状态

+因此得到的返回奖励实际上是期望的返回奖励,即

状态空间可能是连续的,对于月球车来说,有方向(前后左右和旋转)和速度两种变量,因此

训练神经网络:输入是

训练步骤:

+

作为输入,

作为输入, 作为输出训练

作为输出训练 使得

使得

,重复上述步骤

,重复上述步骤

mini-batch:在

soft update:

Numpy是个好东西,但是ndarray的轴感觉弄不太明白。可能二维三维数组还好,要是再增加几维就无法在脑海中想象这个东西,对于一些有关轴的操作就稀里糊涂,只能一个个尝试。现在准备把它彻底弄明白!

+ +首先从二维入手,然后扩展到三维以及更高的维度(从特殊到一般),然后找出普遍的规律,再进行验证(从一般到特殊)

+官方文档应该是最权威的,首先看官方文档是怎么说明的,然后查找一些资料,看看其他人是怎么理解的,最后总结出自己的一套规律

+import numpy as np感受一个ndarray,最简单的方法就是打印ndarray的shape。

+官方文档里面是这样写的:

+the dimensions of the array. This is a tuple of integers indicating the size of the array in each dimension. For a matrix with n rows and m columns, shape will be (n,m). The length of the shape tuple is therefore the number of axes, ndim.

只列举了矩阵的例子,尝试一下:

+a1 = np.arange(15).reshape(3, 5)

+print(a1,'\n',a1.shape,'\n',a1.ndim)输出结果:

+[[ 0 1 2 3 4]

+ [ 5 6 7 8 9]

+ [10 11 12 13 14]]

+ (3, 5)

+ 2简单推断:最开始有2个方括号,因此矩阵是2维的,且第1个方括号内部有3个“2级方括号”,每一个“2级方括号”内部都有5个元素,因此这个shape可能是从外向里数的。

+尝试1维ndarray:

+a2 = np.arange(15)

+print(a2,'\n',a2.shape,'\n',a2.ndim)输出结果:

+[ 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14]

+ (15,)

+ 1尝试3维ndarray:

+a3 = np.arange(24).reshape(3,2,4)

+print(a3,'\n',a3.shape,'\n',a3.ndim)输出结果:

+[[[ 0 1 2 3]

+ [ 4 5 6 7]]

+

+ [[ 8 9 10 11]

+ [12 13 14 15]]

+

+ [[16 17 18 19]

+ [20 21 22 23]]]

+ (3, 2, 4)

+ 3尝试4维ndarray:

+a4 = np.arange(24).reshape(3,2,1,4)

+print(a4,'\n',a4.shape,'\n',a4.ndim)输出结果:

+[[[[ 0 1 2 3]]

+

+ [[ 4 5 6 7]]]

+

+

+ [[[ 8 9 10 11]]

+

+ [[12 13 14 15]]]

+

+

+ [[[16 17 18 19]]

+

+ [[20 21 22 23]]]]

+ (3, 2, 1, 4)

+ 4因此可以得出结论:对于给定的ndarray,判断ndim就是计数最前面有多少个相连的方括号,判断shape就是从外向内看,每一层分别有多少个“元素”。

+也可以看出,数组超过4维后,肉眼就有些难以区分了。

+索引就是取数组中的某些元素,官方文档有下面的举例:

+>>> a = np.arange(30).reshape(2, 3, 5)

+>>> a

+array([[[ 0, 1, 2, 3, 4],

+ [ 5, 6, 7, 8, 9],

+ [10, 11, 12, 13, 14]],

+

+ [[15, 16, 17, 18, 19],

+ [20, 21, 22, 23, 24],

+ [25, 26, 27, 28, 29]]])

+>>> a[0, 2, :]

+array([10, 11, 12, 13, 14])

+>>> a[0, :, 3]

+array([ 3, 8, 13])索引操作是与shape相对应的。如上述例子,a[0]即为取数组的第1个维度(2)的第1个元素,这样原来3维的数组就降到了2维;a[0, :]就是在a[0]的基础上取数组的第2个维度(3)的全部元素,数组的维度不变,还是2维;a[0, :, 3]就是在a[0, :]的基础上取数组的第3个维度(5)的第4个元素,即可得出上面的结果。

+索引操作后的维度与索引的数量以及是否有“:”相关。如果索引的数量与ndim相同,则最后取出来的是一个数。如果数量不同或者有“:”(数量不同可以看成在后面补“:”),则最终取得的数组的维度与“:”对应的原数组的维度相同。

+以numpy.sum为例:

+官方文档:

+Axis or axes along which a sum is performed. The default, axis=None, will sum all of the elements of the input array. If axis is negative it counts from the last to the first axis.

+If axis is a tuple of ints, a sum is performed on all of the axes specified in the tuple instead of a single axis or all the axes as before.

+以三维数组为例:

+print('origin')

+print(a3,a3.shape)

+print('axis=0')

+print(a3.sum(axis=0),a3.sum(axis=0).shape)

+print('axis=1')

+print(a3.sum(axis=1),a3.sum(axis=1).shape)

+print('axis=2')

+print(a3.sum(axis=2),a3.sum(axis=2).shape)

+print('axis=(0,1)')

+print(a3.sum(axis=(0,1)),a3.sum(axis=(0,1)).shape)

+print('axis=(1,2)')

+print(a3.sum(axis=(1,2)),a3.sum(axis=(1,2)).shape)

+print('axis=(0,2)')

+print(a3.sum(axis=(0,2)),a3.sum(axis=(0,2)).shape)

+print('axis=(0,1,2)')

+print(a3.sum(axis=(0,1,2)),a3.sum(axis=(0,1,2)).shape)origin

+[[[ 0 1 2 3]

+ [ 4 5 6 7]]

+

+ [[ 8 9 10 11]

+ [12 13 14 15]]

+

+ [[16 17 18 19]

+ [20 21 22 23]]] (3, 2, 4)

+axis=0

+[[24 27 30 33]

+ [36 39 42 45]] (2, 4)

+axis=1

+[[ 4 6 8 10]

+ [20 22 24 26]

+ [36 38 40 42]] (3, 4)

+axis=2

+[[ 6 22]

+ [38 54]

+ [70 86]] (3, 2)

+axis=(0,1)

+[60 66 72 78] (4,)

+axis=(1,2)

+[ 28 92 156] (3,)

+axis=(0,2)

+[114 162] (2,)

+axis=(0,1,2)

+276 ()axis为多少,就是在这个维度上进行操作,最终的结果就是这个维度消失

+不要从行列什么的去思考怎么变化,直接从shape的角度入手。设置axis为多少,这个维度就没有了!比如原来是(3,2,4)的维度,要是axis=0,第一个维度就没有了,加和得到的矩阵就是(2,4)。

+如果希望保留维度,可以增加keepdims=True的选项,这样被操作的维度就会变为1而不是直接消失。

+print('axis=(0,1)')

+print(a3.sum(axis=(0,1),keepdims=True),a3.sum(axis=(0,1),keepdims=True).shape)axis=(0,1)

+[[[60 66 72 78]]] (1, 1, 4)这样想应该会比较好理解,尤其是对于更高维的数组来说,行列的概念基本失效,从shape的角度思考会好。

+另外一个比较常用的操作是np.concatenate,可以将数组进行合并,在数据处理或者神经网络中很常用。

+在np.concatenate上检验一下对于axis的理解:

+ta = np.arange(24).reshape(3,2,4)

+tb = np.arange(24,36).reshape(3,1,4)

+print(ta,ta.shape)

+print(tb,tb.shape)[[[ 0 1 2 3]

+ [ 4 5 6 7]]

+

+ [[ 8 9 10 11]

+ [12 13 14 15]]

+

+ [[16 17 18 19]

+ [20 21 22 23]]] (3, 2, 4)

+[[[24 25 26 27]]

+

+ [[28 29 30 31]]

+

+ [[32 33 34 35]]] (3, 1, 4)两者合并,第2个维度不相同,应该是可以合并的,合并后的shape应该为(3,3,4)

+print(np.concatenate((ta,tb),axis=1),np.concatenate((ta,tb),axis=1).shape)[[[ 0 1 2 3]

+ [ 4 5 6 7]

+ [24 25 26 27]]

+

+ [[ 8 9 10 11]

+ [12 13 14 15]

+ [28 29 30 31]]

+

+ [[16 17 18 19]

+ [20 21 22 23]

+ [32 33 34 35]]] (3, 3, 4)np.concatenate除了在待合并的axis上之外,必须具有相同的shape

+之前的结论也得到了验证。

+我们处在三维空间中,二维和三维是比较直观的,可以在脑海中想象出来。因此我们会觉得axis的设计有些反直觉。以后应该从shape的角度去看待axis的设计思想,首先理解上比较直观,其次在更高维度的数组上也能合理的进行操作。不要去思考数组实际中应该是个什么样子,直接观察axis就足够了。

+上大学之前,父母特意嘱咐借钱的问题,我当时觉得现在和以前不一样了,以前父母上学的时候可能零花钱限额比较严格,生活也不太好。现在大家基本都是独生子女,而且正规的借钱手段也不少,比如“花呗”等等。因此我不觉得有人会向我借钱,我自己也决定把不借给别人钱作为一条原则。大学四年风平浪静,然而今天下午就突然碰到了这个问题。

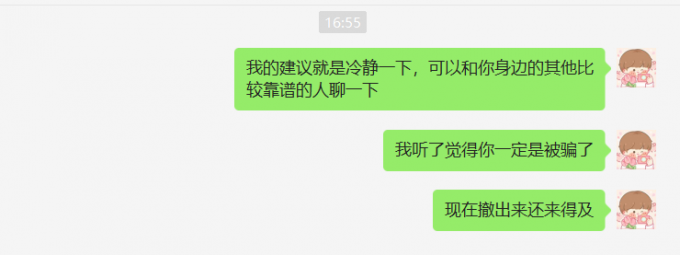

+大学有三个室友,分别用QLD代替吧。Q保研了本校,L在深圳工作,D在二战考研。首先要说明的是,在我2年对他们的了解下,人品都没有问题。今天下午Q突然打微信电话给我,要借6000元钱。(可惜是微信电话没有留下录音证据)首先他说的是个人原因,明天就会还我,不好找父母要。再三追问下,他说是“类似于赌博的平台,自己是内部参加的,就是自己操作失误了,现在急需这些钱,明天肯定能赚回来”云云。他还说就算赚不回来明天也会找父母要还我。当然我非常相信他的人品,但是我感觉这个就是一个非常经典的骗局,我不想看到他越陷越深,就劝了他一阵,主要说的就是希望他能冷静下来好好想想。我劝不回来他,中间有一句话骗了他一下说我现在没有钱,也要找父母要。最终也没有借给他。后面打过电话后我也劝了几句话,但是他没有回复我。

+ +

+我也想到了他会找我的另外的室友,我也知道这件事情知道的人越少越好,所以我找了和他关系更好一点的L。结果L一直都没有回复我,差不多半个多小时后,我们才交流了一下。L告诉我Q除了找我之外也找了L和D,他们俩一人借了3000元钱,算是Q借钱成功了。

+我不知道D怎么想的,但是可能他家比较有钱,可能人家也不在乎这个。L和我交流了一下,大意就是他也知道十有八九是一个骗局,但是还是借给他了。

+ +

+我本来还是挺理直气壮的,我认为我做的没什么问题,而且很遗憾没有把他们俩及时劝住。但是L一句话让我没话说了。

+“如果他找其他人借,那事情会更难搞”

+不是黑Q,主要是大学几年我们都看在眼里,确实没有什么很好的朋友。可能平时聊天最多的就是我们三个了。真的如果我们三个都不借给他,那他会怎么办呢?难道我们几个真的能劝住吗?而且已经毕业了我们又不在身边,谁知道他会做什么?高利贷?我不敢往下想了。都毕业了不可能找学校的任何人帮助他,又不知道他家庭的电话,打110也只能打到我自己家。所以是不是在充分了解这个人的情况下,劝说无效后借钱给他才是最好的帮助他的办法?

+所以我一直到晚上一直都不太舒服,感觉自己一直坚守的底线被我自己动摇了。以后再遇到这样的事情怎么办?

+还这么办!坚守底线!听对象的话!

+当然我有十足的把握是了解Q的,才会这么纠结。一般的同学或者同事什么的肯定坚守底线的。

+明天就出结果了,当然我还是认为99%是被骗了,现在又比较担心骗子还有后招,他会不会继续借钱。

+后续:

+ +

+果然是被骗了,傻孩子,咋办啊。。。。

+后续更新:一直都没有理我,估计是认为我不够意思了。哎,心情复杂,没有什么办法,朋友没了就没了吧。

+ + +C++ Primer 阅读笔记 - 第一部分 C++基础

+ +大一学过C语言,当时学的不是很好,但是后面接触到算法竞赛的时候就慢慢补上来了,而且增加了一些C++特性以及STL标准模板库,也靠着半吊子C++拿了一些小奖,但是确实没有系统的学过C++。总之听说C++比较难,这次准备半系统性的学习一下。之前会的东西就做做题简单过一下,不会的重点看,尤其是指针和面向对象方面。希望以后能更加得心应手地使用C++,也为后面求职打打基础。

+std::cout << "/*";

+std::cout << "*/";

+std::cout << /* "*/" *.;

+std::cout << /* "*/" /* "/*" */;前两行没问题,注释只有一边,编译运行顺利通过

+第三行注释全,但是字符串不全,缺少右边的",编译运行不能通过

+第四行两边分别有两组注释,且中间的字符串是全的,因此编译运行顺利通过

+int sum = 0,value = 0;

+while(std::cin >> value){

+ sum += value;

+}

+std::cout << sum << std::endl;读取数量不定的整数,将其加和。

+std::cin属于一种 istream对象,将其作为条件时是检测流的状态,遇到文件结束符或者无效输入时会变为无效,从而退出循环。

在Ubuntu中输入 Ctrl+D来输入一个文件结束符。

定义好的头文件:

+#ifndef SALESITEM_H

+// we're here only if SALESITEM_H has not yet been defined

+#define SALESITEM_H

+

+// Definition of Sales_item class and related functions goes here

+#include <iostream>

+#include <string>

+

+class Sales_item {

+// these declarations are explained section 7.2.1, p. 270

+// and in chapter 14, pages 557, 558, 561

+friend std::istream& operator>>(std::istream&, Sales_item&);

+friend std::ostream& operator<<(std::ostream&, const Sales_item&);

+friend bool operator<(const Sales_item&, const Sales_item&);

+friend bool

+operator==(const Sales_item&, const Sales_item&);

+public:

+ // constructors are explained in section 7.1.4, pages 262 - 265

+ // default constructor needed to initialize members of built-in type

+ Sales_item() = default;

+ Sales_item(const std::string &book): bookNo(book) { }

+ Sales_item(std::istream &is) { is >> *this; }

+public:

+ // operations on Sales_item objects

+ // member binary operator: left-hand operand bound to implicit this pointer

+ Sales_item& operator+=(const Sales_item&);

+

+ // operations on Sales_item objects

+ std::string isbn() const { return bookNo; }

+ double avg_price() const;

+// private members as before

+private:

+ std::string bookNo; // implicitly initialized to the empty string

+ unsigned units_sold = 0; // explicitly initialized

+ double revenue = 0.0;

+};

+

+// used in chapter 10

+inline

+bool compareIsbn(const Sales_item &lhs, const Sales_item &rhs)

+{ return lhs.isbn() == rhs.isbn(); }

+

+// nonmember binary operator: must declare a parameter for each operand

+Sales_item operator+(const Sales_item&, const Sales_item&);

+

+inline bool

+operator==(const Sales_item &lhs, const Sales_item &rhs)

+{

+ // must be made a friend of Sales_item

+ return lhs.units_sold == rhs.units_sold &&

+ lhs.revenue == rhs.revenue &&

+ lhs.isbn() == rhs.isbn();

+}

+

+inline bool

+operator!=(const Sales_item &lhs, const Sales_item &rhs)

+{

+ return !(lhs == rhs); // != defined in terms of operator==

+}

+

+// assumes that both objects refer to the same ISBN

+Sales_item& Sales_item::operator+=(const Sales_item& rhs)

+{

+ units_sold += rhs.units_sold;

+ revenue += rhs.revenue;

+ return *this;

+}

+

+// assumes that both objects refer to the same ISBN

+Sales_item

+operator+(const Sales_item& lhs, const Sales_item& rhs)

+{

+ Sales_item ret(lhs); // copy (|lhs|) into a local object that we'll return

+ ret += rhs; // add in the contents of (|rhs|)

+ return ret; // return (|ret|) by value

+}

+

+std::istream&

+operator>>(std::istream& in, Sales_item& s)

+{

+ double price;

+ in >> s.bookNo >> s.units_sold >> price;

+ // check that the inputs succeeded

+ if (in)

+ s.revenue = s.units_sold * price;

+ else

+ s = Sales_item(); // input failed: reset object to default state

+ return in;

+}

+

+std::ostream&

+operator<<(std::ostream& out, const Sales_item& s)

+{

+ out << s.isbn() << " " << s.units_sold << " "

+ << s.revenue << " " << s.avg_price();

+ return out;

+}

+

+double Sales_item::avg_price() const

+{

+ if (units_sold)

+ return revenue/units_sold;

+ else

+ return 0;

+}

+#endif

+暂时不用怎么管,先试着使用:

+Sales_item book; // 创建一个对象

+std::cin >> book;

+std::cout << book << std::endl;

+return 0;0-201-70353-x 4 24.99

+> 0-201-70353-x 4 99.96 24.99Sales_item book1,book2; // 创建一个对象

+std::cin >> book1 >> book2;

+std::cout << book1+book2 << std::endl;

+return 0;0-201-70353-x 3 20.00

+0-201-70353-x 2 25.00

+> 0-201-70353-x 5 110 22Sales_item book1,book2; // 创建一个对象

+std::cin >> book1 >> book2;

+if(book1.isbn() == book2.isbn()){

+ std::cout << book1+book2 << std::endl;

+}

+else{

+ std::cerr << "Error!" << std::endl;

+}

+return 0;0-201-70353-x 3 20.00

+0-201-70343-x 2 25.00

+> Error!#include <bits/stdc++.h>

+#include "Sales_item.h"

+int main(void){

+ Sales_item total;

+ if(std::cin >> total){ // 读取第一条数据,确保有数据可以处理

+ Sales_item trans;

+ while(std::cin >> trans){

+ if(total.isbn() == trans.isbn()){

+ total += trans;

+ }

+ else{

+ std::cout << total << std::endl;

+ total = trans;

+ }

+ }

+ std::cout << total << std::endl; // 打印最后一本书

+ }

+ else{

+ std::cerr << "No data!" << std::endl;

+ }

+ return 0;

+}0-201-70353-X 4 24.99

+0-201-82470-1 4 45.39

+0-201-88954-4 2 15.00

+0-201-88954-4 5 12.00

+0-201-88954-4 7 12.00

+0-201-88954-4 2 12.00

+0-399-82477-1 2 45.39

+0-399-82477-1 3 45.39

+0-201-78345-X 3 20.00

+0-201-78345-X 2 25.00

+>

+0-201-70353-X 4 99.96 24.99

+0-201-82470-1 4 181.56 45.39

+0-201-88954-4 16 198 12.375

+0-399-82477-1 5 226.95 45.39

+0-201-78345-X 5 110 22这个程序的局限性在于,必须是连号的输入,不连号的输入就失效了。

+当然这个时候学到的还不多,后面会将这个程序继续完善。

+整型可以分为带符号类型和无符号类型(在前面添加 unsigned)

选择类型的原则:

+创建变量时赋予其一个初始值(赋值指的是将对象的当前值用一个新值来替代,含义不同)

+初始化的4种方式:

+int a = 0;int a = {0};int a{0}; // 列表初始化int a(0);变量声明:“一个文件如果想使用别处定义的名字,必须包含对那个名字的声明”

+与定义的区别在于不赋初值

+extern int i;

如:

+int a = 0;

+int main(void){

+ std::cout << a << std::endl;

+ int a = 1;

+ std::cout << a << std::endl;

+ std::cout << ::a << std::endl; // 显式指定访问全局变量

+ return 0;

+}0

+1

+0相当于为对象起一个另外的名字,通过 &符号来定义

int ival = 1024;

+int &refVal = ival;引用必须初始化,因为引用需要和它的初始化对象一起绑定在一起,不能重新绑定到其他对象。

+定义引用之后,对其进行的所有操作都是在它的绑定对象上进行的

+refVal = 12;

+std::cout << refVal << std::endl;12引用本身不是一个对象,不能定义引用的引用

+如下面的方式,实际上是绑定到了该引用对应的绑定对象上:

+int &refVal2 = refVal;

+std::cout << refVal2 << std::endl;12引用的类型要与绑定的对象严格匹配

+引用不能绑定到字面值上

+指针也实现了对其他对象的间接访问,但是指针本身也是一个对象,通过 *符号来定义

&int ival = 42;

+int *p = &ival;指针的类型也要与它所指向的对象严格匹配

+*来访问这个对象int ival = 42;

+int *p = &ival;

+std::cout << *p << std::endl;42符号的多重含义:

+int i = 42;

+int &r = i; // &随类型名出现,是声明的一部分,r是一个引用

+int *p; // *随类型名出现,是声明的一部分,p是一个指针

+p = &i; // &出现在表达式中,是一个取地址符

+*p = i; // *出现在表达式中,是一个解引用符

+int &r2 = *p; // r2是一个引用,*是一个解引用符

+std::cout << i << std::endl << r << std::endl << *p << std::endl << r2 << std::endl;42

+42

+42

+42空指针:int *p1 = nullptr

建议:初始化所有的指针

+指针与引用不同,是可以赋值的。赋值的时候永远改变的是等号左侧的对象。

+void*指针,可以用于存放任意类型对象的地址

double obj = 3.14;

+double *pd = &obj;

+void *pv = &obj;

+pv = pd;

+std::cout << *pv << std::endl;error: ‘void*’ is not a pointer-to-object typevoid*指针只能与其他指针作比较,作为函数的输入和输出,或者赋值给另外一个 void*指针。

甚至连访问对象都不可以

+指向指针的指针

+int ival = 1024;

+int *pi = &ival;

+int **ppi = π

+std::cout << ival << std::endl;

+std::cout << *pi << std::endl;

+std::cout << **ppi << std::endl;1024

+1024

+1024指向指针的引用

+int i = 42;

+int *p;

+int *&r = p;

+r = &i; // p = &i;

+std::cout << i << std::endl;

+std::cout << *r << std::endl;

+std::cout << *p << std::endl;42

+42

+42阅读定义要从右往左,离变量名最近的符号对变量类型有最直接的影响

+最近的是 &,因此 r是一个引用

然后是 *,说明 r引用的是一个指针

const对象一旦创建,值不可以再改变,因此在创建的时候必须初始化

const int a = 45;

只能在 const类型的对象上执行不改变其内容的操作

可以添加extern关键字,使const变量在文件间共享

+extern const int bufSize = fcn(); // file.cpp定义并初始化了这个常量,可以被其他文件访问

+extern const int bufSize; // file.h 和上面的变量是同一个,只是一个声明,说明定义会在其他地方出现const的引用是对常量的引用,不能改变引用的值,引用的时候也要添加 const限定符

const int ci = 1024;

+const int &r1 = ci;初始化常量引用时可以使用任意的表达式,只要表达式的结果能转化成引用的类型即可

+int i = 42;

+const int &r1 = i;

+const int &r2 = 42;

+const int &r3 = r1 * 2;

+std::cout << r1 << std::endl;

+std::cout << r2 << std::endl;

+std::cout << r3 << std::endl;

+i = 56;

+std::cout << r1 << std::endl;

+std::cout << r2 << std::endl;

+std::cout << r3 << std::endl;42

+42

+84

+56

+42

+84因此,对 const的引用可以并非一个 const的对象,不能通过这种引用改变被引用的对象的值,但是可以通过其他方式改变这个对象的值

指向常量的指针也不能用于改变其所指对象的值,且指向常量的指针所指的对象也不一定是一个常量

+const double pi = 3.14;

+const double *cptr = &pi

+std::cout << *cptr << std::endl;

+double dval = 3.14;

+cptr = &dval;

+std::cout << *cptr << std::endl;3.14

+3.14const指针:将指针本身定义为常量,也就是指针所指的地址不变

int errNumb = 0;

+int *const curErr = &errNumb; // curErr将一直指向errNumb,不能改变

+const double pi = 3.14159;

+const double *const pip = &pi // 一个指向常量对象的常量指针

+*curErr = 56;

+std::cout << errNumb << std::endl;56指针所指的地址不变,但是如果指向的不是常量,还是可以改变指向的值的

+顶层 const可以表示任意的对象是一个常量,底层 const与复合类型有关,指的是下一层对象是常量。

常量表达式:值不会改变且在编译过程就能得到计算结果的表达式

+将变量声明为 constexpr来由编译器验证是否为一个常量表达式:constexpr int limit = mf + 1;

在 constexpr中如果声明了一个指针,那么一定是常量指针,即顶层 const

类型别名的两种定义方式:

+typedef double wages;

+using wages = double;如果别名是一个复合类型,不能仅仅将其替换进行理解。

+auto类型:将类型交给编译器自己去分析,一般会忽略掉顶层 const,如果需要保留要加 const auto进行推断

decltype类型指示符:通过表达式的类型推断出要定义的变量的类型

const int a = 0,b = 0;

+decltype(a+b) x = 0;

+std::cout << x << std::endl;0如果希望得到引用类型,可以添加两层括号,即 decltype((a+b))

struct Sales_data{

+ std::string bookNo;

+ unsigned units_sold = 0;

+ double revenue = 0.0;

+};读取单价和数量,输出总价格

+Sales_item book; // 创建一个对象

+std::cin >> book;

+std::cout << book << std::endl;

+return 0;0-201-70353-x 4 24.99

+> 0-201-70353-x 4 99.96 24.99头文件:包含只能被定义一起的实体

+通过头文件保护符来确保不允许重复包含:

+#ifndef SALES_DATA_H

+#define SALES_DATA_H

+#include <string>

+struct Sales_data{

+ std::string bookNo;

+ unsigned units_sold = 0;

+ double revenue = 0.0;

+};

+#endifusing声明:使用命名空间中的成员

using std::cin;头文件不应包含 using声明

string s1;

+string s2(s1); // string s2 = s1;

+string s3("value"); // string s3 = "value";

+string s4(10,'c');

+cout << s1 << endl;

+cout << s2 << endl;

+cout << s3 << endl;

+cout << s4 << endl;

+

+value

+cccccccccc初始化分为直接初始化和拷贝初始化,有 =的为拷贝初始化,一般只用于单个初始值的情况下

输入输出与对整数等的操作相同

+使用getline读入一整行(可以带空格)

+string line;

+while(getline(cin,line)){

+ cout << line << endl;

+}

+return 0;> fds fdsfdsf dsf

+fds fdsfdsf dsf

+> dsfdsfdsfds fdsfds

+dsfdsfdsfds fdsfdsstring.size()返回的是无符号整形数,不要去负数值混用

字面值不为字符串,不能将字面值相加,只能将字符串相加,如 "df"+"fdsfs"是不合法的

基于范围的 for语句:遍历给定序列中的每一个元素

string str("some string");

+for (auto c : str){

+ cout << c;

+}

+cout << endl;some string如果要改变字符,需要使用引用类型:

+string str("some string");

+for (auto &c : str){

+ c = toupper(c);

+}

+cout << str << endl;SOME STRINGvector属于一个类模板,模板不是类或者函数,但是可以看作编译器生成类或函数编写的一份说明,编译器根据模板创建类或函数的过程称为实例化。

vector<int> ivec;

+vector<int> ivec2(ivec);

+vector<int> ivec3 = ivec;

+vector<string> articles{"a","an","the"};

+vector<string> svec(10,"hi");

+for(auto i : svec){

+ cout << i << " ";

+}

+cout << endl;hi hi hi hi hi hi hi hi hi hi值初始化:只初始化 vector的大小,不赋值具体数值 vector<int> i(10)

vector在设计上事先指定容量是不好的做法,比较适合运行时再添加具体的值

循环内部如果包含向 vector添加元素的语句,不能使用范围 for循环

不能用下标形式添加元素,也就是下标操作只能对确知已经存在的元素进行

+vector<int> vi = {1,2,4,5,7,8,9,5,6,4};

+for(auto it1 = vi.begin();it1 != vi.end();it1++){

+ *it1 *= 2;

+}

+for(auto it2 = vi.cbegin();it2 != vi.cend();it2++){

+ cout << *it2 << " ";

+}

+cout << endl;2 4 8 10 14 16 18 10 12 8int a2[] = {0,1,2};

+int a3[5] = {1,2,4}; // 多余的初始化成默认值

+char a4[8] = "Daniel"; // 至少是7,要有一个空字符

+for (auto i: a3){

+ cout << i << " ";

+}

+cout << endl;

+for (auto i: a4){

+ cout << i << " ";

+}

+cout << endl;1 2 4 0 0

+D a n i e l数组不允许拷贝和赋值

+复杂的数组声明:

+int *ptrs[10]; // 含有10个整型指针的数组

+int arr[10];

+int (*Parray)[10] = &arr; // Parray指向一个含有10个整数的数组

+int (&arrRef)[10] = arr; // arrRef引用一个含有10个整数的数组

+int *(&arry)[10] = ptrs; // arry是数组的引用,该数组含有10个指针使用数组的时候编译器一般将其转化为指针

+string nums[] = {"one","two","three"};

+string *p = &nums[0]; // p指向nums的第1个元素

+string *p2 = nums // 等价于上面的语句使用 auto推断时会返回一个指针,但是只用 decltype推断的时候会返回数组

利用指针对数组可以起到迭代器的效果

+int ia[] = {1,2,3,4,5,6,7,8,9};

+int *beg = begin(ia); // 指向ia的第一个元素

+int *last = end(ia); // 指向ia的最后一个元素的下一个位置

+for(auto it = beg;it != last;it++){

+ cout << *it << " ";

+}

+cout << endl;string转化为C风格字符串

string s("Hello World!");

+const char *str = s.c_str();

+cout << *str << endl;使用数组初始化vector

+int int_arr[] = {0,1,2,3,4,5};

+vector<int> ivec(begin(int_arr),end(int_arr));

+for(auto it : ivec){

+ cout << it << " ";

+}

+cout << endl;0 1 2 3 4 5int ia[3][4] = {{1,2,3,4},{5,6,7,8},{9,10,11,12}};

+int (*p)[4] = ia; // p指向含有4个整数的数组

+p = &ia[2]; // p 指向ia的尾元素

+for(auto p = ia;p != ia+3;++p){

+ for(auto q = *p;q != *p+4;q++){

+ cout << *q << " ";

+ }

+}

+cout << endl;

+for(auto p = begin(ia);p != end(ia);++p){

+ for(auto q = begin(*p);q != end(*p);q++){

+ cout << *q << " ";

+ }

+}

+cout << endl;通俗的讲,左值就是能够出现在赋值符号左面的东西,而右值就是那些可以出现在赋值符号右面的东西.

+左值:指表达式结束后依然存在的持久对象,可以取地址,具名变量或对象

+右值:表达式结束后就不再存在的临时对象,不可以取地址,没有名字。

+当一个对象被用作右值的时候,使用的是对象的值(内容);当一个对象被用作左值的时候,用的是对象的身份(在内存中的位置)

+m%n的符号与 m相同

强制类型转换:

+int i = 52;

+int j = 9;

+double slope = static_cast<double>(j) / i;

+cout << slope << endl;0.173077switch语句:

int a;

+while(cin >> a){

+ switch(a){

+ case 0: cout << '1' << endl;break;

+ case 1: cout << '2' << endl;break;

+ case 2: cout << '3' << endl;break;

+ case 3: cout << '4' << endl;break;

+ case 4: cout << '5' << endl;break;

+ case 5: cout << '6' << endl;break;

+ case 6: cout << '7' << endl;break;

+ case 7: cout << '8' << endl;break;

+ case 8: cout << '9' << endl;break;

+ case 9: cout << '0' << endl;break;

+ default: cout << 'N' << endl;break;

+ }

+}> 0

+1

+> 9

+0

+> 45

+Ntry语句块和异常处理:

throw语句抛出异常:

int a = 1;

+throw runtime_error("fdsdfds");terminate called after throwing an instance of 'std::runtime_error'

+ what(): fdsdfds

+Abortedcatch语句捕捉异常:

double m, n;

+cin >> m >> n;

+try {

+ if (n == 0)

+ throw - 1; //抛出整型异常

+ else if (m == 0)

+ throw - 1.0; //拋出 double 型异常

+ else

+ cout << m / n << endl;

+}

+catch (double d) {

+ cout << "catch (double)" << d << endl;

+}

+catch (...) {

+ cout << "catch (...)" << endl;

+}> 0 6

+catch (double)-1

+> 6 0

+catch (...)局部静态对象:程序第一次经过时被初始化,直到程序终止时才被销毁。

+int count_calls(){

+ static int ctr = -1;

+ return ++ctr;

+}

+

+int main(void){

+ for(int i = 0;i != 10; ++i){

+ cout << count_calls() << " ";

+ }

+ cout << endl;

+ return 0;

+}0 1 2 3 4 5 6 7 8 9函数声明(函数原型):在使用函数之前对函数的名字进行声明

+函数声明可以忽略形参的名字,也可以加上形参的名字。

+函数声明最好写在头文件中

+分离式编译:编译和链接多个源文件

+指针形参:

+void reset(int *ip){

+ *ip = 0;

+}

+

+int main(void){

+ int i = 42;

+ reset(&i);

+ cout << i << endl;

+ return 0;

+}0传引用参数:

+void reset(int &i){

+ i = 0;

+}

+

+int main(void){

+ int i = 42;

+ reset(i);

+ cout << i << endl;

+ return 0;

+}0尽量使用引用形式从而避免拷贝

+还可以通过引用形式返回一些额外信息。因为函数只能返回一个返回值,但是如果某个值是引用的形式传到函数中的,也会保留下修改后的值。

+不修改的变量尽量使用常量引用

+数组形参:

+void Print(const int i[]){

+ cout << i[0] << endl;

+}

+

+void Print(const int *i){

+ cout << i[0] << endl;

+}

+

+void Print(const int i[10]){

+ cout << i[0] << endl;

+}

+

+int main(void){

+ int i = 5;

+ int j[2] = {6,7};

+ Print(&i);

+ Print(j);

+}5

+6数组不能直接进行传递,直接作为指针的形式传递,因此丢掉了数组大小的信息

+可以使用指针的形式进行提示,也可以传入一个表示数组大小的参数。

+void print(const int *beg,const int *end){

+ while(beg != end){

+ cout << *beg++ << " ";

+ }

+}

+

+void print(const int i[] ,size_t size){

+ for(size_t a=0;a<size;a++){

+ cout << i[a] << " ";

+ }

+}

+

+int main(void){

+ int i[10] = {6,7,5,4,7,8,9,6,5,4};

+ print(begin(i),end(i));

+ cout << endl;

+ return 0;

+}6 7 5 4 7 8 9 6 5 4数组引用形参:(缺点是只能作用于大小固定的数组)

+void print(int (&arr)[10]){

+ for(auto elem : arr){

+ cout << elem << " ";

+ }

+}含有可变形参的函数:

+void error_msg(initializer_list<string> il){

+ for(auto beg = il.begin();beg != il.end();++beg){

+ cout << *beg << " ";

+ }

+ cout << endl;

+}

+

+int main(void){

+ error_msg({"a","b"});

+ error_msg({"a","b","c"});

+}a b

+a b c函数返回时不要返回局部对象的引用或指针

+调用一个返回引用的函数会得到左值

+char &get_val(string &str,string::size_type ix){

+ return str[ix];

+}

+

+int main(void){

+ string s("a value");

+ cout << s << endl;

+ get_val(s,0) = 'A';

+ cout << s << endl;

+ return 0;

+}a value

+A value返回值也可以是一个花括号包围起来的列表

+定义相同名称的函数,但是形参列表不同,可能是数量上的不同,也可能是类型上的不同。使得函数调用的时候根据不同的形参列表自动判断指定哪一个函数。

+顶层 const不影响传入的参数

在不同的作用域中无法重载函数,会覆盖掉

+默认实参:在函数的声明中给一个默认值,调用时可以覆盖掉,也可以不写以使用默认值。

+内联函数:将函数在调用点展开,但是编译器不一定支持

+constexpr函数:能用于常量表达式的函数,函数的返回值和所有形参的类型都要是字面值类型,函数体中有且只有一条 return语句。

assert表达式:用于调试的时候对程序进行检查 assert(s == "dfdsf");如果不满足条件程序会中断退出。

完全不明白。。。没有示例程序看不懂

+成员函数是类定义的一部分,通过特定的对象来调用。非成员函数就是普通的函数。

+成员函数的声明必须在类的内部,定义可以在类的内部或者外部。非成员函数的声明和定义都在类的外部。

+构造函数:控制对象的初始化过程

+访问控制与封装:

+定义在public说明符后的成员在整个程序内可被访问,public成员定义类的接口。

+定义在private说明符之后的成员可以被类的成员函数访问,但是不能被使用该类的代码访问,private部分封装了类的实现细节。

+使用class和struct定义类的区别在于默认的访问权限不同,struct默认访问权限都是public的

+友元:令其他类或成员成为访问它的非公有成员。但是友元只算一个权限控制,在类外一样要进行声明。

+上述代码:

+#include <bits/stdc++.h>

+using std::string;

+using std::vector;

+using std::cin;

+using std::cout;

+using std::endl;

+using std::begin;

+using std::end;

+using std::runtime_error;

+using std::initializer_list;

+using std::istream;

+using std::ostream;

+

+class Sales_data{

+friend Sales_data add(const Sales_data&,const Sales_data&);

+friend std::ostream &print(std::ostream&,const Sales_data&);

+friend std::istream &read(std::istream&,Sales_data&);

+public:

+ // 构造函数

+ Sales_data() = default; // 默认构造函数

+ // 构造函数初始值列表

+ Sales_data(const std::string &s):bookNo(s){ }

+ Sales_data(const std::string &s,unsigned n,double p):bookNo(s),units_sold(n),revenue(p*n){ }

+ Sales_data(std::istream &);

+ // 常量成员函数

+ std::string isbn() const {

+ return bookNo;

+ }

+ Sales_data &combine(const Sales_data&);

+private:

+ double avg_price() const;

+ std::string bookNo;

+ unsigned units_sold = 0;

+ double revenue = 0.0;

+};

+Sales_data add(const Sales_data&,const Sales_data&);

+std::ostream &print(std::ostream&,const Sales_data&);

+std::istream &read(std::istream&,Sales_data&);

+

+

+// 在类的外部定义成员函数

+double Sales_data::avg_price() const {

+ if(units_sold){

+ return revenue / units_sold;

+ }

+ else{

+ return 0;

+ }

+}

+

+// 定义一个返回this对象的函数

+Sales_data& Sales_data::combine(const Sales_data &rhs){

+ units_sold += rhs.units_sold;

+ revenue += rhs.revenue;

+ return *this;

+}

+

+// 类相关的非成员函数

+istream &read(istream &is, Sales_data &item){

+ double price = 0;

+ is >> item.bookNo >> item.units_sold >> price;

+ item.revenue = price * item.units_sold;

+ return is;

+}

+

+ostream &print(ostream &os,const Sales_data &item){

+ os << item.isbn() << " " << item.units_sold << " " << item.revenue << " " << item.avg_price();

+ return os;

+}

+

+Sales_data add(const Sales_data &lhs,const Sales_data &rhs){

+ Sales_data sum = lhs;

+ sum.combine(rhs);

+ return sum;

+}

+

+// 在类的外部定义构造函数

+Sales_data::Sales_data(std::istream &is){

+ read(is,*this);

+}

+

+int main(void){

+ return 0;

+}

+

+inline写在类内或者类外,一般写在类外const里面也可以变化class Screen{

+ public:

+ typedef std::string::size_type pos; // 定义类型的成员

+ Screen() = default;

+ Screen(pos ht,pos wd,char c): height(ht), width(wd),contents(ht*wd,c){ }

+ char get() const {

+ return contents[cursor]; // 隐式内联函数

+ };

+ inline char get(pos ht,pos wd) const; // 显式内联函数

+ Screen &move(pos r, pos c); // 后面设置为内联函数

+ size_t some_member() const;

+ Screen &set(char);

+ Screen &set(pos,pos,char);

+ Screen &display(std::ostream &os){

+ do_display(os);

+ return *this;

+ }

+ const Screen &display(std::ostream &os) const {

+ do_display(os);

+ return *this;

+ }

+ private:

+ pos cursor = 0;

+ pos height = 0,width = 0;

+ std::string contents;

+ mutable size_t access_ctr = 0;

+ void do_display(std::ostream &os) const {

+ os << contents;

+ }

+};

+

+inline Screen &Screen::move(pos r,pos c){

+ pos row = r * width;

+ cursor = row + c;

+ return *this;

+}

+

+char Screen::get(pos r,pos c) const {

+ pos row = r * width;

+ return contents[row + c];

+}

+

+size_t Screen::some_member() const{

+ ++access_ctr;

+ return access_ctr;

+}

+

+inline Screen &Screen::set(char c){

+ contents[cursor] = c;

+ return *this;

+}

+

+inline Screen &Screen::set(pos r,pos col,char ch){

+ contents[r*width+col] = ch;

+ return *this;

+}

+

+// 类数据成员的初始值

+class Window_mgr{

+ private:

+ std::vector<Screen> screens{Screen(24,80,' ')};

+};

+

+int main(void){

+ Screen myscreen;

+ char ch = myscreen.get();

+ cout << myscreen.some_member() << endl;

+ ch = myscreen.get(0,0);

+ cout << myscreen.some_member() << endl;

+ myscreen.move(4,0);

+ myscreen.set('#');

+ cout << myscreen.get() << endl;

+ Screen myScreen(5,3,'!');

+ const Screen blank(5,3,'?');

+ myScreen.set(2,1,'#').display(cout);

+ cout << endl;

+ blank.display(cout);

+ cout << endl;

+ return 0;

+}1

+2

+#

+!!!!!!!#!!!!!!!

+???????????????类之间的友元关系:不存在传递性

+class Screen{

+ friend class Window_mgr;

+

+// 类数据成员的初始值

+class Window_mgr{

+ public:

+ using ScreenIndex = std::vector<Screen>::size_type;

+ void clear(ScreenIndex);

+ private:

+ std::vector<Screen> screens{Screen(24,80,' ')};

+};

+

+void Window_mgr::clear(ScreenIndex i){

+ Screen &s = screens[i];

+ s.contents = string(s.height * s.width, ' ');

+}class Screen{

+ friend class Window_mgr;

+ public:

+ typedef std::string::size_type pos; // 定义类型的成员

+ Screen() = default;

+ Screen(pos ht,pos wd,char c): height(ht), width(wd),contents(ht*wd,c){ }

+ char get() const {

+ return contents[cursor]; // 隐式内联函数

+ };

+ inline char get(pos ht,pos wd) const; // 显式内联函数

+ Screen &move(pos r, pos c); // 后面设置为内联函数

+ size_t some_member() const;

+ Screen &set(char);

+ Screen &set(pos,pos,char);

+ Screen &display(std::ostream &os){

+ do_display(os);

+ return *this;

+ }

+ const Screen &display(std::ostream &os) const {

+ do_display(os);

+ return *this;

+ }

+ private:

+ pos cursor = 0;

+ pos height = 0,width = 0;

+ std::string contents;

+ mutable size_t access_ctr = 0;

+ void do_display(std::ostream &os) const {

+ os << contents;

+ }

+};

+

+inline Screen &Screen::move(pos r,pos c){

+ pos row = r * width;

+ cursor = row + c;

+ return *this;

+}

+

+char Screen::get(pos r,pos c) const {

+ pos row = r * width;

+ return contents[row + c];

+}

+

+size_t Screen::some_member() const{

+ ++access_ctr;

+ return access_ctr;

+}

+

+inline Screen &Screen::set(char c){

+ contents[cursor] = c;

+ return *this;

+}

+

+inline Screen &Screen::set(pos r,pos col,char ch){

+ contents[r*width+col] = ch;

+ return *this;

+}

+

+// 类数据成员的初始值

+class Window_mgr{

+ public:

+ using ScreenIndex = std::vector<Screen>::size_type;

+ void clear(ScreenIndex);

+ ScreenIndex addScreen(const Screen&);

+ private:

+ std::vector<Screen> screens{Screen(24,80,' ')};

+};

+

+void Window_mgr::clear(ScreenIndex i){

+ Screen &s = screens[i];

+ s.contents = string(s.height * s.width, ' ');

+}

+

+Window_mgr::ScreenIndex Window_mgr::addScreen(const Screen &s){

+ screens.push_back(s);

+ return screens.size() - 1;

+}

+

+int main(void){

+ Screen myscreen;

+ char ch = myscreen.get();

+ cout << myscreen.some_member() << endl;

+ ch = myscreen.get(0,0);

+ cout << myscreen.some_member() << endl;

+ myscreen.move(4,0);

+ myscreen.set('#');

+ cout << myscreen.get() << endl;

+ Screen myScreen(5,3,'!');

+ const Screen blank(5,3,'?');

+ myScreen.set(2,1,'#').display(cout);

+ cout << endl;

+ blank.display(cout);

+ cout << endl;

+ return 0;

+}构造函数初始值列表:定义变量的时候习惯对其立即进行初始化,有时初始化的值是必不可少的,且要注意成员初始化的顺序。

+委托构造函数:使用它所属类的其他构造函数执行它自己的初始化过程

+默认构造函数

+类类型转换

+聚合类:就是比较简单的结构体

+字面值常量类

+类的静态成员存在于任何对象之外,对象中不包含任何与静态数据成员有关的数据

+ + +C++ Primer - 第二部分 C++标准库

+ +iostream定义了用于读写流的基本类型

fstream定义了读写命名文件的类型

sstream定义了读写内存 string对象的类型

用法都是完全相同的,得益于继承机制

+流的状态:

+auto old_state = cin.rdstate(); // 获取流的当前状态

+cin.clear(); // 将所有条件状态复位,将流的状态置为有效

+cin.setstate(old_state); // 根据给定的标志位对流进行复位输出缓冲:每个输出流都管理一个缓冲区,保存程序读写的数据。

+控制输出缓冲:

+cout << "hi!" << endl; // 多输出一个换行符,然后刷新缓冲区

+cout << "hi!" << flush; // 输出后直接刷新缓冲区

+cout << "hi!" << ends; // 多输出一个空字符,然后刷新缓冲区

+cout << unitbuf; // 所有输出操作后都立即刷新缓冲区

+cout << nounitbuf; // 回到正常的缓冲方式关联输入和输出流:如果某一个输入流和输出流关联,则从输入流读取的操作会对这个输出流进行刷新。

+标准库将 cout和 cin关联在一起

cin.tie(&cerr); // 将cin和cerr关联在一起ifstream in("infile");

+ofstream output("outfile");

+string s;

+while(getline(in,s)){

+ output << s << endl;

+}

+return 0;显式打开或者关闭文件流:

+ofstream output; // 空文件流对象

+output.open("outfile"); // 调用open进行关联

+output.close(); // 关闭文件流文件模式:

+ofstream output("outfile");这种方式其实隐含了以输出模式打开文件并进行截断,显式控制如下:

+ofstream output("outfile",ofstream::out | ofstream::trunc);为了保留之前的文件内容,需要显式指定 app模式

ofstream output("outfile",ofstream::out | ofstream::app);ifstream in("infile");

+ofstream output("outfile",ofstream::out | ofstream::app);

+string s;

+while(getline(in,s)){

+ string a,b,c;

+ istringstream s1(s);

+ ostringstream s2;

+ s1 >> a;

+ s2 << a;

+ s1 >> b;

+ s2 << b;

+ s1 >> c;

+ s2 << c;

+ cout << s2.str() << endl;

+}

+return 0;一个容器就是一些特定类型对象的集合,顺序容器为程序员提供了控制元素存储和访问顺序的能力。

+vector是可变大小数组,支持快速随机访问。但是在尾部之外的位置插入或者删除元素可能很慢。

deque是双端队列,支持快速随机访问,在头尾部插入或者删除元素的速度很快。

list是双向链表,只支持双向顺序访问,在 list中任意位置进行插入/删除的速度都很快

forward_list是单向链表,只支持单向顺序访问,在链表中任意位置进行插入/删除的速度都很快

array是固定大小的数组,支持快速随机访问,不能添加或者删除元素

string是与 vector相似的容器,专门用于保存字符,随机访问快,在尾部插入/删除的速度很快

顺序容器几乎可以保存任意类型的元素

+各种迭代器:

+auto it1 = a.begin(); // list<string>::iterator

+auto it2 = a.rbegin(); // list<string>::reverse_iterator

+auto it3 = a.cbegin(); // list<string>::const_iterator

+auto it4 = a.crbegin(); // list<string>::const_reverse_iterator元素的拷贝初始化:

+list<string> a = {"Milton","SHakespeare","Austen"};

+list<string> a2(a);array具有固定的大小,并且可以进行拷贝

+array<int,10> ia1 = {0,1,2,3,4,5,6,7,8,9};

+array<int,10> ia2 = ia1;使用 assign对不同但相容的类型进行赋值

list<string> names;

+vector<const char*> oldstyle;

+names.assign(oldstyle.cbegin(),oldstyle.cend());添加元素三种方法:push_front(),insert(),push_back()

新标准对应了三种直接构造元素的方法:emplace_front()、emplace()、emplace_back()

更安全的访问元素的方法:svec.at(0)

改变容器大小并使用某个元素填充更大的部分:ilist.resize(15,-1)

管理容量的成员函数:

+c.capacity(); // 不重新分配内存空间的话最多能保存多少元素

+c.reserve(n); // 分配至少能容纳n个元素的内存空间

+c.shrink_to_fit() // 请求将capacity()减小为size()一样的大小数值转换:

+int i = 42;

+string s = to_string(i);

+double d = stod(s);

+cout << s << " " << d << endl;42 42对于容器的其他操作,并没有通过定义成员函数的方式实现,而是定义一套泛型算法,实现了一些算法的公共接口。

+在容器中对值进行查找使用 find,返回查找元素的指针的位置

auto result = find(vec.cbegin(),vec.cend(),val)返回元素在容器中出现的次数:

+vector<int> a;

+int temp;

+for(int i=0;i<10;i++){

+ cin >> temp;

+ a.push_back(temp);

+}

+cin >> temp;

+auto result = count(a.cbegin(),a.cend(),temp);

+cout << result << endl;泛型算法本身不会执行容器的操作,只会运行于迭代器之上,执行迭代器的操作。

+因此泛型算法永远不会改变底层容器的大小。

+元素求和:

+vector<int> a{1,2,3,4,5,6,7,8};

+int sum = accumulate(a.cbegin(),a.cend(),0);

+cout << sum << endl;36可以推广到字符串中用来连接字符串:

+vector<int> a{1,2,3,4,5,6,7,8};

+vector<string> b{"df","fsfds","rte"};

+string sum = accumulate(b.cbegin(),b.cend(),string(""));

+cout << sum << endl;dffsfdsrte确定两个序列中保存的值是否相同(假定第二个序列至少与第一个序列一样长)

+vector<int> a{1,2,3,4,5,6,7,8};

+vector<string> b{"df","fsfds","rte"};

+vector<string> c{"df","fsfds","rte","fdsf"};

+auto sum = equal(b.cbegin(),b.cend(),c.cbegin());

+cout << sum << endl;1使用 fill和 fill_n填充元素:

vector<int> a{1,2,3,4,5,6,7,8};

+fill(a.begin(),a.end(),0);

+for(auto i : a){

+ cout << i << " ";

+}

+cout << endl;

+fill_n(a.begin(),a.size(),1);

+for(auto i : a){

+ cout << i << " ";

+}

+cout << endl;0 0 0 0 0 0 0 0

+1 1 1 1 1 1 1 1算法是不会检查写操作的,泛型算法也不能更改容器的大小。因此需要自行检查容器是否越界等问题。

+安全的方式:插入迭代器

+vector<int> a{1,2,3,4,5,6,7,8};

+vector<string> b{"df","fsfds","rte"};

+vector<string> c{"df","fsfds","rte","fdsf"};

+fill_n(back_inserter(a),10,1);

+for(auto i : a){

+ cout << i << " ";

+}

+cout << endl;1 2 3 4 5 6 7 8 1 1 1 1 1 1 1 1 1 1将 a1的内容拷贝到 a2:copy(begin(a1),end(a1),a2)

对元素进行排序去重:

+vector<string> d{"the","quick","red","fox","jumps","over","the","slow","red","turtle"};

+sort(d.begin(),d.end()); // 排序

+auto end_unique = unique(d.begin(),d.end()); // 将重复的移到末尾,并同时返回最后一个不重复的元素的后一位置

+d.erase(end_unique,d.end()); // 使用容器操作删除重复的元素(因为泛型算法无法改变容器大小)

+for(auto i : d){

+ cout << i << " ";

+}

+cout << endl;fox jumps over quick red slow the turtlelambda表达式:

一个 lambda表达式表示一个可调用的代码单元,可以理解为一个未命名的内联函数。

auto f = []{return 42;};

+cout << f() << endl;42int a = 0, b = 1;

+auto f6 = [&a, &b]{ return a + b; };

+cout << f6() << endl;1lambda表达式还有其他的一些用法。

+插入迭代器:

+back_inserter:创建一个使用 push_back的迭代器

front_inserter:创建一个使用 push_front的迭代器

inserter:创建一个使用 insert的迭代器

list<int> lst = {1,2,3,4};

+list<int> lst2 = {5,6};

+list<int> lst3 = {9,10,11};

+list<int> lst4 = {12};

+copy(lst.cbegin(),lst.cend(),front_inserter(lst2));

+for(auto i : lst2){

+ cout << i << " ";

+}

+cout << endl;